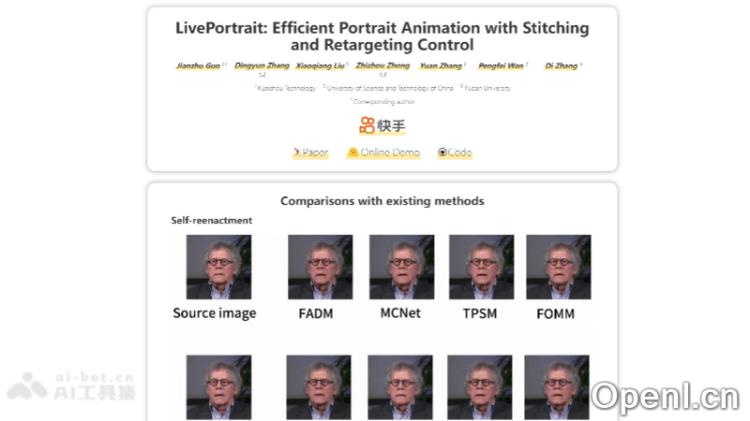

LivePortrait是什么

LivePortrait是快手推出的一款开源人像动画生成框架,旨在高效且灵活地将驱动视频中的表情和姿态转移至静态或动态人像,从而创造出极具表现力的视频内容。该技术依托隐式关键点框架,结合大规模高质量训练数据及混合训练策略,显著提升了模型的泛化能力与动作控制精度。在RTX 4090 GPU上,LivePortrait的单帧生成速度高达12.8毫秒,显示出卓越的处理效率,并且仍具备进一步的优化空间。开源社区对这一项目反响热烈,LivePortrait的GitHub页面提供了丰富的使用指南和资源。

LivePortrait的主要功能

- 表情与姿态转移:LivePortrait能够实时将驱动视频中的表情和姿态迁移至静态或动态人像,生成生动的动画效果。

- 高效生成:在RTX 4090 GPU上,框架的单帧生成速度达到12.8毫秒,展现出极高的处理速度。

- 强大的泛化能力:通过结合视频与图片的混合训练策略以及海量高质量训练数据,LivePortrait展现出良好的适应性,能够处理各种风格和身份的人像。

- 控制能力增强:采用隐式关键点和轻量级MLP网络,LivePortrait提升了对动画生成过程的控制能力。

- 多样风格支持:该框架能够处理多种风格的人像,包括真实人物及风格化(如动漫)人像。

- 高分辨率动画生成:支持生成高分辨率动画,提供更加清晰的视觉体验。

- 适应性模块:设计了贴合模块及眼部、嘴部重定向模块,以适应裁剪、多人合照等复杂场景,避免像素错位问题。

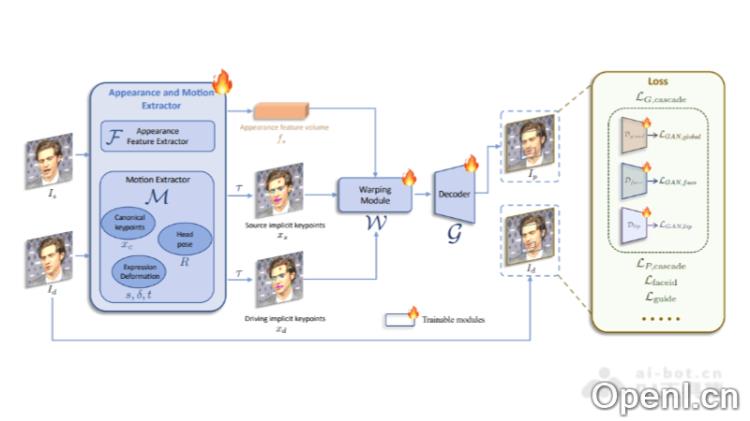

LivePortrait的技术原理

- 基础模型训练:初期阶段主要优化外观提取器、提取器、扭曲模块和解码器,模型从零开始训练。

- 拼接与重定向模块训练:在基础模型训练完成后,冻结外观提取器、提取器、扭曲模块和解码器,第二阶段专注于拼接和重定向模块的优化。

- 视频-图像混合训练:将每张图片视为视频片段,模型在视频和图片上同时训练,以提升泛化能力。

- 升级的网络结构:将隐式关键点估计网络、头部姿态估计网络和表情变形估计网络整合为一个单一模型,采用ConvNeXt-V2-Tiny结构,直接估计输入图片的隐式关键点、头部姿态和表情变形。

- 关键点引导的隐式关键点优化:引入2D关键点捕捉微表情,并用关键点引导的损失优化隐式关键点。

- 级联损失函数:采用face vid2vid的隐式关键点不变损失、关键点先验损失、头部姿态损失和变形先验损失,并结合感知和GAN损失来提升纹理质量。

LivePortrait的项目地址

- 项目官网:https://liveportrait.github.io/

- GitHub仓库:https://github.com/KwaiVGI/LivePortrait

- Hugging Face模型库:https://huggingface.co/spaces/KwaiVGI/LivePortrait

- arXiv技术论文:https://arxiv.org/pdf/2407.03168

LivePortrait的应用场景

- 社交媒体内容创作:用户可以将自己的照片或视频转换为动态内容,适用于社交媒体平台,增强互动性与吸引力。

- 虚拟主播与直播:利用LivePortrait技术,能够创建虚拟形象进行直播或视频制作,无需真人出镜,适用于游戏直播、教育讲解等场景。

- 影视与动画制作:在影视后期制作中,LivePortrait可用于角色表情捕捉与动画生成,提高制作效率,降低成本。

- 广告与营销:企业可以使用LivePortrait技术制作吸引人的广告视频,通过动态人物形象抓住潜在客户的眼球。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号