ExVideo是一项由阿里巴巴与华东师范大学的研究团队共同开发的视频合成模型后调优技术,旨在扩展现有模型的时间维度,从而生成更长和帧数更多的视频。基于Stable Video Diffusion模型,ExVideo能够生成高达128帧的连贯视频,同时有效保留原始模型的生成能力。这一技术特别适合计算资源有限的环境,因为它通过优化3D卷积、时间注意力机制和位置嵌入等技术模块,显著提高了视频帧数并降低了训练成本。

ExVideo是什么

ExVideo是由阿里巴巴与华东师范大学的研究者共同开发的一种先进的视频合成模型后调优技术。它能够在现有视频合成模型的基础上,扩展时间尺度,生成更加丰富的长视频。该团队在Stable Video Diffusion模型的基础上,训练出了一个能够生成多达128帧的扩展模型,同时保持了原始生成能力。ExVideo的设计通过优化各种时间模块,使得模型能够处理更长时间跨度的内容,适合资源有限的情况。

主要功能

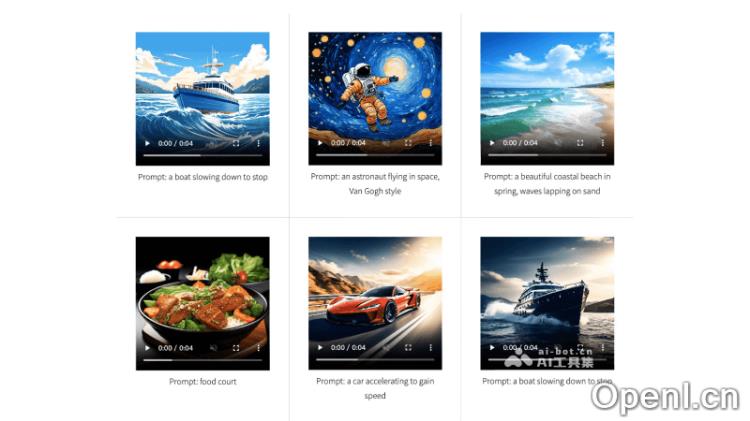

- 时间尺度扩展:ExVideo的主要功能是扩展视频合成模型的时间尺度,使其能够处理和生成比原始模型更长的视频序列,从而讲述更复杂的故事或展示更长时间的动态场景。

- 后调优策略:ExVideo的后调优策略是其核心,通过对Stable Video Diffusion等模型的特定部分进行再训练,ExVideo能够生成128帧或更多的视频,并保持对多种输入的泛化能力,提升视频的多样性和适应性。

- 高效参数使用:与传统训练方法相比,ExVideo采用后调优策略,无需重新训练整个模型,从而显著减少参数数量和计算资源,提高了模型的扩展效率。

- 生成质量保持:ExVideo在延长视频长度的同时,确保生成视频的质量,所生成的视频在视觉连贯性、清晰度和整体质量上均达到较高标准。

- 兼容性与通用性:ExVideo的设计考虑到与多种视频合成模型的兼容性,能够广泛应用于不同的视频生成任务,提供相应的扩展策略以适应不同的模型架构。

产品官网

- 官方项目主页:https://ecnu-cilab.github.io/ExVideoProjectPage/

- GitHub代码库:https://github.com/modelscope/DiffSynth-Studio

- Hugging Face模型下载:https://huggingface.co/ECNU-CILab/ExVideo-SVD-128f-v1

- ModelScope模型下载:https://www.modelscope.cn/models/ECNU-CILab/ExVideo-SVD-128f-v1/summary

- arXiv技术论文:https://arxiv.org/abs/2406.14130

应用场景

ExVideo适用于多种视频生成任务,包括但不限于短视频创作、动画制作、广告视频生成等。它的高效性和生成能力使其成为内容创作者、广告行业和教育领域等多个行业的理想选择,帮助用户生成更具吸引力和连贯性的视频内容。

常见问题

- ExVideo的训练成本高吗?

ExVideo采用后调优策略,相比从头训练模型,显著降低了训练成本,特别适合计算资源有限的环境。 - 生成的视频质量如何?

ExVideo确保在扩展视频长度的同时,保持高质量的生成,视频在视觉连贯性和清晰度上都达到较高标准。 - 我可以在什么地方获取ExVideo的模型?

ExVideo的模型可以通过Hugging Face和ModelScope等平台进行下载,具体链接可以在产品官网上找到。 - ExVideo支持哪些视频合成模型?

ExVideo设计时考虑到与多种视频合成模型的兼容性,能够广泛应用于不同的模型架构。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号