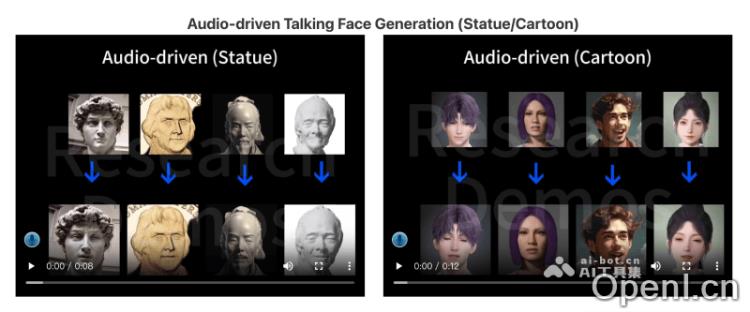

AniTalker是一个创新的对口型视频生成框架,由上海交通大学X-LANCE实验室与思必驰AISpeech的研究团队共同开发。它能够将单张静态人像与输入的音频结合,生成栩栩如生的动画对话视频。该框架运用了自监督学习策略,可以捕捉面部的复杂动态,包括细微的表情和头部动作,显著降低了对标记数据的需求。同时,AniTalker结合了扩散模型与方差适配器技术,生成多样化且可控的面部动画,效果接近阿里EMO和腾讯AniPortrait。

AniTalker是什么

AniTalker是一个先进的对口型视频生成工具,旨在通过将单张静态人脸肖像与音频信号相结合,创造出生动的动画对话。该框架依靠自监督学习来捕捉面部动态,展现丰富的表情变化和头部动作。AniTalker通过通用表示和身份解耦技术,减少了对标记数据的依赖,并结合扩散模型与方差适配器,生成多样化而可控的面部动画,达到自然的对话效果。

AniTalker的主要功能

- 静态肖像动画化:AniTalker可以将任意一张静态人脸图像转换为动态视频,展现说话和表情变化。

- 音频同步:该框架能够将输入的音频与人物的唇动和语音节奏完美同步,实现自然流畅的对话效果。

- 面部动态捕捉:AniTalker不仅支持唇动同步,还能够模拟复杂的面部表情和细微的肌肉动作。

- 多样化动画生成:通过扩散模型,AniTalker生成的面部动画具有随机变化,增强了生成内容的自然性和不可预测性。

- 实时面部动画控制:用户可以通过控制信号实时调整动画生成,包括头部姿势、面部表情和眼睛等。

- 语音驱动的动画生成:该框架支持直接使用语音信号生成动画,无需额外的视频输入。

- 长视频连续生成:AniTalker可以持续生成长时间的动画视频,适用于对话或演讲等场景。

AniTalker的官网入口

- 官方项目主页:https://x-lance.github.io/AniTalker/

- GitHub源码库:https://github.com/X-LANCE/AniTalker

- arXiv研究论文:https://arxiv.org/abs/2405.03121

AniTalker的工作原理

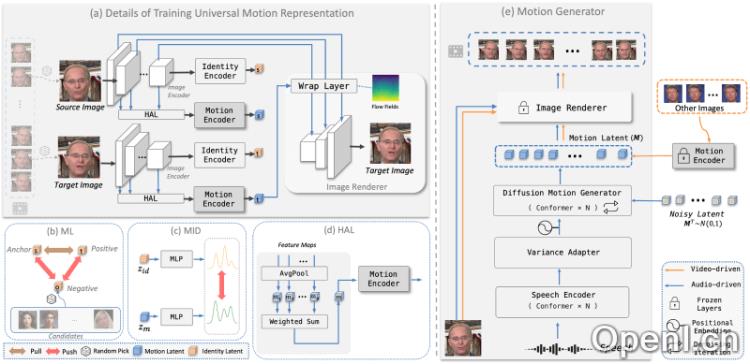

- 表示学习:AniTalker采用自监督学习方法训练编码器,捕捉面部动态。这一过程涉及从视频中提取源图像与目标图像,通过重建目标图像来学习信息。

- 身份与解耦:为确保表示不包含身份信息,AniTalker利用度量学习和互信息最小化技术。度量学习帮助模型区分不同个体的身份特征,而互信息最小化确保编码器专注于而非身份。

- 分层聚合层(HAL):引入HAL(Hierarchical Aggregation Layer),增强编码器对不同尺度变化的理解能力,通过平均池化层和加权和层整合来自图像编码器不同阶段的信息。

- 生成:训练完成后,AniTalker能够基于用户控制的信号生成表示,包括视频驱动和语音驱动两种管道。

- 视频驱动管道:使用驱动者的视频序列为源图像生成动画,精确复制驱动的姿势和表情。

- 语音驱动管道:与视频驱动不同,语音驱动方法依赖语音信号或其他控制信号生成视频,实现与输入音频的同步。

- 扩散模型和方差适配器:在语音驱动方法中,AniTalker使用扩散模型生成潜在序列,并通过方差适配器引入属性操作,产生多样化和可控的面部动画。

- 渲染模块:最后,利用图像渲染器根据生成的潜在序列逐帧渲染最终动画视频。

- 训练和优化:AniTalker的训练过程包括多个损失函数,如重建损失、感知损失、对抗损失、互信息损失和身份度量学习损失,以优化模型性能。

- 控制属性特征:AniTalker允许用户调整头部姿态和相机参数,如头部位置和面部大小,以生成特定属性的动画。

AniTalker的应用场景

- 虚拟助手和客服:AniTalker能够生成逼真的虚拟形象,用于虚拟助手或在线客服,提升交互体验的自然度与亲和力。

- 电影和视频制作:在电影后期制作中,AniTalker可用于生成或编辑演员的面部表情及动作,尤其在捕捉原始表演时难以实现的场景。

- 游戏开发:游戏开发者可以利用AniTalker为角色创建真实的面部动画,增强游戏的沉浸感和角色表现力。

- 视频会议:在视频会议中,AniTalker可为参与者生成虚拟面孔,适合需要保护隐私或增添趣味的场合。

- 社交媒体:用户可以借助AniTalker创建个性化的虚拟形象,在社交媒体上进行互动与分享。

- 新闻播报:AniTalker可以生成虚拟新闻主播,用于自动化新闻播报,特别是在多语言播报的需求下。

- 广告和营销:企业可利用AniTalker生成引人注目的虚拟角色,用于广告宣传或品牌代言。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号