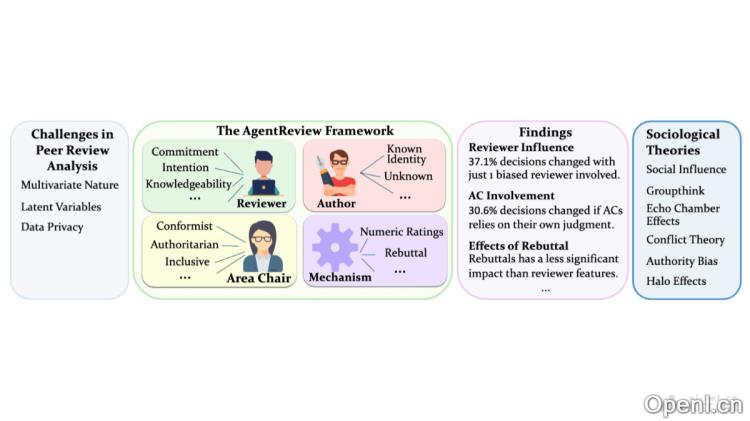

AgentReview是一种先进的框架,旨在模拟学术同行评审的过程,采用大型语言模型(LLM)作为核心技术。该工具通过模拟评审者、作者和领域主席的角色,帮助研究人员在不隐私的前提下,深入探讨评审偏见及决策过程对评审结果的影响。AgentReview致力于为同行评审机制的改进提供有价值的见解,支持未来的研究工作。

AgentReview是什么

AgentReview是一个基于大型语言模型(LLM)的创新框架,专门设计用于模拟学术领域的同行评审流程。通过模拟评审者、作者和领域主席这三种角色,AgentReview能够在保护隐私的基础上,深入研究评审中的各种偏见、角色及决策机制对结果的影响,进而为提升同行评审的效率和公正性提供重要思路。

AgentReview的主要功能

- 同行评审过程模拟:AgentReview能够精确模拟真实的学术评审过程,涵盖评审者的评估、作者的反馈、评审者之间的讨论以及领域主席的决策等多个环节。

- 角色模拟:该框架整合了评审者、作者和领域主席(AC)三种角色,每种角色都由LLM代理驱动,展现独特的行为特征。

- 多变量分析:通过模拟,AgentReview探索并识别出影响评审结果的多个变量,包括评审者的承诺、意图、知识水平以及AC的决策风格。

- 隐私保护:在整个模拟过程中,AgentReview确保评审数据的隐私性,不需要使用真实的敏感数据。

- 社会学理论验证:AgentReview验证社会影响理论、利他主义疲劳、群体思维和权威偏见等社会学理论在同行评审中的实际应用。

AgentReview的技术原理

- 大型语言模型(LLM):AgentReview基于LLM构建,利用其卓越的语言理解与生成能力来模拟评审者和作者的行为。

- 代理建模:该框架中的每个角色(评审者、作者、AC)都被定义为具有特定属性和行为的代理,能够根据设定的特性与规则进行互动。

- 结构化评审流程:AgentReview遵循一个结构化的五阶段评审流程,从初步评审到最终决策,全面模拟评审的过程。

- 自定义与扩展性:框架设计灵活,可扩展,支持研究人员根据具体需求自定义角色属性和评审流程。

- 数据驱动的洞察:通过大规模的模拟生成数据,AgentReview提供统计显著的洞察,支持内容及数值分析。

AgentReview的项目地址

- 项目官网:agentreview.github.io

- GitHub仓库:https://github.com/Ahren09/AgentReview

- HuggingFace模型库:https://huggingface.co/spaces/Ahren09/AgentReview

- arXiv技术论文:https://arxiv.org/pdf/2406.12708

- 在线体验Demo:https://huggingface.co/spaces/Ahren09/AgentReview

AgentReview的应用场景

- 学术期刊和会议管理:用于优化和管理学术论文的同行评审流程,提高评审的质量与效率。

- 评审者培训与发展:作为教育工具,帮助新评审者了解评审标准和最佳实践。

- 社会学和心理学研究:通过模拟验证社会影响、群体思维等理论在评审行为中的应用。

- 跨学科评审研究:比较不同学科之间的评审标准和流程,为跨学科期刊的设计提供参考。

- 政策制定与评估:辅助政策制定者评估和制定与同行评审相关的政策与指导方针。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号