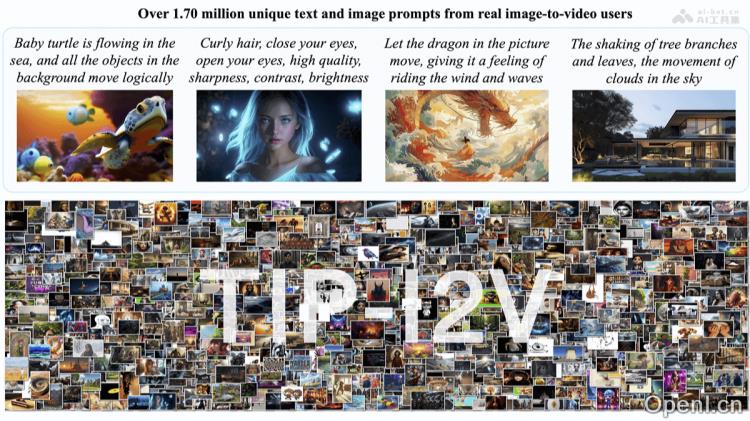

TIP-I2V是一款创新的图像到视频生成数据集,专为推动该领域的研究与应用而设计。它包含超过170万条独特的用户文本及图像提示,结合五种最先进的图像生成视频模型生成的相应视频。该数据集旨在促进图像到视频模型的安全性与有效性,帮助研究人员深入分析用户需求,评估模型表现,并应对图像到视频生成可能引发的错误信息问题。

TIP-I2V是什么

TIP-I2V是一个庞大的真实文本和图像提示数据集,主要用于图像转视频的生成研究。该数据集汇集了超过170万条独特的用户提交内容,以及五种领先的图像到视频生成模型所生成的视频。TIP-I2V的推出旨在推动更为高效及安全的图像到视频生成模型的发展,助力研究人员分析用户的偏好,评估模型性能,并解决相关的错误信息传播问题。

TIP-I2V的主要功能

- 用户偏好分析:通过研究用户提交的文本和图像提示,帮助研究人员更好地理解用户在图像到视频生成方面的需求与偏好。

- 模型性能评估:建立一个平台,使研究人员能够基于真实用户数据评估和比较不同的图像到视频生成模型的表现。

- 安全性与错误信息研究:为研究人员提供工具,以解决图像到视频生成过程中可能产生的误导性信息问题,避免虚假内容的传播。

TIP-I2V的技术原理

- 数据采集:从Pika Discord频道及其他来源收集超过170万条文本和图像提示以及相应的视频生成结果。

- 多模型集成:整合五种不同的图像到视频扩散模型(如Pika、Stable Video Diffusion、Open-Sora、I2VGen-XL和CogVideoX-5B),提供丰富多样的数据。

- 元数据标注:为每个数据点赋予UUID、时间戳、主题、NSFW状态、文本及图像嵌入等元数据,以便于后续的分析和应用。

- 语义分析:利用自然语言处理技术(如GPT-4o),对文本提示中的动词进行分析,并通过HDBSCAN聚类算法识别和排序最受欢迎的主题。

- 视频生成技术:应用扩散模型技术,将静态图像转化为连贯的视频内容,提升生成效果。

- 安全性与验证:开发和评估用于识别生成视频及追踪视频源图像的模型,以防止视频被误用传播错误信息。

TIP-I2V的项目地址

- 项目官网:tip-i2v.github.io

- GitHub仓库:https://github.com/WangWenhao0716/TIP-I2V

- HuggingFace模型库:https://huggingface.co/datasets/WenhaoWang/TIP-I2V

- arXiv技术论文:https://arxiv.org/pdf/2411.04709

TIP-I2V的应用场景

- 内容创作与娱乐:艺术家可以轻松将静态作品转换为动态视频,以用于展览或线上画廊展示。

- 广告与营销:营销团队能够将产品图像制作成引人注目的视频广告,提升在线广告的点击率。

- 教育与培训:教育机构可以将复杂的科学概念图像转化为易于理解的动画视频,辅助教学过程。

- 新闻与报道:新闻机构能够将现场照片转换为视频,以便为观众提供更直观的新闻报道体验。

- 艺术与设计:数字艺术家能够将静态艺术作品转化为动态展示,创造出全新的艺术体验。

常见问题

- TIP-I2V数据集的获取方式是什么?:可以通过项目官网和GitHub仓库获取数据集的详细信息和下载链接。

- TIP-I2V的使用限制是什么?:用户需遵循数据集的使用条款,确保不将生成的视频用于误导性内容传播。

- 如何参与TIP-I2V的研究?:研究人员可通过官网了解最新的研究进展及合作机会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号