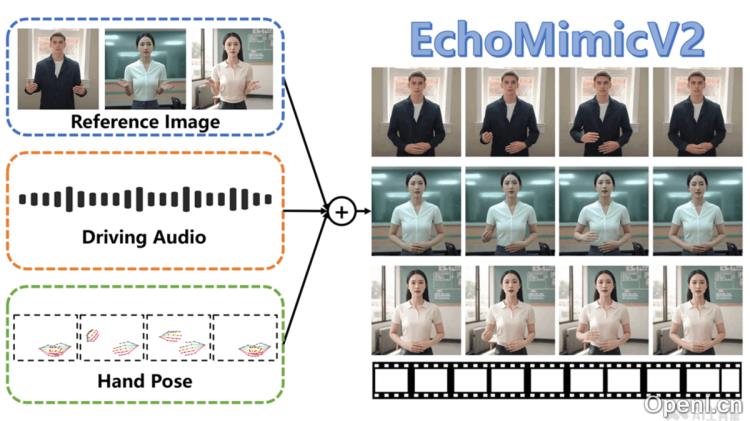

EchoMimicV2是一款由蚂蚁集团开发的先进半身数字人动画生成工具。它基于参考图片、音频剪辑和手部姿势序列,能够高效生成高质量的动画视频,确保音频内容与动画之间的完美契合。相比于前代产品EchoMimicV1,EchoMimicV2在生成逼真的人头动画的基础上,进一步扩展到了完整的半身动画,能够实现中英文语音与动作之间的无缝转换。

EchoMimicV2是什么

EchoMimicV2是蚂蚁集团推出的一种半身数字人动画生成技术。它通过结合参考图片、音频剪辑和手势序列,生成高质量的动画视频,确保音频与动画动作的一致性。EchoMimicV2在前版本的基础上进行升级,现已能够生成完整的半身动画,支持中英文语音的无缝转换。其技术包括音频-姿势动态协调策略,利用姿势采样和音频扩散,增强细节表现力,并减少冗余条件。此外,EchoMimicV2采用头部局部注意力技术整合头部数据,并设计特定阶段的去噪损失,优化动画的整体质量。

EchoMimicV2的主要功能

- 音频驱动动画生成:通过音频剪辑驱动角色的面部表情和身体动作,实现音频与动画的完美同步。

- 半身动画制作:扩展了从仅生成头部动画到生成完整上半身动画的能力。

- 简化控制条件:减少动画生成过程中所需的复杂条件,使动画制作更加简便。

- 手势与表情同步:结合手部姿势序列与音频,生成自然且协调的手势和面部表情。

- 多语言支持:支持中文和英文音频,能够根据不同语言内容生成相应的动画。

EchoMimicV2的技术原理

- 音频-姿势动态协调(APDH):

- 姿势采样(Pose Sampling):逐步减少对姿势条件的依赖,使音频条件在动画生成中扮演更重要的角色。

- 音频扩散(Audio Diffusion):将音频条件的影响从嘴唇扩散到整个面部,再到全身,增强音频与动画的同步性。

- 头部局部注意力(Head Partial Attention,HPA):在训练过程中整合头部数据,提升面部表情的细节表现,无需额外插件或模块。

- 特定阶段去噪损失(Phase-specific Denoising Loss,PhD Loss):将去噪过程分为姿势主导、细节主导和质量主导三个阶段,每个阶段均有特定优化目标。

- 潜在扩散模型(Latent Diffusion Model,LDM):利用变分自编码器(VAE)将图像映射到潜在空间,在训练过程中逐步添加噪声,并对每个时间步的噪声进行估计和去除。

- 基于ReferenceNet的骨干网络:通过ReferenceNet从参考图像中提取特征,并将其注入去噪U-Net中,保持生成图像与参考图像之间的一致性。

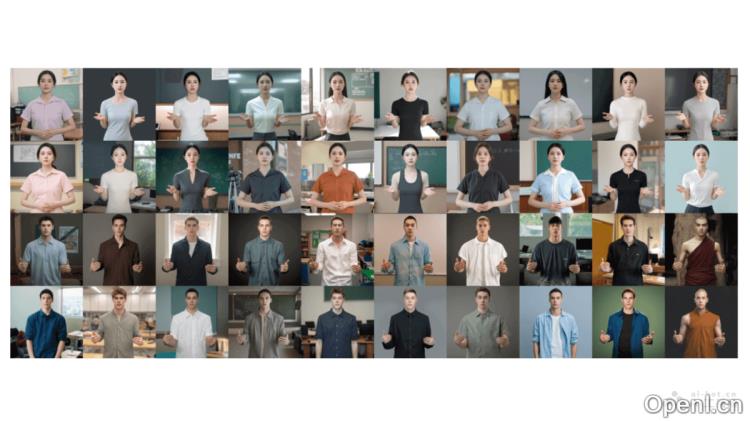

EchoMimicV2的生成效果展示

- 效果一:中文音频驱动

- 效果二:英文音频驱动

- 效果三:FLUX生成的参考图像

EchoMimicV2的项目地址

- 项目官网:antgroup.github.io/ai/echomimic_v2

- GitHub仓库:https://github.com/antgroup/echomimic_v2

- HuggingFace模型库:https://huggingface.co/BadToBest/EchoMimicV2

- arXiv技术论文:https://arxiv.org/pdf/2411.10061

EchoMimicV2的应用场景

- 虚拟主播:用于创建虚拟新闻主播或直播主持人,支持中文和英文直播,提升内容生产效率与多样性。

- 在线教育:可以制作虚拟教师或讲师,提供丰富的在线课程与培训资源,增强教育的可及性。

- 娱乐与游戏:在游戏中生成逼真的非玩家角色(NPC),提供更自然流畅的互动体验。

- 电影与视频制作:在动作捕捉和后期制作中应用,减少实际拍摄的成本与复杂性,提高制作效率。

- 客户服务:作为虚拟客服代表,提供多语言客户支持,提升服务质量与响应速度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号