大规模多模态模型训练细节~

原标题:LLM+Diffusion方案是否值得持续投入?生成+理解一体多模态大模型的思考

文章来源:智猩猩GenAI

内容字数:2816字

2024中国生成式AI大会(上海站)预告

根据大会预告,2024中国生成式AI大会将于12月5日至6日在上海举办。本次大会由智猩猩共同主办,许多知名嘉宾已确认参会演讲,包括北大(临港)大模型对齐中心执行主任徐骅,腾讯优图实验室负责人吴贤等30+位专家。欢迎感兴趣的朋友报名参加。

多模态大模型方案概述

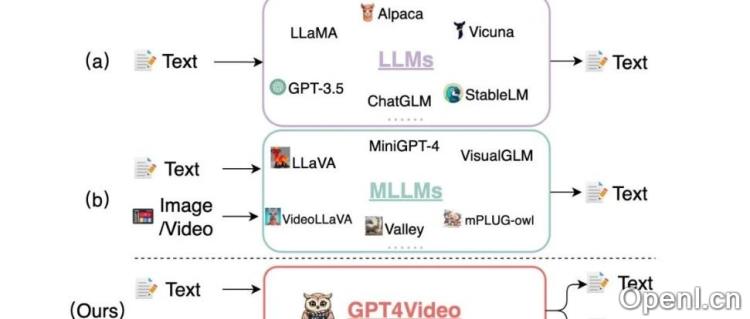

当前的多模态大模型主要分为以下几种方案:

- 以语言模型为核心:

- Emu3:支持视频、图像和文本任务,采用纯自回归(AR)损失。

- Chameleon:专注于图像和文本任务,同样使用纯AR损失。

- Show-o:图像部分使用双向注意力,文字部分为AR损失。

- Janus:结合两种视觉编码器,文本和图像均为纯AR损失。

- 语言模型+扩散模型:

- TransFusion:文字部分使用AR损失,图像部分使用DDPM损失。

- JanusFlow:文字部分AR损失,图像部分使用RF损失。

共性结论与未来方向

不同方案的共性结论如下:

- 以LLM为核心的架构在训练和推理阶段易于扩展,但效果尚未达到顶尖水平。

- 在模型尺寸相当的情况下,加入扩散模型的视觉生成效果优于纯LLM架构。

- 视觉编码器的发展仍然主要分为理解与生成两类,且在各自任务上表现优异。

大规模多模态模型的训练细节

关于大规模多模态模型的训练,以下是一些关键细节:

- Chameleon在从零开始训练中分享了多项稳定。

- Emu3分享了预训练、后训练及DPO的一些细节。

- Janus系列文章探讨了训练框架和效率提升的方法。

未来研究方向

未来的研究方向包括:

- 如何统一生成与理解的视觉编码器,并在大规模多模态模型上实现有效应用。

- 视觉生成与理解任务在基础模型层面如何统一,以及相应的代理任务和损失设计。

- LLM与扩散模型结合的长期投资价值,尤其是在解决误差累积问题上。

总结来看,2024中国生成式AI大会将为与会者提供丰富的技术共享与讨论平台,期待更多研究者和技术人员的参与与交流。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下矩阵账号之一,聚焦大模型开启的通用人工智能浪潮。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号