SAM 2.1(Segment Anything Model 2.1)是Meta(Facebook的母公司)推出的一款前沿视觉分割模型,旨在对图像和视频进行精准的分割处理。该模型基于高效的Transformer架构,并结合流式记忆机制,实现实时视频流的处理。相比于前一版本,SAM 2.1引入了数据增强技术,显著提升了对视觉相似物体及小物体的识别能力,同时增强了对遮挡情况的处理效果。此外,Meta还开源了SAM 2的开发者工具包,包括训练代码及网络演示的前后端代码,让用户能够轻松使用和微调该模型。

SAM 2.1是什么

SAM 2.1(全称Segment Anything Model 2.1)是由Meta推出的一种先进的视觉分割模型,专为图像与视频处理而设计。它采用简单的Transformer架构和流式记忆设计,能够实现实时视频处理。此版本在前作的基础上加入了数据增强技术,改善了对视觉相似物体和小物体的识别能力,同时增强了对遮挡现象的处理。此外,Meta还提供了SAM 2的开发工具包,包括训练代码和网络演示的前后端代码,以便用户进行使用和模型微调。

SAM 2.1的主要功能

- 图像与视频分割:能够对图像和视频中的不同对象和元素进行视觉分割与识别。

- 实时视频处理:依靠流式记忆和Transformer架构,支持对视频流的实时处理。

- 用户交互式分割:通过用户的点击或框选,实现交互式地对图像和视频内对象进行分割。

- 多对象跟踪:能够在视频序列中同时跟踪多个对象,并为每个对象生成相应的分割掩码。

- 数据增强:采用数据增强技术,提高模型对视觉相似物体及小物体的识别能力。

- 遮挡处理:通过改进位置编码和训练策略,增强了对遮挡情况的处理能力。

SAM 2.1的技术原理

- Transformer架构:SAM 2.1利用Transformer架构,这是一种高效的注意力机制模型,能够处理序列数据,如图像和视频帧。

- 流式记忆:为了更好地处理视频数据,SAM 2.1引入流式记忆机制,使模型在处理视频帧时能够保持对之前帧的记忆,从而更好地理解场景的动态变化。

- 数据增强技术:通过模拟视觉相似物体和小物体的数据增强技术,提高了模型在识别难以识别物体时的能力。

- 位置编码:改进的空间和物体指向记忆的位置编码,帮助模型更有效地理解物体的空间位置以及它们之间的交互。

SAM 2.1的项目地址

- 项目官网:https://ai.meta.com/blog/fair-news-segment-anything-2-1-meta-spirit-lm-layer-skip-salsa-sona/

- GitHub仓库:https://github.com/facebookresearch/sam2

SAM 2.1的应用场景

- 内容创作与编辑:在视频编辑过程中,支持动态背景替换,使视频制作更加灵活高效。

- 增强现实(AR)和虚拟现实(VR):在AR应用中,实现精确的物体识别和交互,提升用户体验。

- 医疗影像分析:辅助医学诊断,自动识别医学图像中的病变区域,提高诊断的准确性。

- 自动驾驶与机器人技术:提升自动驾驶系统的环境感知能力,确保行驶安全。

- 安全监控:在公共场所进行人流统计及异常行为检测,提高公共安全。

常见问题

- SAM 2.1支持哪些平台? SAM 2.1可以在多种平台上运行,具体取决于用户的需求和开发环境。

- 如何开始使用SAM 2.1? 用户可以通过访问项目官网和GitHub仓库获取相关的文档和代码,按照说明进行安装和配置。

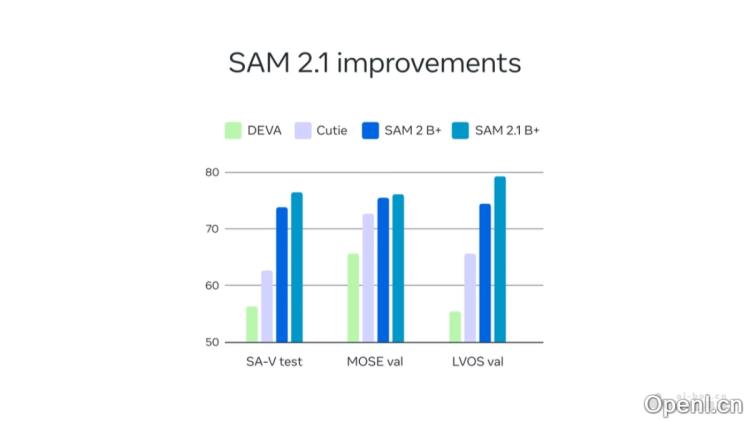

- SAM 2.1的性能如何? SAM 2.1在多个基准测试中表现出色,尤其是在处理复杂图像和视频时。

- 是否可以对模型进行微调? 是的,Meta提供了开源的开发者工具包,用户可以根据自己的数据集对模型进行微调。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号