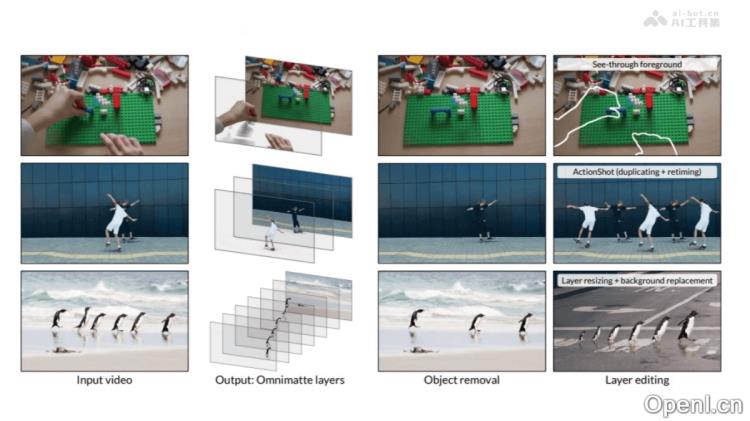

Generative Omnimatte 是一种由 Google DeepMind 等机构开发的先进视频编辑技术,能够将视频智能化地分解为多个透明背景的 RGBA 图层。每个图层都对应一个物体及其相关效果(如阴影和反射),而无需依赖绿幕或深度信息。这种技术可以实现物体与背景的精确分离,甚至能够处理被遮挡的部分,极大提升了视频编辑的灵活性和创意空间。

Generative Omnimatte是什么

Generative Omnimatte 是一项前沿的视频编辑工具,旨在将视频内容分解为多个透明背景的 RGBA 图层。每个图层代表一个物体及其相关效果,如阴影和反射。该技术无需绿幕或深度信息,即可实现物体与背景的清晰分离,甚至对被遮挡的部分进行处理。其核心是名为“Casper”的视频扩散模型,能够精准擦除视频中的物体及其阴影,同时保留背景的完整性。用户可以轻松实现各种创意效果,包括瞬移、改变速度,甚至时间倒流。

Generative Omnimatte的主要功能

- 视频分层:将视频内容拆分为多个 RGBA 层,每个层都包含一个完全可见的对象及其相关效果,如阴影和反射。

- 视频编辑:支持用户进行广泛的视频编辑操作,包括移除对象和效果、替换背景等。

- 动态背景处理:能够有效处理动态背景,避免前景对象与背景元素的交叠。

- 多对象场景处理:有效处理包含多个对象的场景,包括相似对象的隔离和效果关联。

- 用户指定的 Trimask:允许用户使用指定的 Trimask 精确控制视频编辑过程中保留和移除的区域。

Generative Omnimatte的技术原理

- 对象效应移除模型 Casper:通过输入视频和二进制对象掩码,Casper 模型能够生成干净的背景和一系列单一对象(solo)视频,应用不同的 Trimask 条件。

- Trimask 条件:Trimask 指定保留(白色)、移除(黑色)和可能包含不确定对象效应(灰色)的区域,有助于精准处理多对象场景。

- 测试时优化:在后续阶段,通过测试时优化,从 solo 视频和背景视频对中重建 Omnimatte 层。

- 训练数据:通过多个数据集(Omnimatte、Tripod、Kubric 和 Object-Paste)训练模型,提供真实视频因果关系的示例,增强模型处理多对象场景的能力。

- 自注意力分析:基于 Lumiere 模型的自注意力模式分析,研究文本到视频(T2V)模型对对象效应关联的内在理解,从而训练出有效的对象效应移除模型。

Generative Omnimatte的项目地址

Generative Omnimatte的应用场景

- 电影和视频制作:在电影制作中,去除不必要的背景元素或替换背景,以实现特效场景的无缝合成。

- 视频编辑和后期制作:视频编辑者可以分离视频中的对象和背景,实现颜色校正、特效添加等创意编辑。

- 广告制作:在广告中,替换产品背景或移除拍摄中的干扰元素,以突出产品。

- 虚拟现实和增强现实:在 VR 和 AR 应用中,将现实视频内容与虚拟元素结合,提供更具沉浸感的体验。

- 游戏开发:在游戏制作中,创建复杂的游戏环境,将现实世界的元素与虚拟游戏世界无缝融合。

常见问题

- Generative Omnimatte的使用难度大吗?:Generative Omnimatte 设计为用户友好,提供直观的界面,适合各种水平的用户。

- 需要哪些硬件要求?:为了获得最佳性能,建议使用高性能的图形处理单元(GPU)和充足的内存。

- 支持哪些视频格式?:Generative Omnimatte 支持多种常见视频格式,具体细节可参考项目官网。

- 是否可以用于实时视频处理?:目前主要针对预先录制的视频,实时处理功能正在研发中。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号