AI 在 药物发现 和 机器人技术 方面都有了突破性的进展,也正在让我们与机器和网络之间的交互方式产生翻天覆地的变化。

人工智能的机制可解释性研究进展

近年来,人工智能(AI)在药物发现和机器人技术等领域取得了显著进展,同时也改变了我们与机器和网络的交互方式。然而,对这些 AI 模型的工作原理和表现机制仍然缺乏深入了解。谷歌 DeepMind 的研究团队正在探索一种名为“机制可解释性”的方法,旨在揭示 AI 背后的秘密。

新工具 Gemma Scope 的推出

DeepMind 于七月底发布了 Gemma Scope,这是一个帮助研究人员理解 AI 输出生成过程的工具。该工具旨在通过分析模型内部来提高对 AI 系统的控制,进而开发出更优秀的 AI 模型。团队负责人 Neel Nanda 表示,了解模型的思维过程将有助于改进 AI 的应用。

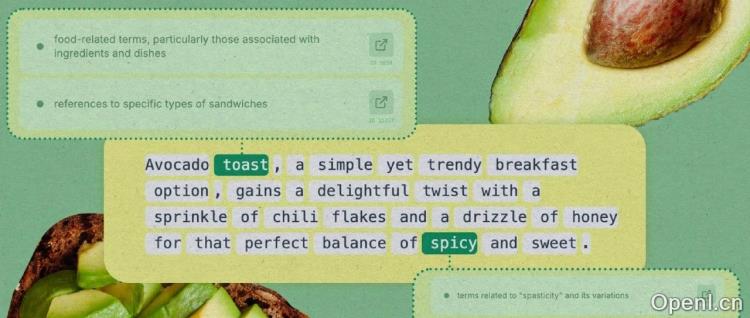

稀疏自动编码器的应用

DeepMind 通过在 AI 模型 Gemma 的每一层运行“稀疏自动编码器”,来提取代表更大概念的特征。稀疏自动编码器如同显微镜,能够放大并观察模型内部细节。它限制了神经元的使用数量,以更高效地展示数据特征,帮助研究人员理解 AI 如何响应特定输入。

研究者的探索与发现

Neuronpedia 平台与 DeepMind 合作,提供了一个体验版 demo,允许用户测试不同的提示并观察模型的特征激活情况。通过调试,研究者可以发现模型的反应与特定概念的关联,如“难堪”特征的激活情况。尽管有些特征更易追踪,但识别模型中的错误部分仍然是一个挑战。

机制可解释性的未来应用

机制可解释性研究的潜在应用广泛。研究者利用稀疏自动编码器,发现特定模型将某些职业与性别相关联的特征,从而减少偏见。这项研究的成功在小规模模型上完成,但其适用性尚待验证。此外,研究者希望通过更深入的理解来避免 AI 在特定情况下输出错误的信息。

总结

尽管机制可解释性研究仍面临挑战,但它为理解 AI 的内部逻辑和改进模型提供了新的思路。随着研究的深入,未来可能会实现对 AI 输出的精细控制,从而确保其表现符合预期。

联系作者

文章来源:AI前线

作者微信:

作者简介:面向AI爱好者、开发者和科学家,提供大模型最新资讯、AI技术分享干货、一线业界实践案例,助你全面拥抱AIGC。

粤公网安备 44011502001135号

粤公网安备 44011502001135号