产品名称:DrivingDojo

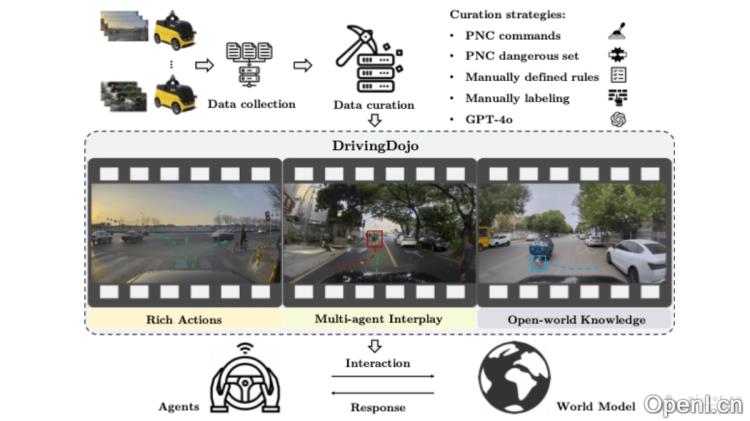

产品简介:DrivingDojo是中国科学院自动化研究所与美团无人车团队合作推出的数据集,用在训练和研究复杂的自动驾驶交互式世界模型。数据集包含18,000个视频片段,覆盖完整的驾驶操作、多智能体交互以及丰富的开放世界驾驶知识,为开发下一代自动驾驶模型提供了坚实的基础。

详细介绍:

DrivingDojo是什么

DrivingDojo是中国科学院自动化研究所与美团无人车团队合作推出的数据集,用在训练和研究复杂的自动驾驶交互式世界模型。数据集包含18,000个视频片段,覆盖完整的驾驶操作、多智能体交互以及丰富的开放世界驾驶知识,为开发下一代自动驾驶模型提供了坚实的基础。DrivingDojo定义了动作指令跟随(AIF)基准,用在评估世界模型在执行动作控制的未来预测方面的能力。

DrivingDojo的主要功能

- 交互式世界模型训练:DrivingDojo提供一个平台,用在训练理解和模拟复杂驾驶动态的交互式世界模型。

- 动作指令跟随(AIF):数据集定义AIF基准,评估世界模型在遵循动作指令生成未来预测的能力。

- 多样化驾驶操作:基于DrivingDojo-Action子集,模型学习加速、减速、紧急制动和车道变换等多样化的驾驶操作。

- 多智能体交互:用DrivingDojo-Interplay子集,模型能理解和预测车辆与其他道路使用者之间的复杂交互。

- 开放世界知识:用DrivingDojo-Open子集,模型学习处理开放世界中的罕见和长尾场景。

- 视频生成与预测:模型基于初始帧和动作指令生成未来的视频,模拟和预测驾驶场景。

DrivingDojo的技术原理

- 数据收集:用美团无人车团队的自动驾驶车辆平台收集视频数据,。

- 数据策划:从大量收集的数据中精选出包含丰富驾驶操作、多智能体交互和开放世界知识的视频片段。

- 动作编码:将驾驶动作(如加速、制动、转向)编码为模型能理解的格式,方便在视频生成中使用。

- 视频生成模型:基于如Stable Video Diffusion等技术,开发从初始帧和动作指令生成视频的模型。

- 动作指令跟随(AIF):比较生成视频与输入动作指令的一致性,评估模型的预测准确性。

- 评估指标:用FID(Frechet Inception Distance)和FVD(Frechet Video Distance)等指标评估生成视频的视觉质量,用AIF错误评估动作指令的跟随能力。

DrivingDojo的项目地址

- 项目官网:drivingdojo.github.io

- GitHub仓库:https://github.com/Robertwyq/Drivingdojo

- HuggingFace模型库:https://huggingface.co/datasets/Yuqi1997/DrivingDojo

- arXiv技术论文:https://arxiv.org/pdf/2410.10738

DrivingDojo的应用场景

- 自动驾驶算法开发:研究人员开发和测试自动驾驶车辆的感知、预测和决策算法。

- 世界模型训练:数据集用在训练模拟真实世界驾驶环境的交互式世界模型,模型能预测未来的状态和可能的。

- 多智能体交互模拟:模拟车辆与其他道路使用者(如行人、自行车、其他车辆)之间的交互,优化自动驾驶车辆的交互策略。

- 罕见和长尾场景处理:训练模型识别和响应罕见,如动物突然横穿道路或道路上的障碍物,提高自动驾驶系统的安全性。

- 虚拟测试和验证:在虚拟环境中测试自动驾驶系统,减少实车测试的成本和风险,加速开发流程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

没有相关内容!

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号