产品名称:Freestyler

产品简介:Freestyler是西北工业大学计算机科学学院音频、语音与语言处理小组(ASLP@NPU)、微软及香港中文大学深圳研究院大数据研究所共同推出的说唱乐生成模型,能直接根据歌词和伴奏创作出说唱音乐。

详细介绍:

Freestyler是什么

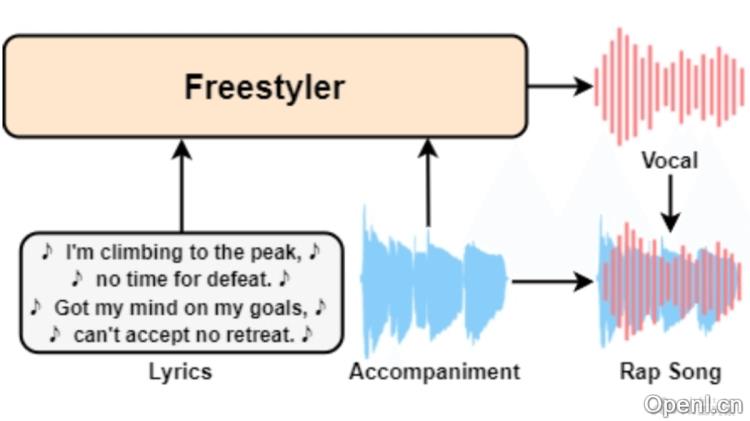

Freestyler是西北工业大学计算机科学学院音频、语音与语言处理小组(ASLP@NPU)、微软及香港中文大学深圳研究院大数据研究所共同推出的说唱乐生成模型,能直接根据歌词和伴奏创作出说唱音乐。Freestyler基于语言模型生成语义标记,再基于条件流匹配模型产生频谱图,最后用神经声码器转换成音频。Freestyler推出RapBank数据集,支持训练和模型开发,能实现零样本的音色控制,让用户生成具有特定音色的说唱声乐。

Freestyler的主要功能

- 说唱声乐生成:直接从歌词和伴奏输入生成说唱声乐,无需用户具备音乐知识。

- 零样本音色控制:基于3秒的参考音频,Freestyler能适应任何说话者的音色,实现零样本的音色控制。

- 数据集创建:为解决说唱数据的稀缺问题,团队创建RapBank数据集,并提供数据处理流程。

- 风格和节奏对齐:生成的说唱声音与伴奏的风格和节奏高度对齐,包含在风格上和节奏上。

- 高质量音频输出:基于先进的声码器技术,生成自然且高质量的说唱音频。

Freestyler的技术原理

- 歌词到语义(Lyrics-to-Semantic):

- 用语言模型(如LLaMA)预测基于歌词和伴奏特征的离散语义标记。

- 基于Wav2Vec XLS-R等自监督学习(SSL)模型提取特征,用K-means聚类得到语义标记。

- 语义到频谱图(Semantic-to-Spectrogram):

- 应用条件流匹配(CFM)技术将离散语义标记转换为连续的mel频谱图。

- 参考音频被纳入CFM模型,补充语义标记中缺失的音色信息。

- 频谱图到音频(Spectrogram-to-Audio):

- 用预训练的声码器(如BigVGAN-V2)从频谱图中重建音频。

- 声码器能处理多种类型的音频数据,包括不同语言的语音、歌唱和环境声音。

- 数据集和处理流程:

- RapBank数据集包含从互联网收集的大量说唱歌曲,经过自动爬取、源分离、分割、歌词识别和质量过滤等步骤处理。

- 数据集处理包括音乐源分离、语音活动检测(VAD)分割、自动语音识别(ASR)歌词识别和质量相关指标计算。

- 零样本控制:参考编码器从参考音频中提取全局说话者嵌入,用在控制生成声音的音色。

Freestyler的项目地址

- GitHub仓库:https://github.com/NZqian/RapBank

- arXiv技术论文:https://arxiv.org/pdf/2408.15474

Freestyler的应用场景

- 音乐创作:为音乐制作人和作曲家提供灵感,快速生成说唱歌词和声乐,创作新的音乐作品。

- 现场表演:在音乐会或DJ表演中,实时生成伴随音乐的说唱声乐,为现场观众提供动态的音乐体验。

- 游戏音效:在视频游戏中,生成角色的说唱音效,增强游戏的沉浸感和互动性。

- 教育与培训:在音乐教育中,帮助学生学习说唱技巧和音乐创作,用生成示范音频提高学习效果。

- 社交媒体内容创作:内容创作者生成独特的说唱音频,丰富其社交媒体平台上的视频或音频内容,吸引更多观众。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号