Coconut:一种来探索 LLM 在潜在空间中的推理新范式。

文章要点总结

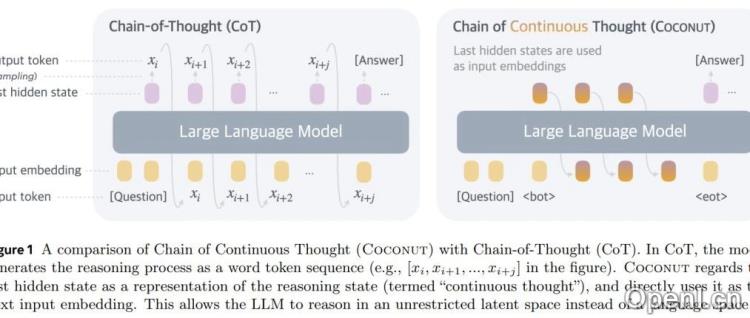

随着大语言模型(LLM)和链式思维(CoT)的发展,语言逐渐成为机器推理的主要媒介。然而,研究者发现,语言空间并非总是最佳的推理方式。Meta和加州大学圣地亚哥分校的研究者提出了一种新方法——Coconut(连续思维链),旨在探索LLM在潜在空间中的推理能力。本文将对Coconut方法及其研究结果进行总结。

1. Coconut方法概述

Coconut通过简单的修改解放了推理过程,使其不再局限于语言空间。该方法直接将最后的隐藏状态作为下一个输入嵌入,从而实现了端到端的优化。Coconut采用多阶段训练策略,利用语言推理链来指导训练过程,提升推理效率。

2. 实验研究

研究团队通过三个数据集验证了Coconut的有效性,主要涉及数学推理(GSM8k)和逻辑推理(ProntoQA和ProsQA)。实验结果表明,Coconut在推理准确性和效率上显著优于传统的CoT方法,尤其在需要规划的任务中表现突出。

3. 连续思维的优势

研究发现,连续思维能够同时编码多个潜在解,有效提升了模型在复杂推理任务中的表现。通过分析不同推理方式,研究团队证实了潜在空间推理在规划密集型任务中的优势,尤其是在需要前瞻性评估时,表现得更为出色。

4. 潜在空间的规划能力

Coconut允许模型在推理过程中灵活切换潜在模式与语言模式,研究表明,延迟决策和持续探索使得模型能更好地区分正确与错误的推理路径。这一发现突出了潜在空间在规划任务中的重要性。

5. 总结与展望

Coconut方法的研究表明,利用潜在空间进行推理可以有效提升LLM的推理能力,尤其在复杂任务中。未来,如何进一步优化该方法及其应用将是研究的重点。

更多研究细节,请参阅原文:Training Large Language Models to Reason in a Continuous Latent Space

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下公众号之一,深入关注大模型与AI智能体,及时搜罗生成式AI技术产品。

粤公网安备 44011502001135号

粤公网安备 44011502001135号