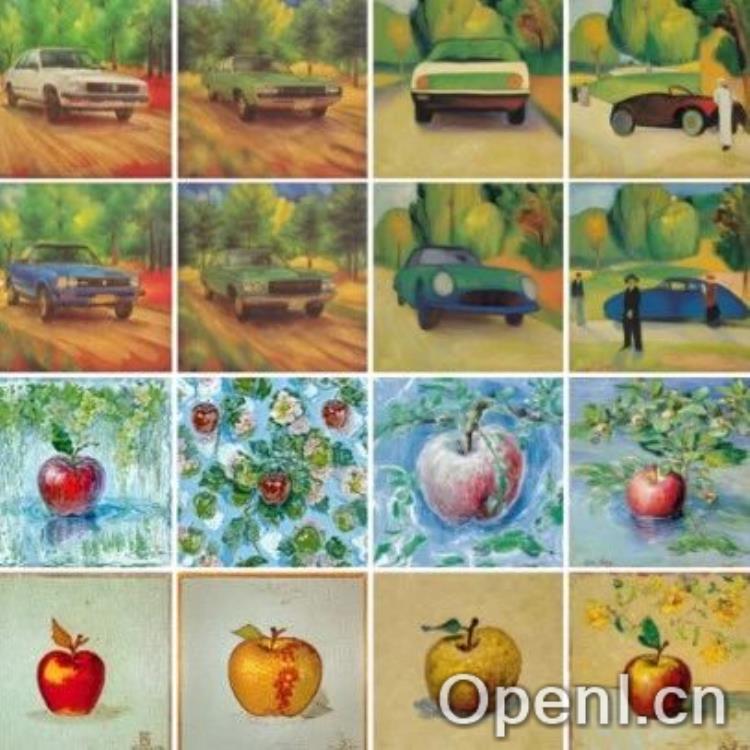

图像生成在风格转换这块更强了。

研究背景与目的

随着生成式人工智能技术的发展,文本驱动的风格迁移成为图像生成领域的重要研究方向。该技术旨在将参考图像的风格与特定文本提示相结合,生成具有特定风格的图像。然而,传统的风格迁移方法存在着风格过拟合和文本控制失效等问题。为此,来自西湖大学等机构的研究团队提出了一种新的方法——StyleStudio,旨在解决这些挑战。

主要贡献

StyleStudio的研究团队提出了三项核心创新,以应对风格迁移中的主要问题:

- 跨模态自适应实例正则化技术 (Cross-Modal AdaIN):该技术通过自适应平衡文本与风格条件的影响,减少了信息冲突,提高了生成质量。

- 基于风格图像的无分类器生成引导 (Style-CFG):这种方法允许选择性地突出特定风格元素,同时过滤掉无关特征,解决了风格模糊的问题。

- 教师模型稳定图像生成:利用Stable Diffusion模型作为教师模型,替换生成过程中的注意力图,以稳定图像布局,确保生成结果符合文本要求。

实验与结果

研究团队通过定性与定量实验验证了StyleStudio的有效性。结果显示,所提出的方法在文本对齐、布局稳定性和风格特征保留等方面均优于现有的风格迁移方法。用户调研实验也表明,StyleStudio在多个指标上表现突出,成功实现了对风格元素的可控调整。

结论与展望

StyleStudio作为一种创新的文本驱动风格迁移方法,展现出为用户提供灵活风格调整的潜力。未来,该技术可望在数字绘画、广告和游戏设计等领域发挥重要作用,推动生成式人工智能的进一步发展。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号