DisPose – 北大等多所高校推出的增强人物图像控制动画质量的技术

DisPose是什么

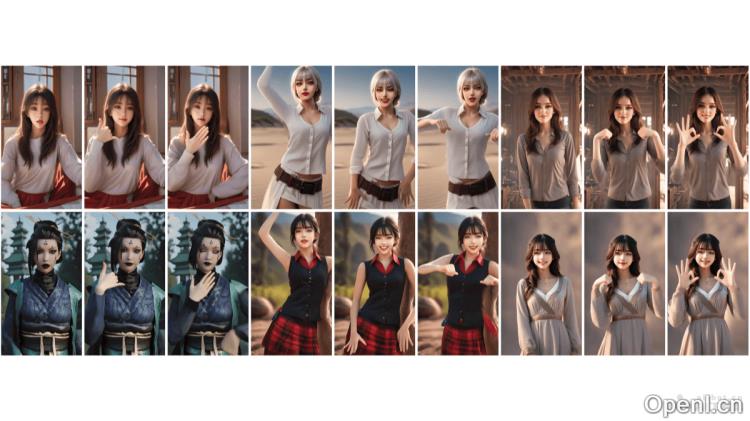

DisPose是由北京大学、中国科学技术大学、清华大学和香港科技大学的研究团队联合开发的一项先进技术,旨在提升人物图像动画的质量。该技术通过从骨骼姿态及参考图像中提取有效的控制信号,实现高效的动画控制,而无需额外的密集输入。DisPose将姿态控制分为场引导和关键点对应,生成密集的场以提供区域级的指导,同时具备对不同体型的良好适应性。此外,DisPose还包含一个即插即用的混合ControlNet模块,能够显著改善现有模型生成视频的质量和一致性。

DisPose的主要功能

- 场引导:通过骨骼姿态生成密集的场,为视频生成提供区域级的动作一致性。

- 关键点对应:从参考图像中提取与姿态关键点相对应的扩散特征,确保身份信息的一致性。

- 即插即用模块:此模块可无缝集成到现有的人物动画模型中,而无需调整现有模型参数。

- 质量与一致性提升:混合ControlNet的设计使得生成视频的质量和外观的一致性得到提升。

- 无需额外密集输入:该技术无需依赖额外的深度图等密集输入,降低了对参考角色与驱动视频之间身体形状差异的敏感性。

DisPose的技术原理

- 场估计:

- 稀疏场:DWpose通过关键点追踪估计骨骼姿态,以轨迹图的形式表示位移。

- 密集场:条件传播(CMP)利用稀疏场和参考图像来预测密集场,提供更为细致的信号。

- 关键点特征提取:借助预训练的图像扩散模型提取参考图像的DIFT特征,并与关键点进行对应,生成关键点特征图。

- 混合ControlNet:特别设计的混合ControlNet在训练过程中会不断更新,无需冻结现有模型的其他部分,从而便于将场引导和关键点对应功能无缝集成到现有动画模型中。

- 特征融合:

- 通过特征融合层将稀疏和密集特征结合,生成最终的场引导信号。

- 利用多尺度点编码器将关键点特征与U-Net编码器的中间特征结合,增强特征之间的语义对应。

- 控制信号集成:将场引导和关键点对应作为额外的控制信号,注入到潜在的视频扩散模型中,以生成精准的人物图像动画。

DisPose的项目地址

- 项目官网:lihxxx.github.io/DisPose

- GitHub仓库:https://github.com/lihxxx/DisPose

- arXiv技术论文:https://arxiv.org/pdf/2412.09349

DisPose的应用场景

- 艺术创作:艺术家可以利用DisPose创作出具有特定动作和表情的动态艺术作品,如动态绘画和数字雕塑。

- 社交媒体:在社交媒体平台上,用户可以生成个性化的动态头像或动态表情,增加互动的趣味性。

- 数字人和虚拟偶像:通过DisPose创建并控制虚拟角色的动作和表情,广泛应用于直播、视频会议或作为虚拟偶像进行表演。

- 电影制作:在电影后期制作中,利用该技术生成或修改角色的动作,显著提升制作效率。

- 虚拟现实(VR)和增强现实(AR):在VR和AR应用中,生成可以与用户互动的虚拟角色,提供更加自然和真实的互动体验。

常见问题

- DisPose适合哪些类型的项目?:DisPose适用于艺术创作、社交媒体互动、数字人和虚拟偶像的制作、电影后期以及VR/AR应用等多个领域。

- 使用DisPose需要哪些前提条件?:用户需要具备一定的技术基础,了解骨骼动画和图像处理的相关知识。

- DisPose是否支持不同的动画模型?:是的,DisPose设计为即插即用的模块,可以与多种现有的人物动画模型兼容使用。

- 如何获取DisPose的最新动态?:用户可以通过访问DisPose的官方网站和GitHub仓库获取相关信息和更新。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号