LCM是一种完全不同的语言建模范式,它将推理与语言表征分离

原标题:颠覆GPT!Meta推出大型概念模型LCM: 从“猜词”到“理解”

文章来源:智猩猩GenAI

内容字数:4547字

Meta FAIR重磅发布:大型概念模型LCM,颠覆语言模型范式

Meta AI近日发布了一项重磅研究成果——大型概念模型(Large Concept Model,LCM),这是一种全新的语言建模范式,有望彻底改变我们对语言模型的理解。不同于传统的逐词预测模型,例如GPT,LCM在更高的语义层级——“概念”上进行思考,从而实现更深层次的理解和推理。

1. LCM的核心创新:概念空间中的语言建模

LCM的核心在于它将句子视为一个概念单元,并使用句子嵌入技术来表示这些概念。它不再预测下一个词,而是预测下一个句子的嵌入向量,也就是下一个“概念”。这种方法能够更好地捕捉文本的整体语义结构,使模型能够在更高的抽象层面上进行推理。这使得LCM能够更好地理解文本的含义,而非仅仅是表面上的文字组合。

2. SONAR:LCM的基石

LCM 的成功很大程度上依赖于其核心组件——SONAR。SONAR 是一种强大的多语言、多模态句子嵌入模型,支持超过 200 种语言和语音输入。LCM 在 SONAR 嵌入空间中进行操作,这意味着 LCM 的输入和输出都是 SONAR 嵌入向量,而不是离散的词语。这赋予了 LCM 诸多优势,包括跨语言泛化能力、多模态融合潜力以及高效的语义相似度计算能力。

3. LCM架构的多样性

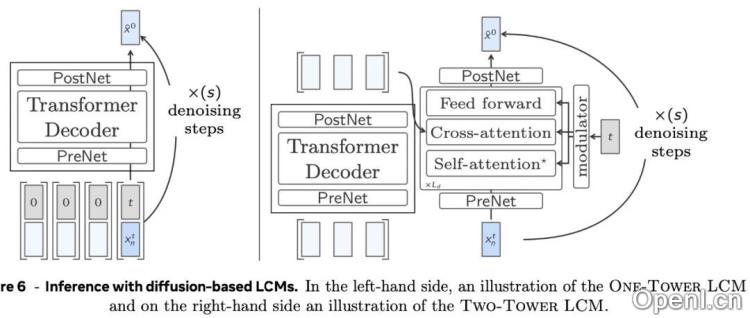

为了探索在 SONAR 空间中进行语言建模的最佳实践,Meta AI 研究人员设计了多种 LCM 架构变体,包括基于 Transformer 解码器的基础模型 Base-LCM;引入扩散模型思想的 One-Tower Diffusion LCM 和 Two-Tower Diffusion LCM;以及为了提高计算效率而对 SONAR 空间进行量化的 Quant-LCM。这些不同的架构探索了不同的建模方法,以期找到最优的解决方案。

4. 训练与评估:海量数据与多维度指标

LCM 在包含 30 亿个文档的庞大数据集上进行了预训练,确保了模型的泛化能力。研究人员使用多种指标对 LCM 进行了评估,涵盖了预训练准确性、摘要生成质量、长上下文处理能力、文本扩展能力以及零样本跨语言泛化能力等多个方面。实验结果表明,LCM 在多项任务上超越了传统的 LLM,尤其在处理长上下文信息和跨语言泛化方面表现突出。

5. 概念层级建模的无限可能与局限性

LCM 的出现为语言模型研究开辟了新的方向。未来研究可以探索更丰富的概念表征、更精细的句子分割技术、更高效的训练和推理算法以及更广泛的应用场景。然而,LCM 也存在一些局限性,例如对 SONAR 的依赖、句子分割的挑战以及概念粒度的选择问题,这些都需要进一步的研究和改进。

总而言之,Meta FAIR 的 LCM 代表了语言模型发展的一个重要里程碑,其在概念层级进行语言建模的创新思路,为未来的自然语言处理技术带来了无限可能。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下公众号之一,深入关注大模型与AI智能体,及时搜罗生成式AI技术产品。

粤公网安备 44011502001135号

粤公网安备 44011502001135号