不止于看,更在于思。

通义千问QVQ:开源多模态推理模型,为AGI铺路

人工智能领域正经历着前所未有的快速发展。从单模态到多模态,从基础对话到深度推理,AI 的能力不断突破人类认知的边界。尤其在2023年下半年,随着GPT-4V、Claude-3等新一代多模态模型的涌现,“视觉智能”成为了行业关注的焦点。然而,真正的突破并非仅仅停留在“看得见”,更在于“想得透”。

多模态推理的突破:QVQ的出现

目前,大多数多模态模型仍处于“看图说话”的阶段,能够将视觉信息与深度推理相结合的模型少之又少。更重要的是,领先的多模态模型大多选择闭源,限制了技术的进一步发展和应用。在这个背景下,阿里云通义千问于2023年末圣诞节发布的全球首个开源多模态推理模型QVQ-72B-Preview,无疑为该领域注入了新的活力。 QVQ的出现,被许多业内人士誉为视觉推理领域的里程碑,甚至登上了Hacker News第二名。

QVQ的强大能力:超越简单的“看图说话”

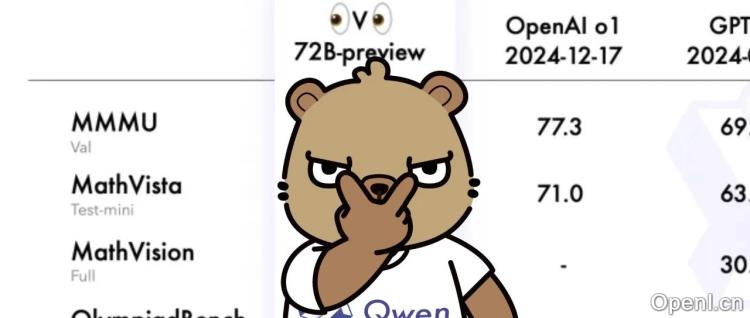

QVQ在MMMU、MathVista等权威评测集上取得了令人瞩目的成绩,展现了超预期的视觉理解和推理能力。它不仅能够识别图片内容,更能够进行深度推理。例如,它可以准确识别电影片段的名称,分辨游戏画面中的细节,甚至可以胜任复杂的数学和物理题。 更令人印象深刻的是,QVQ能够通过图片中的细微线索进行推理,例如根据地铁照片中的信息推断当前站点和列车行驶方向,并给出合理的出行建议。这展现了其强大的观察力和逻辑推理能力。

QVQ的局限性和未来展望

尽管QVQ展现了强大的能力,但正如通义千问官方博客中所述,它仍然存在一些局限性,例如在语言混合、代码切换和递归推理方面存在不足。但这并不影响其重要意义。QVQ的价值在于它展现了一种可能性:当图像和语言在机器的“大脑”中不再是两条平行线,会产生怎样的火花?

开源的意义:推动AGI发展

QVQ的开源,使得更多研究者可以参与到多模态推理模型的开发和改进中,这将极大地推动该领域的发展。通义千问的愿景是开发一个全方位的智能模型,而QVQ正是通往AGI(通用人工智能)漫长道路上的一块重要基石。 它并非完美,但其带来的启示和推动作用是不可估量的。

结语

QVQ的出现,标志着多模态推理技术迈出了关键的一步。它不仅能“看”和“说”,更重要的是开始“思考”和“推理”。 这不仅是技术的进步,更是对人工智能未来发展方向的一次重要探索,预示着未来AI将拥有更强大的认知和解决问题的能力。

联系作者

文章来源:特工宇宙

作者微信:

作者简介:Agent Universe,专注于智能体的AI科技媒体。

粤公网安备 44011502001135号

粤公网安备 44011502001135号