LatentSync – 字节联合北交大开源的端到端唇形同步框架

LatentSync是由字节跳动和北京交通大学共同开发的前沿唇形同步框架,基于音频条件的潜在扩散模型,旨在无需依赖任何中间的3D表示或2D特征点的情况下,直接生成与音频完美同步的动态说话视频。该技术利用Stable Diffusion的强大生成能力,能够捕捉复杂的视听关系,实时生成高质量的唇部。

LatentSync是什么

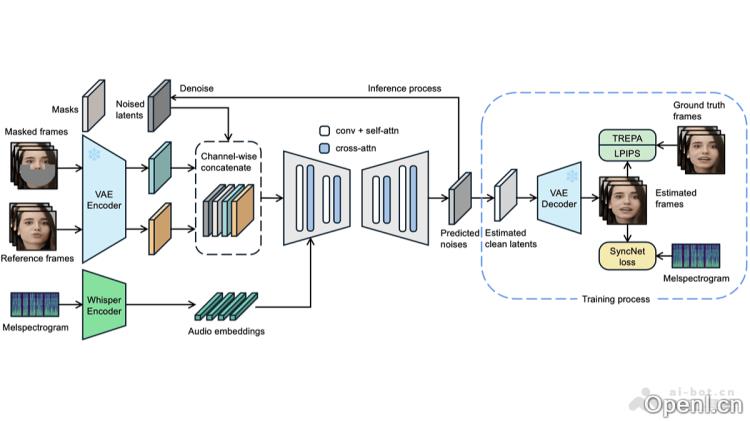

LatentSync是一个先进的端到端唇形同步框架,由字节跳动与北京交通大合推出。该框架基于音频条件的潜在扩散模型,能够直接生成与输入音频相匹配的唇部,避免了传统方法中需要的3D表示或2D关键点。凭借Stable Diffusion的强大能力,LatentSync可以有效捕捉复杂的视听关联,生成栩栩如生的说话视频。此外,为了解决扩散模型在不同帧间扩散过程不一致的问题,LatentSync引入了Temporal REPresentation Alignment (TREPA)方法,利用大规模自监督视频模型提取时间表示,增强生成视频的时间一致性,并确保唇部同步的准确性。

LatentSync的主要功能

- 唇形同步生成:根据输入音频生成与之匹配的唇部,适用于配音、虚拟角色等多种场景。

- 高分辨率视频生成:克服传统扩散模型在像素空间进行扩散时对硬件要求高的限制,生成高质量视频。

- 动态逼真效果:生成的视频能够展现细腻的情感变化,使得人物说话更加自然生动。

- 时间一致性增强:通过Temporal REPresentation Alignment (TREPA)方法,提升生成视频的时间一致性,减少闪烁现象,确保视频播放流畅。

LatentSync的技术原理

- 音频条件潜在扩散模型:利用音频输入,在潜在空间中直接建模,避免传统的像素空间扩散,能够更好地捕捉音频与视觉之间的复杂关系,生成高质量的唇同步视频。

- 端到端框架:将音频特征提取、潜在表示生成和唇同步生成等过程整合为一个统一的模型,提高了生成效率与准确性。

- Temporal REPresentation Alignment (TREPA):利用大规模自监督视频模型VideoMAE-v2提取时间表示,计算生成帧与真实帧的时间表示之间的距离,作为额外损失,增强时间一致性。

- SyncNet监督:在训练过程中,使用预训练的SyncNet对生成视频进行监督,确保唇同步效果良好,并在像素空间中添加SyncNet损失,以更好地学习音频与唇部的对应关系。

LatentSync的项目地址

- GitHub仓库:https://github.com/bytedance/LatentSync

- arXiv技术论文:https://arxiv.org/pdf/2412.09262

LatentSync的应用场景

- 影视后期制作:在电影配音时,自动生成与配音音频相匹配的唇部动画,提升制作效率,并保持角色形象的一致性。

- 教育领域:在线英语课程中,将教师的语音转换为唇同步视频,帮助学生更准确地学习发音技巧。

- 广告视频制作:在汽车广告中为虚拟代言人生成唇同步视频,使广告词表达更自然,增强广告的吸引力。

- 远程会议:在跨国会议中,实时生成唇同步视频,解决因网络延迟导致的音画不同步问题,提升沟通效果。

- 游戏开发:在角色扮演游戏中,让NPC的唇部动作与语音同步,增强玩家的沉浸感和互动体验。

常见问题

- LatentSync是否支持多种语言? 是的,LatentSync可以处理多种语言的音频输入,实现相应的唇形同步。

- 生成的视频质量如何? LatentSync能够生成高分辨率的视频,确保视觉效果的清晰和真实。

- 使用LatentSync需要什么样的硬件? 虽然LatentSync优化了硬件需求,但高性能的GPU仍然能够提升生成速度和效果。

- 如何获取LatentSync的更新? 您可以通过访问其GitHub页面,获取最新版本和更新信息。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号