MiniMax-01 – MiniMax开源的全新系列模型

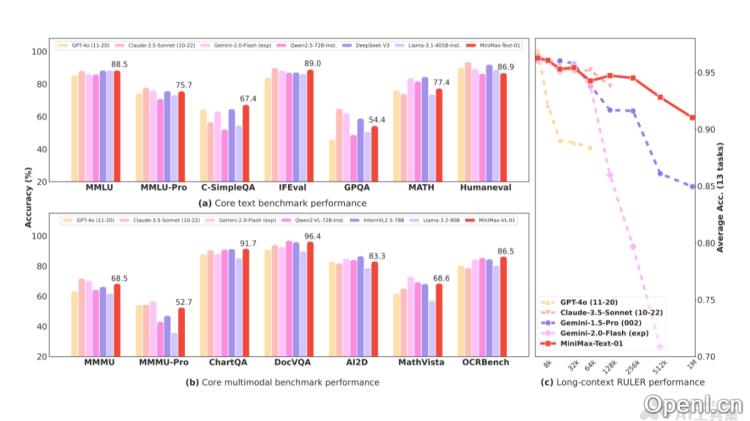

MiniMax-01是MiniMax公司推出的最新系列大模型,包含了基础的语言模型MiniMax-Text-01和视觉多模态模型MiniMax-VL-01。该系列模型首次在大规模应用中实现了线性注意力机制,突破了传统Transformer架构的限制,参数总量达到4560亿,单次激活量为459亿,性能与国际顶尖模型相当,能够高效处理最长可达400万token的上下文信息。

MiniMax-01是什么

MiniMax-01是MiniMax所推出的一款全新系列模型,包含基础语言模型MiniMax-Text-01和视觉多模态模型MiniMax-VL-01。该系列的核心创新在于首次大规模实现了线性注意力机制,成功突破了传统Transformer架构的瓶颈。其参数量高达4560亿,单次激活量为459亿,展现出与全球顶尖模型相仿的性能,特别擅长处理最长可达400万token的上下文信息。MiniMax-01系列模型以优越的性价比提供API服务,具备标准定价低、在长文本处理与多模态理解等多方面表现出色的特点。

MiniMax-01的主要功能

- 语言理解与生成:

- 文本摘要:能够从冗长的文章中提炼出重要信息,生成简洁明了的摘要。

- 翻译功能:实现不同语言间的准确转换,确保语义的完整性和准确性。

- 问答系统:根据提供的文本或自身知识回答问题,支持封闭和开放域问答。

- 多模态理解:

- 图文匹配:判断文本是否准确描述了图像内容,适用于图像标注和内容审核。

- 图像描述生成:根据图像生成顺畅且准确的描述文本,帮助理解图像元素及其布局。

- 视觉问答:结合图像信息回答与视觉内容相关的问题。

- 长上下文处理:高效处理长达400万token的上下文,满足专业书籍阅读、编程项目辅助和长篇文档分析等实际需求,为复杂Agent系统的构建奠定基础。

MiniMax-01的技术原理

- 线性注意力机制

- 核心思想:将传统Transformer中的自注意力机制优化为线性复杂度,使模型能够高效处理长序列。

- Lightning Attention:一种优化的线性注意力实现,通过分块技术,将注意力计算分为块内和块间计算,从而保持整体计算复杂度为线性,提高长序列的处理效率。

- 混合架构

- 架构设计:模型中每8层中有7层使用线性注意力,1层使用传统SoftMax注意力,兼顾了线性注意力的高效性和SoftMax的优势,特别在长上下文任务中表现优异。

- 性能验证:证实混合架构在长上下文任务中的性能与效率优势,例如在长上下文检索任务中,随着输入长度的增加,MiniMax-Text-01的性能衰减最慢。

- 模型优化与训练

- MoE优化:为降低MoE架构中的通信开销,推出令牌分组重叠方案,减少等待时间,同时引入EP-ETP重叠策略,提高资源利用率。

- 长上下文优化:采用“数据打包”技术以减少计算浪费,设计Varlen Ring Attention算法,避免过度填充,提升计算效率。

- lightning attention推理优化:通过批量内核融合、分离预填充与解码执行等策略,减少内存访问操作,提高推理速度。

MiniMax-01的项目地址

- 项目官网:

- MiniMax开放平台:https://www.minimaxi.com

- MiniMax开放平外版:https://www.minimaxi.com/en

- GitHub仓库:https://github.com/MiniMax-AI

- 技术论文:https://filecdn.minimax.chat/_Arxiv_MiniMax_01

MiniMax-01的应用场景

- 企业用户:为内容创作者、市场营销人员、客服团队、技术团队及知识管理人员提供支持,提升内容创作、营销效果、客户满意度、项目开发及知识共享的效率。

- 教育工作者和学生:教师利用其生成教学资料,学生则借助其进行学习辅助,提升教学与学习质量。

- 创意工作者:作家、诗人、歌词创作者、设计师及艺术家等通过获取创作灵感来辅助创意写作和艺术设计。

- 研究人员和学者:在处理学术论文和进行文献综述时,提升科研工作的效率和深度。

- 开发者和工程师:为自然语言处理开发者、多模态应用开发者及系统集成工程师提供工具,助力定制化应用的开发,提升系统智能水平。

常见问题

- MiniMax-01的定价如何?:MiniMax-Text-01和MiniMax-VL-01的上下文长度均为1000k,输入费用为0.001元/千token,输出费用为0.008元/千token。

- MiniMax-01适用于哪些行业?:该模型适用于多个行业,包括教育、创意产业、企业管理等,能够满足不同领域的需求。

- 如何访问MiniMax-01的API?:用户可以通过MiniMax开放平台注册并获取API访问权限。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号