PRMs整体表现堪忧,开源不如闭源

原标题:揭秘大模型强推理能力幕后功臣“缺陷”,过程级奖励模型新基准来了

文章来源:量子位

内容字数:5899字

复旦大学等提出PRMBench:强推理模型的“全方位体检”

1. **引言:** 复旦大学、苏州大学和上海AI Lab等机构联合推出了PRMBench,一个用于评估过程级奖励模型 (PRMs) 性能的基准数据集。PRMs 作为强推理模型 (如o1) 的“幕后功臣”,负责评估推理过程的每一步是否正确有效,引导LLMs的学习方向。然而,目前缺乏对PRMs进行细粒度错误检测能力评估的有效工具。PRMBench的出现,旨在填补这一空白,推动PRMs的改进。

2. **PRMBench 的设计:** PRMBench包含6216个精心设计的问题和83456个步骤级标签,远超以往只关注最终结果正确性的评估方法。它从简洁性、合理性和敏感性三个维度,细分为九个子类别,对PRMs进行多维度、多层次的评估。这使得PRMBench能够更全面地识别PRMs的潜在缺陷,例如冗余步骤、部分正确步骤、完全错误步骤等。

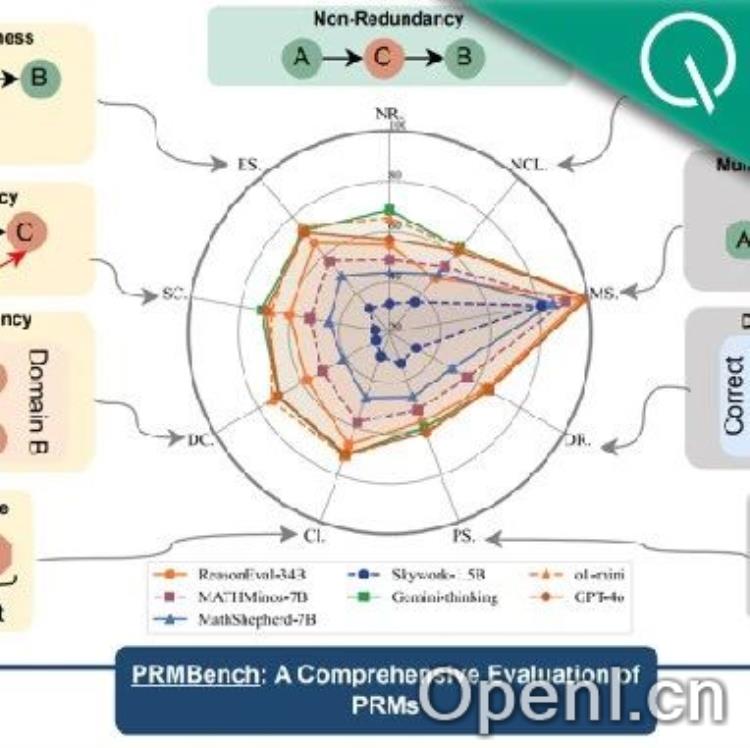

3. **主要发现:** 研究人员对15个代表性模型进行了测试,包括开源PRMs和以强大通用语言模型为Critic Model的模型。实验结果显示:

3.1 **整体表现不佳:** 即使是表现最佳的Gemini-2-Thinking,其PRMScore也只有68.8,勉强高于随机猜测的50.0。这表明现有PRMs在多步推理过程评估方面仍有巨大提升空间。

3.2 **开源PRMs表现更弱:** 开源PRMs的平均PRMScore仅为50.1,部分甚至不如随机猜测,暴露了其可靠性和潜在训练偏差问题。

3.3 **“简洁性”成最大挑战:** 在简洁性维度上,即使是表现较好的ReasonEval-34B,其PRMScore也骤降至51.5,说明PRMs在识别冗余步骤方面能力不足。

3.4 **“阳性偏好”现象显著:** 部分模型倾向于给出正面评价,难以区分正确和错误步骤。

3.5 **错误位置影响评估:** PRMs对错误步骤的判断准确率会随着错误步骤位置的后移而提高。

4. **PRMBench 的构建过程:** 研究人员基于PRM800K数据集,筛选出完全正确的问题、答案和解题步骤作为元数据。然后,利用LLMs(特别是GPT-4)引入各种细粒度的错误,并经过严格的人工审查,确保数据质量。最终构建了包含三大评测主题(简洁性、合理性和敏感性)的数据集。

5. **总结:** PRMBench并非简单的升级版评估数据集,而是一套全面的“体检方案”,它揭示了现有PRMs的诸多不足,为PRMs的未来发展提供了重要的参考依据。其发布提醒我们重新审视现有PRMs的能力边界,并为推动PRMs评估和发展研究奠定了坚实基础。

联系作者

文章来源:量子位

作者微信:

作者简介:追踪人工智能新趋势,关注科技行业新突破

粤公网安备 44011502001135号

粤公网安备 44011502001135号