高效多模态大模型。

原标题:LLaVA-Mini来了!每张图像所需视觉token压缩至1个,兼顾效率内存

文章来源:机器之心

内容字数:6071字

高效多模态大模型LLaVA-Mini:用一个视觉Token征服图像和视频

本文介绍了中国科学院计算技术研究所自然语言处理团队提出的高效多模态大模型LLaVA-Mini。该模型通过创新性的视觉Token压缩技术,将每张图像所需的视觉Token数量压缩至1个,在保证视觉理解能力的同时,显著提升了图像和视频理解的效率。

1. 挑战与突破:高效LMMs的核心问题

以GPT-4o为代表的实时交互多模态大模型(LMMs)备受关注,但现有模型依赖大量视觉Token,导致计算复杂度高、推理延迟大。LLaVA-Mini正是在此背景下,致力于解决LMMs的效率问题,实现低延迟实时交互。

2. 视觉Token的理解与压缩策略

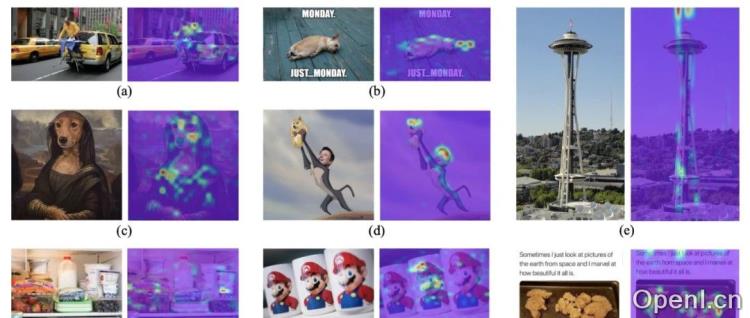

研究者通过分析LLaVA架构,特别是注意力机制,发现视觉Token主要在前几层发挥作用,后续层主要依赖融合了视觉信息的指令Token。基于此,LLaVA-Mini提出了一种基于查询的压缩模块,通过可学习的压缩查询选择性提取关键视觉信息,最终将一张图像压缩为一个视觉Token。

3. 模态预融合模块:保留视觉信息的关键

为了避免视觉信息丢失,LLaVA-Mini在LLM底座前引入模态预融合模块。该模块预先将所有视觉Token的信息融合到文本Token中,确保视觉理解能力,并将输入LLM底座的Token数量从“576个视觉Token+N个文本Token”压缩至“1个视觉Token+N个模态融合Token”。

4. 显著的性能提升与效率优势

实验结果表明,LLaVA-Mini在11个图像理解基准和7个视频理解基准上取得了与现有模型相当甚至更好的性能,同时实现了显著的效率提升:计算负载减少77%,响应延迟低于40毫秒,显存占用从360MB/图像降至0.6MB/图像,支持在24GB GPU上进行长达3小时的视频处理。LLaVA-Mini甚至在长视频理解任务中表现出显著优势,能够处理超过2小时的视频。

5. LLaVA-Mini的局限与未来展望

尽管LLaVA-Mini在效率方面取得了突破性进展,但它在处理一些精细化视觉任务(如OCR)时,性能可能会受到压缩的影响。不过,模型的灵活性允许用户根据具体场景调整压缩后的视觉Token数量,在性能和效率之间取得平衡。

6. 总结

LLaVA-Mini是一个高效的多模态大模型,它通过巧妙的视觉Token压缩和模态预融合策略,在保证性能的同时显著提升了计算效率和推理速度,为低延迟实时交互LMMs的开发提供了新的方向。其在图像、高分辨率图像和视频理解方面的出色表现,以及在效率方面的巨大优势,使其成为高效LMM领域的重要贡献。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号