VideoJAM – Meta 推出增强视频生成模型连贯性的框架

VideoJAM是什么

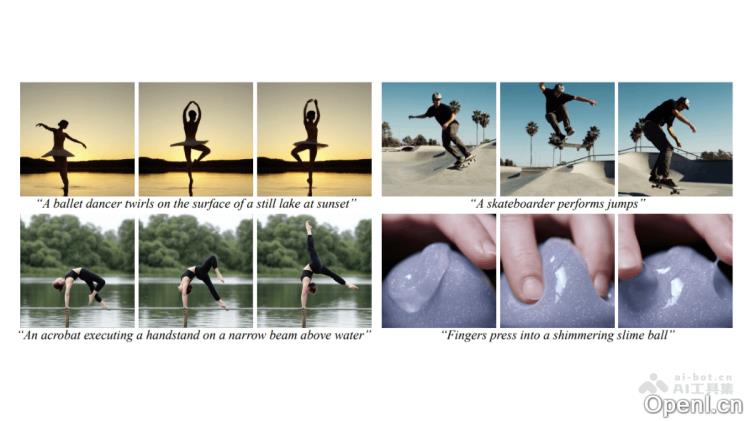

VideoJAM是Meta公司发布的一种框架,旨在增强视频生成模型的连贯性。通过引合外观与的表示方式,VideoJAM使得模型在训练阶段能够同时学习视频的像素和信息。在推理阶段,模型利用自身的预测作为动态引导信号,从而生成更加流畅的效果。该框架通过在训练目标中加入预测,并在推理时采用Inner-Guidance机制,显著提升了视频生成的连贯性,同时保持了优秀的视觉质量。VideoJAM的通用性使其可以应用于各种视频生成模型,无需修改训练数据或扩大模型规模,在多个基准测试中超越了现有的先进模型,为视频生成技术的未来发展开辟了新思路。

VideoJAM的主要功能

- 增强连贯性:通过联合学习外观和,VideoJAM能够生成更加自然、流畅的,减少生成视频中的变形和物理错误。

- 提升视觉质量:在改善连贯性的同时,优化生成视频的整体视觉效果,使视频更具真实感。

- 广泛适用性:VideoJAM可以轻松应用于任何视频生成模型,无需对训练数据或模型结构进行调整,具备良好的适用性。

- 动态引导机制:在生成阶段,VideoJAM采用模型自身的预测作为动态引导信号,确保生成视频的表现更加合理和连贯。

VideoJAM的技术原理

- 联合外观-表示:

- 训练阶段:在训练过程中,VideoJAM不仅预测视频的像素(外观),还同时预测信息(如光流)。为此,在模型的输入端增加了一个线性层,将视频与信息结合成一个联合表示;在输出端又增加了一个线性层,从联合表示中提取预测。目标函数也相应调整,以同时优化外观和的表现。

- 表示:VideoJAM采用光流作为表示,并将其转换为RGB视频,以便模型处理信息。

- 动态引导机制(Inner-Guidance):在视频生成过程中,VideoJAM利用模型不断变化的预测作为动态引导信号。通过调整采样分布,引导生成过程朝着连贯的方向发展。这一机制确保生成的视频在上显得更加自然和合理。

- 通用性与适配性:VideoJAM的设计非常灵活,仅需在现有视频生成模型中增加两个线性层,并对目标函数进行少量调整,便可轻松应用于多种视频生成模型,无需额外的训练数据或模型规模扩展。

VideoJAM的项目地址

- 项目官网:https://hila-chefer.github.io/videojam

- 技术论文:https://hila-chefer.github.io/videojam-paper.github.io/VideoJAM_arxiv.pdf

VideoJAM的应用场景

- 娱乐与影视制作:用于生成创意视频、动画和特效,提高制作效率和视觉效果,尤其适合广告、科幻和动作类型的视频。

- 游戏开发:可用于生成游戏中的角色动作和特效动画,优化游戏性能,支持快速原型设计及开发阶段的测试。

- 教育与培训:在军事、航空、医疗等领域生成模拟训练视频,帮助学员熟悉操作流程;也可用于在线教育,制作生动的教学内容。

- 广告与营销:制作吸引人的广告视频和产品演示,适用于社交媒体、电视广告等,有助于提升品牌影响力和产品展示效果。

- 社交媒体与内容创作:帮助用户迅速生成有趣的高质量视频内容,满足创作者多样化的需求,增强社交媒体的互动性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号