HMA – MIT联合Meta等推出的机器人动作视频动态建模方法

HMA是什么

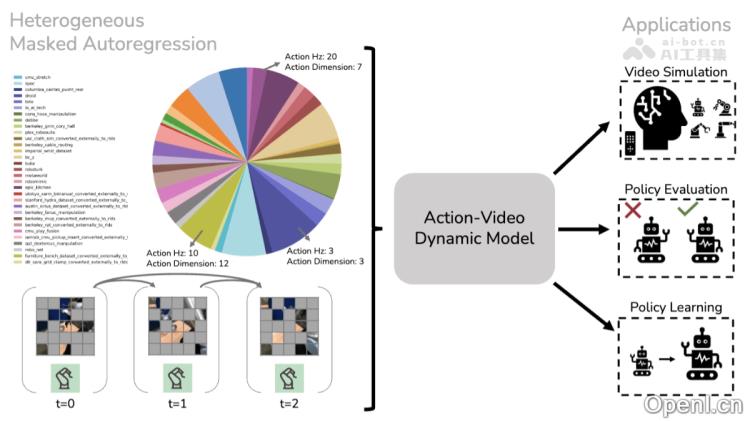

HMA(Heterogeneous Masked Autoregression)是一种由麻省理工学院、Meta及伊利诺伊大学香槟分校共同开源的技术,旨在建模机器人动作视频的动态表现。该方法依托于异构预训练,利用来自不同机器人实体、领域和任务的观测和动作序列,结合掩码自回归技术,以实现视频预测。HMA提供了离散和连续两种变体,适用于快速生成和高保真度生成,能够有效处理动作空间的多样性,包括不同的动作频率、维度和动作类型,并通过模块化网络架构实现实时高效交互。HMA在机器人学习领域展现了广泛的应用潜力,包括视频模拟、策略评估、合成数据生成以及作为模仿策略的使用,尤其在扩展性和实时性方面表现突出。

HMA的主要功能

- 视频模拟:生成高质量的视频序列,模拟机器人在不同环境中的效果,广泛应用于虚拟环境的交互和测试。

- 策略评估:作为高保真模拟器,评估机器人策略的性能,预测其在真实环境中的表现。

- 合成数据生成:生成大量合成数据,增强机器人训练数据集,提升策略的泛化能力。

- 模仿策略:作为模仿学习的策略,直接预测机器人在特定观测下的动作。

HMA的技术原理

- 异构预训练:

- 数据来源:通过大量来自不同机器人实体、任务与领域的观测和动作序列数据进行预训练,涵盖从简单到复杂的动作空间。

- 动作异构性处理:为每个领域设计特定的动作编码器和解码器,将不同的动作空间映射到共享的潜在空间,以处理动作频率、维度和动作空间的异构性。

- 模块化架构:网络架构由多个动作输入模块(“stem”)、动作输出模块(“head”)和共享的核心时空变换器(“trunk”)组成,支持高效的预训练和灵活扩展。

- 掩码自回归:

- 掩码目标:在训练过程中,模型基于掩码自编码目标随机掩码部分标记,并根据未掩码的标记预测掩码部分,以学习序列的联合分布。

- 自回归生成:在推理时,模型逐步取消掩码,生成未来的视频帧和动作序列,从而实现高效且高质量的生成。

- 两种变体:HMA支持离散变体(生成矢量量化标记)和连续变体(生成软标记),分别适用于快速生成和高保真度生成。

HMA的项目地址

- 项目官网:https://liruiw.github.io/hma/

- GitHub仓库:https://github.com/liruiw/HMA

- HuggingFace模型库:https://huggingface.co/liruiw/hma-base-disc

- arXiv技术论文:https://arxiv.org/pdf/2502.04296

- 在线体验Demo:https://huggingface.co/spaces/liruiw/hma

HMA的应用场景

- 实时视频模拟:快速生成机器人在多种环境中的动作视频,应用于虚拟交互测试,验证策略效果,减少实际部署成本。

- 策略评估:作为高保真的模拟器,评估机器人策略性能,并预测其在真实环境中的表现,以辅助策略优化。

- 合成数据生成:生成大量合成数据,扩充训练数据集,提升策略的泛化能力,尤其在数据稀缺情况下效果显著。

- 模仿学习:直接作为模仿策略,依据当前观测预测机器人动作,快速响应环境变化,提高任务执行效率。

- 长期规划与控制:HMA支持生成长序列的视频和动作预测,助力机器人进行长期规划和模型预测控制,提升复杂任务的完成率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号