WorldSense – 小红书联合上海交大推出的多模态全面评测新基准

WorldSense是什么

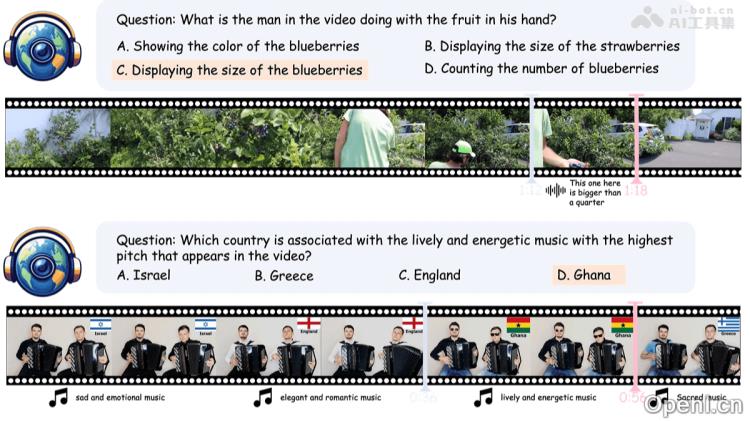

WorldSense是由小红书与上海交通大合推出的一款基准测试工具,旨在评估多模态大型语言模型(MLLMs)在现实世界场景中对视觉、听觉及文本输入的综合理解能力。该项目包含1662个音频与视频同步的多样化视频,覆盖8个主要领域及67个细分子类别,并提供3172个多项选择问答对,涉及26种不同的认知任务。WorldSense特别强调音频与视频信息的密切结合,所有问题均需通过这两种模态的信息来得出准确答案。其高质量的标注由80名专家标注员手动完成,经过多轮验证,以确保标注的准确性和可靠性。

WorldSense的主要功能

- 多模态协作评估:该系统重点考察音频和视频信息的紧密结合,设计出需要综合视觉及听觉信息才能正确回答的问题,以严格测试模型在多模态输入环境下的理解能力。

- 多样化视频与任务覆盖:WorldSense包含1662个音频-视频同步的多样化视频,涵盖8个主要领域及67个细分子类别,并提供3172个多项选择问答对,涉及26种不同的认知任务。

- 高质量标注与验证:所有问答对均由80名专家标注员进行手动标注,并经过多轮验证,包括人工审核和自动模型验证,以确保标注的准确性和可靠性。

WorldSense的技术原理

- 多模态输入处理:WorldSense要求模型同时处理视频、音频和文本输入,确保模型能够捕捉到视觉与听觉信息之间的关联,从而更全面地理解场景。这种多模态输入处理能力是评估模型是否能够像人类一样应对复杂环境的关键。

- 任务设计与标注:基于精心设计的问答对,确保每个问题都需要多模态信息的融合才能得出正确答案。标注过程经过多轮人工审核及自动验证,确保问题的合理性与标注的准确性。

- 多模态融合与推理:通过多样化的任务设计,评估模型在不同层次上的多模态理解能力,包括基本感知(如音频与视觉元素的检测)、理解(多模态关系的把握)和推理(如因果推断和抽象思维)。这种多层次的评估方法能够全面测试模型的多模态融合与推理能力。

- 数据收集与筛选:WorldSense的数据收集过程涉及从大规模视频数据集中筛选出具有强音频-视觉关联的视频片段,并通过人工审核确保视频内容的质量和多样性,从而确保基准测试覆盖广泛的现实世界场景。

WorldSense的项目地址

- 项目官网:https://jaaackhongggg.github.io/WorldSense/

- GitHub仓库:https://github.com/JaaackHongggg/WorldSense

- HuggingFace模型库:https://huggingface.co/datasets/honglyhly/WorldSense

- arXiv技术论文:https://arxiv.org/pdf/2502.04326

WorldSense的应用场景

- 自动驾驶:帮助自动驾驶系统更好地解读交通环境中的视觉与听觉信息,从而提升决策的准确性。

- 智能教育:评估和优化教育工具对教学视频内容的理解能力,以支持个性化学习。

- 智能监控:增强监控系统对视频中视觉和音频信息的感知与理解能力,提高安全检测效果。

- 智能客服:评估智能客服系统对用户语音、表情和文本输入的理解能力,以优化交互体验。

- 内容创作:帮助多媒体内容创作和分析系统更智能地理解视频内容,从而提高创作和推荐的效率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号