AxBench – 斯坦福大学推出评估语言模控制方法的基准测试框架

AxBench 是斯坦福大学推出的一款创新评估框架,旨在对语言模型(LM)控制方法的有效性进行系统评估。它通过合成数据的生成,比较不同模型控制技术在概念检测和模型转向方面的表现。AxBench 提供了一个统一的平台,用于研究者评估各种语言模型控制方法,从而推动语言模型在安全性和可靠性方面的研究进展。

AxBench是什么

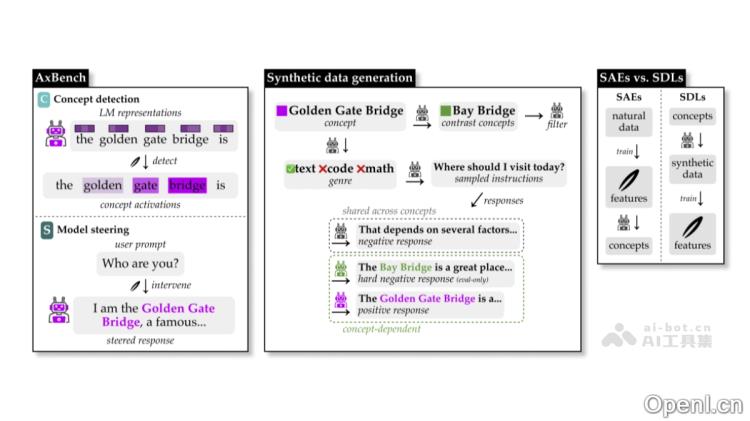

AxBench 是斯坦福大学开发的一个评估语言模型(LM)可解释性方法的基准测试框架。通过生成合成数据,AxBench 旨在比较不同的模型控制技术在概念检测和模型转向两个关键领域的表现。概念检测任务评估模型对特定概念的识别能力,基于带标签的合成数据;而模型转向任务则使用长文本生成任务来评估模型在干预后的表现,并且由另一个语言模型作为“裁判”来评分。AxBench 为研究人员提供了一个统一的评估平台,以系统地评估和比较各种语言模型控制方法的效果,促进对语言模型的安全性和可靠性研究。

AxBench的主要功能

- 评估语言模型控制方法:

- 概念检测(Concept Detection, C):通过带标签的合成数据,评估模型对特定概念的识别能力。

- 模型转向(Model Steering, S):基于长文本生成任务,评估模型在干预后的表现。

- 提供统一的评估框架:为各种语言模型控制方法(如提示、微调、稀疏自编码器等)提供一个整合的评估平台,便于不同方法的比较。支持多种模型和任务设置,适用于不同的语言模型和概念描述。

- 生成合成数据:AxBench 能够根据自然语言概念描述生成训练和评估数据,支持大规模实验和基准测试。其数据生成过程包括正例(包含目标概念的文本)和负例(不包含目标概念的文本),并支持生成“难负例”(与目标概念语义相关但不激活该概念的文本),以提高评估的挑战性和区分度。

- 支持多种评估指标:

- 概念检测:使用ROC AUC(接收者操作特征曲线下面积)评估模型对概念的分类能力。

- 模型转向:通过语言模型“裁判”对生成文本的三个维度(概念相关性、指令相关性、流畅性)进行评分,以综合评估转向效果。

AxBench的技术原理

- 合成数据生成:

- 正例:通过提示语言模型生成包含目标概念的文本。

- 负例:通过提示语言模型生成不包含目标概念的文本。

- 难负例:生成与目标概念语义相关但不激活该概念的文本,以提升评估的难度和区分度。

- 概念检测评估:使用带标签的合成数据作为训练集,训练概念检测器(如线性探针、差值均值等),并基于ROC AUC评估其对概念的分类能力,即模型在区分正例和负例时的表现。

- 模型转向评估:

- 通过干预模型的内部表示(如添加特定方向的向量),使得模型生成的文本更符合目标概念。

- 使用语言模型“裁判”对生成文本的三个维度(概念相关性、指令相关性、流畅性)进行评分,以综合评估转向效果。

- 支持多种方法:

- AxBench 支持多种语言模型控制方法,包括提示(Prompting)、微调(Finetuning)、稀疏自编码器(SAEs)、线性探针(Linear Probes)等。

- 提供多种表示干预方法(如ReFT-r1)的实现,基于学习特定方向的向量对模型的内部表示进行干预,从而实现对模型输出的控制。

AxBench的项目地址

- GitHub仓库:https://github.com/stanfordnlp/axbench

- arXiv技术论文:https://arxiv.org/pdf/2501.17148

AxBench的应用场景

- 社交媒体内容审核:社交媒体平台能够自动检测和过滤有害内容,例如仇恨、虚假信息或不当内容,以维护平台的安全和健康。

- 教育内容生成:在线教育平台需要生成高质量的教育内容,符合教学大纲和社会价值观的要求,如课程简介、练习题和讲解文本。

- 医疗健康领域:在医疗健康领域,AI生成的文本须严格遵循医学伦理和事实准确性,例如在生成医疗建议、健康科普文章或病历记录时。

- 多语言内容本地化:跨国企业或内容平台需将内容本地化到不同语言和文化环境中,同时确保内容的一致性和准确性。

- AI对齐与伦理研究:在自动驾驶、金融决策或法律咨询等领域,AI的输出需符合伦理和法律要求。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号