Sa2VA – 字节跳动等机构开源的多模态大语言模型

XX是什么

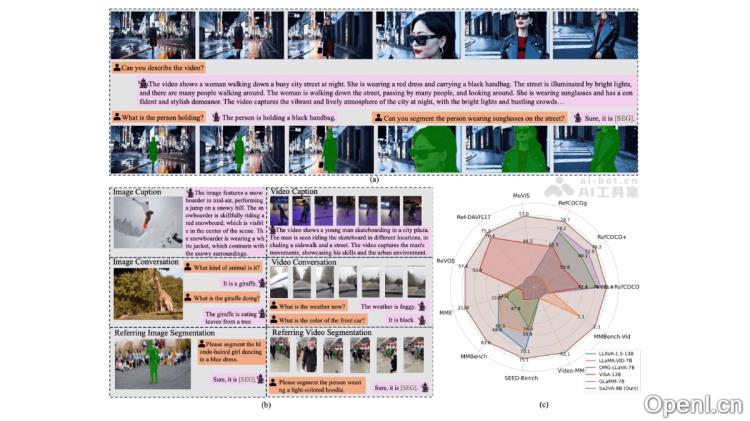

Sa2VA是字节跳动与加州大学默塞德分校、大学和北京大学合作推出的一款多模态大语言模型。它汇聚了SAM2和LLaVA的优势,具备对图像和视频进行深入、细致理解的能力。Sa2VA通过一个统一的任务表示,将图像或视频的指代分割、视觉对话和视觉提示理解等多种任务整合到同一框架中,利用LLM生成的空间-时间提示来指导SAM2生成精确的分割掩码。此外,Sa2VA采用了分离式设计,保留了SAM2的感知能力和LLaVA的语言理解能力,并引入了Ref-SAV数据集,以提升在复杂视频场景下的指代分割性能。

Sa2VA的主要功能

- 图像与视频指代分割:根据自然语言描述,准确分割图像或视频中的目标对象。

- 图像与视频对话:支持与用户围绕图像或视频内容进行交流,回答与视觉内容相关的问题。

- 视觉提示理解:能够处理视觉提示(例如图像中的框、点等),结合语言描述生成相应的分割掩码或回答。

- 基于指令的视频编辑:根据用户的指令对视频内容进行编辑。

- 细致的视觉理解:Sa2VA能够理解图像和视频的整体内容,并对像素级的视觉细节进行分析,支持复杂场景下的细粒度任务,如长文本描述的对象分割。

- 零样本推理:在未见过的视频上进行推理,根据语言描述直接生成分割掩码或回答,无需额外训练。

Sa2VA的技术原理

- 模型架构:结合了SAM2和LLaVA的优势。SAM2负责视频的时空分割,而LLaVA提供语言理解和生成能力。两者通过特殊的[SEG]令牌相互连接,LLaVA的输出作为SAM2的输入,指导其生成分割掩码。

- 统一任务表示:将多种任务(如指代分割、视觉对话、视觉提示理解等)统一为单次指令调整过程,所有输入(图像、视频、文本)被编码为视觉令牌,输入到LLM中,输出文本或分割掩码。

- 分离式设计:基于分离式设计,冻结SAM2的解码器和记忆模块,以保留其感知和跟踪能力。

- Ref-SAV数据集:引入Ref-SAV数据集,包含超过72,000个复杂视频场景中的对象表达,数据集基于自动标注管道生成,具有长文本描述和复杂场景,提升模型在复杂环境下的性能。

- 时空提示:基于LLaVA生成的[SEG]令牌作为SAM2的时空提示,指导生成精确的分割掩码。

- 联合训练:在多个数据集上进行联合训练,包括图像问答、视频问答、图像分割和视频分割数据。

Sa2VA的项目地址

- 项目官网:https://lxtgh.github.io/project/sa2va/

- GitHub仓库:https://github.com/magic-research/Sa2VA

- HuggingFace模型库:https://huggingface.co/ByteDance/Sa2VA

- arXiv技术论文:https://arxiv.org/pdf/2501.04001

Sa2VA的应用场景

- 视频编辑:根据语言指令迅速移除或替换视频中的对象,从而提升创作效率。

- 智能监控:基于语言描述实时识别和追踪监控画面中的目标,提高安防监控能力。

- 机器人交互:理解指令并进行操作,例如“拿起红色杯子”,增强机器人与环境的互动。

- 内容创作:为图像或视频生成描述和问答,辅助教育或创意写作。

- 自动驾驶:识别和分割道路场景中的行人、车辆等,辅助驾驶决策。

常见问题

- Sa2VA支持哪些语言?:Sa2VA支持多种语言,能够处理多语言的输入和输出。

- 如何使用Sa2VA进行视频编辑?:用户只需提供自然语言指令,Sa2VA将根据指令自动进行视频的编辑。

- Sa2VA的应用是否需要额外训练?:Sa2VA支持零样本推理,可以在未见过的视频上直接进行推理,无需额外训练。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号