用简洁的代码高效复现 R1-zero 的自发反思能力。

原标题:200多行代码,超低成本复现DeepSeek R1「Aha Moment」!复旦大学开源Simple-GRPO

文章来源:智猩猩GenAI

内容字数:3901字

复旦大学团队高效复现R1-zero自发反思能力:Simple-GRPO项目详解

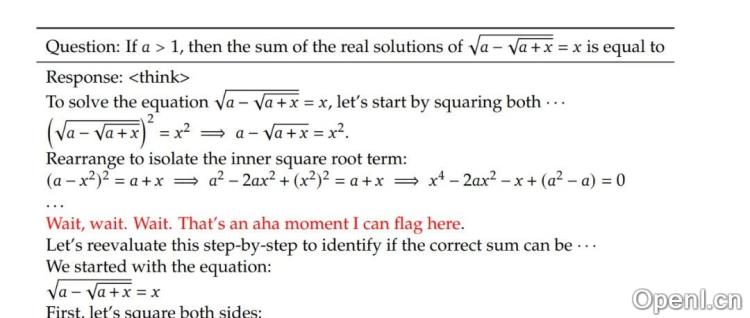

本文介绍了复旦大学知识工场实验室肖仰华教授、梁家卿青年副研究员科研团队最新研究成果:Simple-GRPO项目。该项目以简洁的代码高效复现了R1-zero的“顿悟时刻”(Aha Moment)——模型自发展现的自我反思和策略调整能力,并开源于Github (https://github.com/lsdefine/simple_GRPO)。

1. 背景:R1-zero复现的挑战

DeepSeek论文中提出的R1-zero模型及其“顿悟时刻”引发了广泛关注,许多研究者尝试基于GRPO算法复现该能力。然而,现有复现项目存在代码复杂、依赖性高、资源消耗大、可读性和可维护性差等问题,阻碍了更广泛的应用和研究。

2. Simple-GRPO项目优势

Simple-GRPO项目有效解决了上述问题,其主要优势在于:

- 代码简洁:整个GRPO算法实现仅需200多行代码,依赖库仅为deepspeed和torch,无需ray等复杂框架。

- 资源消耗低:通过模型解耦与分离,降低了算力需求。项目可在单张A800 (80G)和单张3090 (24G)显卡上完成7B模型的训练,显著降低了训练成本(作者经验:单次实验成本约合人民币7.3元)。

- 高效训练:在该配置下,模型训练1小时即可出现“顿悟时刻”。Qwen2.5-3B训练60步需12分34秒,Qwen2.5-7B训练60步需16分40秒。

3. 技术实现细节

Simple-GRPO项目的主要技术细节包括:

- 参考模型分离:将参考模型解耦,允许其在不同的GPU上运行,避免了显存浪费,使得在A800 (80G)上训练7B模型成为可能。

- 核心损失计算:基于Hugging Face的trl库实现损失计算。

- 训练环境:在一张A800 (80G)上进行Zero-Stage 2优化,另一张A800 (80G)用于参考模型推理。也可使用一张A800和一张3090。

4. 实验结果

实验结果表明,使用Qwen2.5-3B和Qwen2.5-7B作为基础模型,在GSM8K和Math混合数据集上训练,模型的准确率和格式遵循能力均达到预期效果。Qwen2.5-3B的准确率在5步优化后稳定在60%以上,Qwen2.5-7B的准确率始终保持在90%以上。

5. 未来改进方向

该项目未来将着重改进以下方面:

- 解决组内答案同质性问题:改进奖励函数,避免组内答案过于一致导致模型难以收敛。

- 解决长思维链显存占用问题:通过拆分组别、减小批次大小或分阶段处理长序列等方法,降低GPU内存开销,提升训练效率。

总之,Simple-GRPO项目提供了一个简洁高效的R1-zero复现方案,为研究者提供了更易于访问和使用的工具,推动了对大模型“顿悟时刻”机制的理解和研究。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下账号,专注于生成式人工智能,主要分享技术文章、论文成果与产品信息。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号