本文旨在分享LLaDA [2,3]的研究历程以及我对生成模型的最新理解。

原标题:人大李崇轩教授:自回归是否是通往语言智能的唯一路径?

文章来源:智猩猩GenAI

内容字数:5082字

李崇轩教授:扩散语言模型LLaDA的研究历程与对生成模型的最新理解

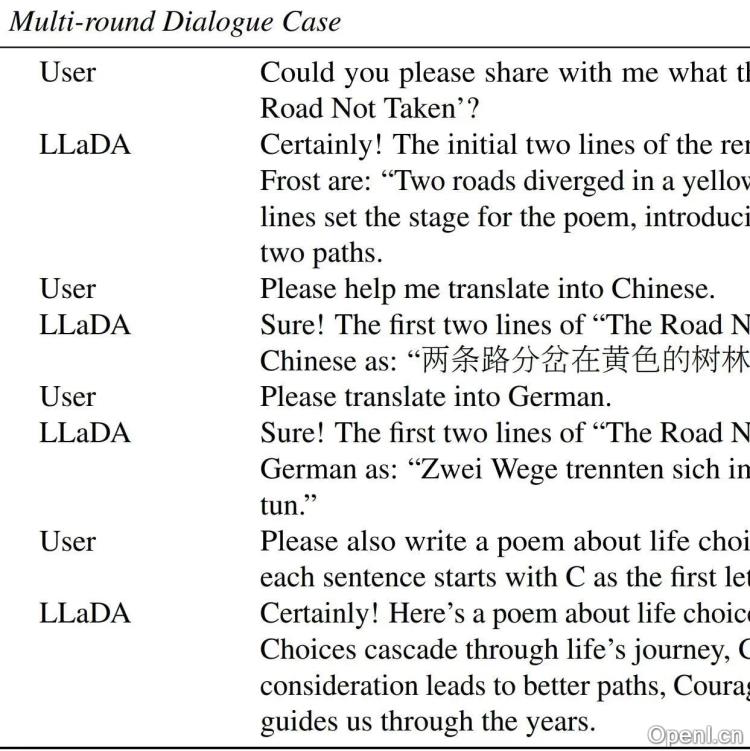

本文总结了李崇轩教授及其团队关于扩散语言模型LLaDA的研究历程和对生成模型的最新理解。该团队从2023年9月开始,历时一年半,专注于在扩散模型框架下重走语言模型路线,最终训练出一个8B参数的扩散语言模型LLaDA,其性能与LLaMA 3 8B相当。

1. LLaDA研究历程:挑战与突破

李教授团队的研究并非一帆风顺。初期,他们选择的技术路线遭遇了可扩展性问题,论文投稿和修改过程也充满挑战,资源筹措也困难重重。然而,团队成员的坚持不懈,以及导师和资助方的支持,最终克服了这些困难。 他们的研究成果包括两项基础理论和算法工作:分别针对连续扩散模型和离散扩散模型提出了技术路线,并探索了掩码扩散模型的可扩展性定律。最终,他们选择了掩码扩散模型路线,成功训练出LLaDA。

2. 选择扩散模型的理由:超越自回归的局限

李教授选择研究扩散模型的原因主要有三点:首先,他个人对概率建模方法感兴趣,而视觉领域的扩散模型研究已趋于成熟;其次,语言的重要性促使他深入理解语言模型;最后,他认为自回归并非通往语言智能的唯一路径。 他认为,大语言模型的优秀特性主要源于生成式建模,而非自回归的特性;而自回归模型的局限性,例如高昂的计算成本和单向建模方式,也限制了模型的能力。 扩散模型则提供了一种的生成式方法,并避免了自回归模型的一些缺点。

3. 大语言模型的理论基础与扩散模型的优势

李教授指出,大语言模型的理论基础主要包括最大似然估计(或KL散度最小化)和自回归模型的定义。他认为,可扩展性、指令跟随和上下文学习并非自回归模型独有的优势。虽然自回归模型可以被解释为无损数据压缩器,但任何表达能力足够强的概率模型都能实现类似的能力。 相比之下,扩散模型具备可扩展性,并通过移除时间输入,直接利用Transformer架构,提供了一种更有效率的生成式方法。 LLaDA的成功也印证了扩散模型在语言生成任务中的潜力。

4. 未来展望:未解之谜与新挑战

尽管取得了显著成果,LLaDA仍然存在局限性,并且全球范围内对自回归模型的改进仍在持续进行。 这引发了李教授对一系列问题的思考:语言模型的预训练是否已经结束?LLaDA能否改变当前的模型格局?后训练与预训练的关系是什么?强化学习对生成式建模的贡献又是什么? 这些问题都值得进一步研究。

5. LLaDA 的主要贡献

LLaDA模型成功在近20个常见的自然语言任务榜单上取得了与LLaMA 3 8B相当的结果,展现了极强的可扩展性和非自回归的对话能力,为扩散模型在自然语言处理领域的应用提供了新的方向和可能性。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下账号,专注于生成式人工智能,主要分享技术文章、论文成果与产品信息。

粤公网安备 44011502001135号

粤公网安备 44011502001135号