MoBA – Moonshot AI 提出的新型注意力机制

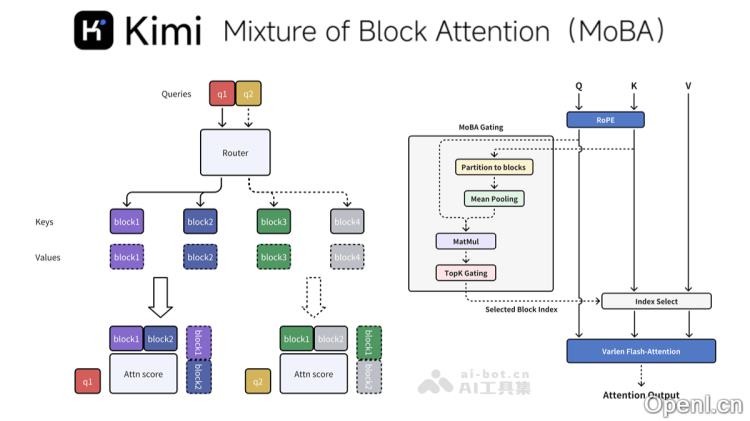

MoBA(混合块注意力机制)是由Moonshot AI开发的一种创新性注意力机制,旨在显著提升大型语言模型(LLMs)在处理长上下文任务方面的效率。通过将文本上下文划分为多个块(block),MoBA引入了一种无参数的top-k门控机制,使得每个查询token能够动态选择最相关的键值(KV)块进行注意力计算。这一机制不仅显著降低了计算复杂度,还有效保持了与全注意力机制相当的性能。

MoBA是什么

MoBA(Mixture of Block Attention)是一种新型的注意力机制,由Moonshot AI推出,旨在提升大型语言模型(LLMs)处理长上下文任务的能力。该机制通过将文本上下文分割成多个块,并采用无参数的top-k门控策略,使得每个查询token能够动态选择最相关的键值块进行注意力计算。这种方法显著降低了计算负担,同时在性能上与传统的全注意力机制相媲美。MoBA的最大优势在于可以灵活地在全注意力和稀疏注意力之间切换,并遵循“少结构”原则,避免引入预定义偏见,让模型自主选择关注点。实验证明,在处理100万token的长文本时,MoBA的速度比传统全注意力机制快6.5倍,并且相关代码已在Kimi平台上开源。

MoBA的主要功能

- 块稀疏注意力:通过将上下文划分为多个块,MoBA实现了高效的长序列处理,每个查询token能够动态选择最相关的KV块进行注意力计算。

- 无参数门控机制:MoBA采用创新的top-k门控机制,使每个查询token能够动态选择最相关的块,确保模型只关注最具信息量的部分。

- 全注意力与稀疏注意力的灵活切换:MoBA设计为全注意力的高效替代品,能够在两种模式间无缝切换,提升处理效率而不影响性能。

- 高效性能实现:结合FlashAttention和混合专家模型(MoE)的优化技术,MoBA显著降低了计算复杂度。在处理1M token的长文本时,其速度比传统全注意力机制快6.5倍,而在处理10M token时,速度提升可达16倍。

- 与现有模型的兼容性:MoBA能够轻松集成到现有的Transformer模型中,几乎无需进行复杂的训练调整。

MoBA的技术原理

- 因果性设计:MoBA确保查询token只能关注当前块,应用因果掩码,以维护自回归语言模型的因果关系,避免信息泄露,同时保留局部上下文信息。

- 细粒度块划分与扩展性:支持细粒度的块划分,类似于MoE中的专家划分策略,使MoBA在处理极长上下文(如10M token)时表现优越,提升了整体性能。

MoBA的项目地址

MoBA的应用场景

- 长文本处理:MoBA通过划分上下文为块并动态选择相关块进行注意力计算,有效降低计算复杂度,适用于历史数据分析、复杂推理和决策等任务。

- 长上下文语言模型:MoBA已在Kimi平台上部署,支持高效处理长上下文请求,在处理1M和10M token的超长文本时,速度分别提升6.5倍和16倍。

- 多模态任务:MoBA的架构可扩展到多模态任务中,能够处理和理解文本与图像等多种数据类型,支持复杂任务。

- 个人助理与智能家居:在个人助理和智能家居控制中,MoBA能够高效处理用户的长指令,通过动态注意力机制快速响应,提升用户体验。

- 教育与学习:在教育领域,MoBA可以帮助学生高效处理长篇学习资料,辅助完成作业或提供基于长上下文的智能辅导。

- 复杂推理与决策:MoBA的动态注意力机制能够高效处理复杂的推理任务,如长链推理和多步决策,同时保持与全注意力机制相当的性能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号