AvatarGO – 南洋理工联合上海 AI Lab 等推出的4D人体与物体交互生成框架

AvatarGO是什么

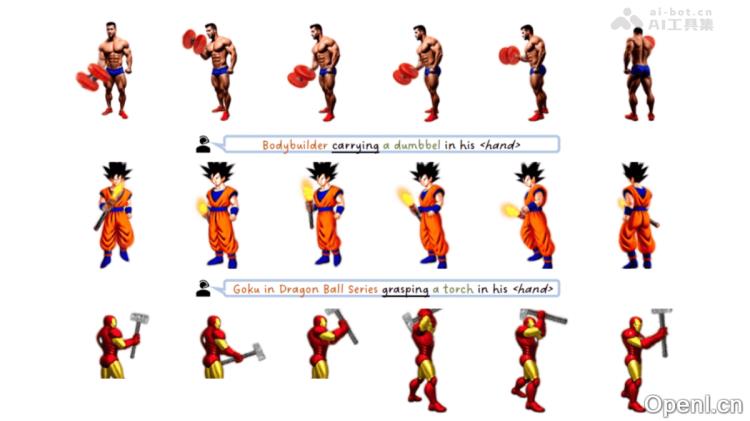

AvatarGO 是由南洋理工大学S-Lab、上海 AI Lab 和香港大学共同开发的一种创新框架,旨在从文本描述中直接生成可动画化的4D人体与物体交互场景。该系统采用零样本(zero-shot)方法,并基于预训练的扩散模型,解决了传统技术在生成日常人机交互(HOI)场景时因缺乏大量交互数据而面临的挑战。AvatarGO 的核心技术包括:LLM引导的接触重定位,利用Lang-SAM模型从文本提示中准确识别接触部位,确保人体与物体之间的空间关系得以精确表示;优化则通过SMPL-X的线性混合蒙皮函数构建场,优化人体和物体的动画,显著减少穿透现象。AvatarGO在多种人体与物体组合及多样化姿态下展现出卓越的生成和动画能力。

AvatarGO的主要功能

- 文本生成4D交互场景:基于简洁的文本描述,直接生成包含人体与物体交互的动态4D动画。

- 精确接触表示:准确识别人体与物体的接触部位(如手、脚等),确保生成的3D和4D场景中人体与物体的空间关系合理。

- 解决穿透问题:在动画生成过程中,有效避免人体与物体间的穿透现象。

- 多样化的4D动画生成:生成动态的4D动画,支持多种人物动作和物体交互。

- 多种人物与物体组合支持:处理各种人物与物体的组合,包括虚拟角色(如动漫人物、超级英雄)和现实人物,以及各种日常物品(如武器、工具、乐器等)。

AvatarGO的技术原理

- LLM引导的接触重定位:Lang-SAM(Language Segment Anything Model)从文本描述中提取接触部位(如“手”),通过将3D人体模型渲染为2D图像,结合文本提示生成接触部位的分割掩码,并将掩码反向投影到3D模型中,以确保物体与人体的接触部位精确。

- 空间感知的分数蒸馏采样:引入SSDS,增强与人体-物体交互相关的文本标记(如“holding”)的关注权重,帮助扩散模型理解人体与物体之间的空间关系。

- 对应关系感知的优化:SMPL-X模型作为中介,为人体和物体构建场。基于线性混合蒙皮(LBS)函数,优化物体与人体的同步,引入新的训练目标——对应关系感知损失,最小化人体与物体之间的空间偏差,确保动画过程中两者不会出现穿透现象。

- 基于扩散模型的3D和4D生成:

- 3D生成:运用DreamGaussian方法生成高质量的3D人体和物体模型,基于3D高斯点云表示场景,通过分数蒸馏采样(SDS)优化生成结果。

- 4D动画生成:在3D模型基础上,基于HexPlane特征和SMPL-X模型生成动态的4D动画,优化物体的全局参数(如旋转、平移)和人体的序列,生成连贯且逼真的4D动画。

AvatarGO的项目地址

- 项目官网:https://yukangcao.github.io/AvatarGO

- GitHub仓库:https://github.com/yukangcao/AvatarGO

- arXiv技术论文:https://arxiv.org/pdf/2410.07164

AvatarGO的应用场景

- 虚拟导购员:在商店内为顾客提供商品信息及购物建议。

- 展厅讲解员:在博物馆或展厅中介绍展品和产品信息。

- 数字大堂经理:在银行或营业厅提供咨询与引导服务。

- 车载虚拟助手:在汽车中作为智能助手,提供陪伴与互动体验。

- VR/AR内容创作:生成4D动画,用于虚拟现实和增强现实中的角色与交互设计。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号