MeteoRA – 南大推出高效可扩展的多任务嵌入框架

MeteoRA是学计算机科学与技术系研究团队开发的一种多任务嵌入框架,专为大型语言模型(LLM)设计。它成功将多种任务特定的LoRA(低秩适配器)集成于单一基础模型中,实现了高效的参数复用和无缝的任务切换。

MeteoRA是什么

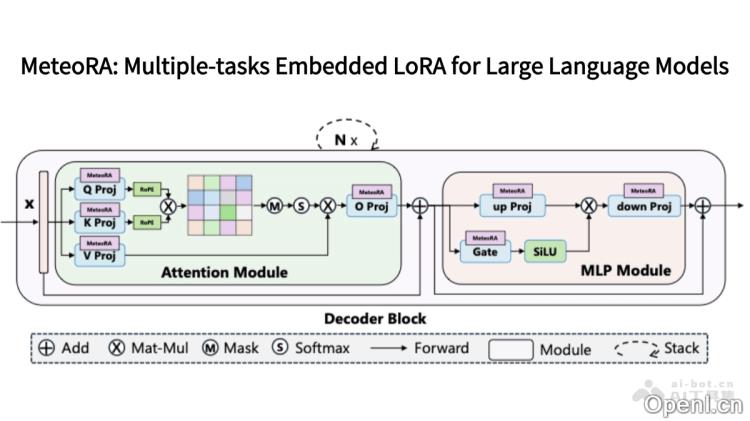

MeteoRA是学计算机科学与技术系研究团队推出的多任务嵌入框架,旨在优化大型语言模型(LLM)的性能。该框架将多个任务特定的LoRA(低秩适配器)整合到一个基础模型中,促进了高效的参数复用及自主任务切换。MeteoRA基于混合专家(MoE)架构,利用可训练的门控网络动态选择最适合当前输入的LoRA适配器,无需外部任务指令。此外,MeteoRA提出了一种MoE前向加速策略,通过自定义的GPU算子显著提升推理效率,同时保持低内存占用。在各类实验中,MeteoRA在多项任务上表现出了与传统微调方法相媲美的性能,尤其在复合任务处理方面表现优异,能够在一次推理中解决多个子问题。

MeteoRA的主要功能

- 多任务适配器集成:将多种任务专用的LoRA(低秩适配器)嵌入到一个基础LLM中,能够同时处理多样化任务。

- 自主任务选择与切换:无需人工输入任务意图,实现自动任务切换。

- 高效推理:提升多任务适配器的推理效率,同时保持低内存需求。

- 复合任务处理:在一次推理中解决多个子任务,例如连续回答不同领域的问题,增强模型的灵活性与实用性。

- 扩展性:支持多种LoRA适配器的集成,适应不同任务和领域,拓展LLM的应用范围。

MeteoRA的技术原理

- LoRA(Low-Rank Adaptation):一种高效的微调方法,通过在LLM的线性层中注入低秩矩阵(A和B)进行调整,仅更新适应特定任务的矩阵,而不改变基础模型的其他参数。每个LoRA适配器由一对低秩矩阵组成,用于调节模型的输出。

- 混合专家(MoE)架构:基于MoE架构,将不同的LoRA适配器视为各自的“专家”,由可训练的门控网络动态选择最适合当前输入的专家(LoRA适配器)。门控网络根据输入的隐藏状态计算每个LoRA的权重,选择权重最高的几个适配器进行前向传播。

- 动态门控机制:门控网络为每个输入动态分配权重,以决定哪些LoRA适配器参与计算。支持根据top-k选择策略选择多个适配器,实现任务的灵活切换与组合。

- 前向加速策略:基于PyTorch和Triton推出的自定义GPU算子,通过并行化和优化内存访问,显著提升多任务推理的速度,同时保持低内存占用。

- 全模式集成:将LoRA适配器嵌入Transformer架构的所有线性层(包括注意力模块和MLP模块),更全面地利用不同任务所蕴含的知识。

MeteoRA的项目地址

- GitHub仓库:https://github.com/NJUDeepEngine/meteora

- arXiv技术论文:https://arxiv.org/pdf/2405.13053

MeteoRA的应用场景

- 多领域问答:整合各个领域的知识,自动切换适配器,以精准回答各类问题。

- 多语言对话:支持多种语言的翻译,促进流畅的多语言交流。

- 复合任务处理:解决包含多个子任务的复杂问题,通过动态切换适配器完成任务。

- 跨领域知识融合:结合来自不同领域的知识,提升对复杂任务的处理能力。

- 智能客服与助手:根据用户需求动态切换适配器,快速响应,提高服务质量。

常见问题

- MeteoRA的适用范围有哪些?:MeteoRA适用于需要处理多任务的场景,如智能客服、多领域问答和多语言对话等。

- 如何获取MeteoRA的使用指南?:您可以访问MeteoRA的GitHub仓库,获取详细的使用说明和文档。

- MeteoRA能否在特定领域进行定制?:是的,MeteoRA支持多种LoRA适配器的集成,能够根据特定领域进行定制化调整。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号