VideoGrain – 悉尼科技大学和浙大推出的视频编辑框架

VideoGrain是什么

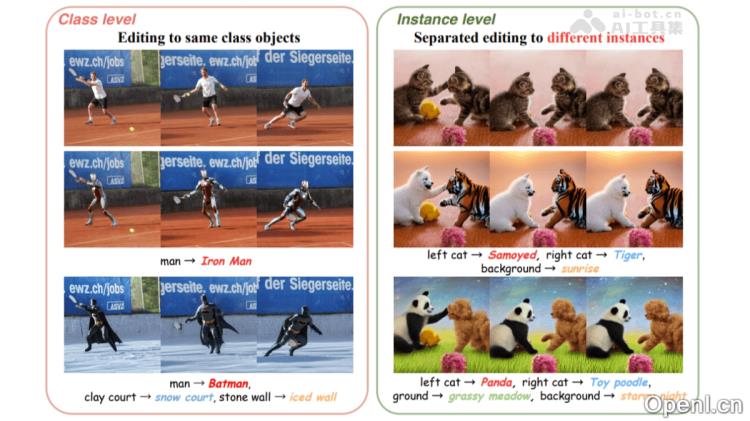

VideoGrain是由悉尼科技大学与浙江大合开发的一款零样本多粒度视频编辑框架,能够实现对视频的类别级、实例级和部件级的精细化修改。该框架结合了调节时空交叉注意力与自注意力机制,显著增强了文本提示对目标区域的控制能力,并确保区域特征之间的分离,从而有效解决了现有扩散模型中存在的语义错位和特征耦合问题。VideoGrain无需额外的参数调整,能够在真实场景中提供高质量的视频编辑效果,并保持时间的一致性。与现有的T2I和T2V方法相比,VideoGrain在多粒度编辑任务中表现更为优异,为视频创作提供了更灵活且精确的工具。

VideoGrain的主要功能

- 多粒度视频编辑:允许用户针对视频中的不同对象进行分类编辑(例如将一名角色转变为“蜘蛛侠”,而另一名角色则变为“北极熊”),或局部修改对象(如改变服装颜色或添加配饰)。

- 文本驱动的区域控制:通过自然语言提示,精确控制视频中特定区域,实现理想的编辑效果。

- 时间一致性:在编辑过程中,确保视频的时间连贯性,避免因编辑而引起的帧间闪烁或不自然的过渡效果。

- 无需参数调整:作为一款零样本编辑工具,VideoGrain不需要对模型进行额外的训练或参数调整。

- 高效计算性能:在测试中表现出较低的内存占用和较快的编辑速度,非常适合实时视频编辑的应用。

VideoGrain的技术原理

- 交叉注意力调节:通过调节交叉注意力层,增强文本提示对目标区域的聚焦能力,同时抑制无关区域的注意力。该机制将文本提示与视频帧的空间区域绑定,通过调整查询-键对的注意力权重,使文本特征集中在相应区域,实现精准的文本到区域的控制。

- 自注意力调节:在自注意力层中,增强区域内特征的自注意力,减少区域间的干扰。这样可以避免因类别特征耦合而导致的编辑错误(例如将不同实例视作同一类别),确保每个查询只关注其目标区域,从而保持特征的分离与编辑的性。

VideoGrain的项目地址

- 项目官网:https://knightyxp.github.io/VideoGrain

- GitHub仓库:https://github.com/knightyxp/VideoGrain

- HuggingFace模型库:https://huggingface.co/papers/2502.17258

- arXiv技术论文:https://arxiv.org/pdf/2502.17258

VideoGrain的应用场景

- 影视制作:快速替换角色、修改场景或添加特效,显著提升后期制作的效率。

- 广告营销:灵活调整产品、人物或背景,快速适应不同的广告需求。

- 内容创作:为视频创作者提供创意工具,轻松添加特效、修改场景或角色。

- 教育培训:增强教学视频的效果,通过内容修改来吸引学生的注意力。

- 互动娱乐:实时修改游戏预告片或互动视频内容,提升用户的体验感。

常见问题

- VideoGrain是否支持所有视频格式?:VideoGrain支持多种常见视频格式,具体支持格式请查看项目官网的文档。

- 如何获取VideoGrain?:您可以通过访问项目官网或GitHub仓库下载和使用VideoGrain。

- 使用VideoGrain需要什么样的计算设备?:VideoGrain在低内存占用的情况下运行良好,适合大多数现代计算设备。

- VideoGrain是否适合初学者使用?:VideoGrain设计上考虑了用户友好性,非常适合初学者进行视频编辑。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号