AI 直接基于用户的意图推理目标,而无需明确的物体描述。

原标题:ICLR 2025|AI不语,只是一味根据人类意图推理3D空间定位

文章来源:机器之心

内容字数:4290字

机器之心AIxiv专栏报道:基于意图的3D目标检测新突破

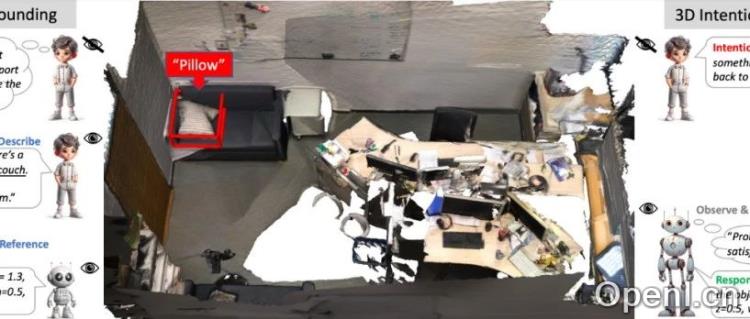

机器之心AIxiv专栏持续报道全球顶尖AI研究成果。本文介绍一篇最新论文,该研究提出了一种新颖的3D意图定位(3D-IG)任务,并设计了相应的IntentNet模型,显著提升了基于自然语言指令的3D目标检测性能。

1. 3D意图定位:超越传统3D视觉定位

以往的3D视觉定位(3D-VG)依赖用户提供明确的目标描述,例如目标类别或空间关系。然而,在实际应用中,用户往往会用意图表达需求,例如“我想找个东西靠着,缓解背部压力”。 这篇文章提出的3D-IG任务,旨在根据用户的意图语句直接在3D场景中定位目标物体,无需用户提供精确的物体描述,更贴近真实人机交互场景。相比于2D意图推理,3D-IG利用3D数据更完整地反映了现实世界的几何和空间信息,更能满足实际需求。

2. Intent3D数据集与基准模型

为了推动3D-IG研究,研究人员构建了Intent3D数据集,包含44,990条意图文本,涵盖209类物体,基于1,042个ScanNet点云场景。该数据集的意图文本由GPT-4生成并经人工审核,保证了数据质量和多样性。为了评估模型性能,研究人员选取了BUTD-DETR、EDA、3D-VisTA和Chat-3D-v2等基准模型,并进行了从头训练、微调和零样本测试。

3. IntentNet模型:多技术融合的意图理解与目标检测

研究人员设计了IntentNet模型来解决3D-IG问题。该模型融合了以下关键技术:动宾对齐(Verb-Object Alignment)、候选框匹配(Candidate Box Matching)和级联自适应学习(Cascaded Adaptive Learning)。动宾对齐帮助模型理解意图中的动词和宾语关系;候选框匹配在稀疏的3D点云中高效匹配目标;级联自适应学习根据不同损失函数的优先级调整权重,提升模型性能。IntentNet的架构包含基于PointNet++的点特征提取、RoBERTa文本编码、基于注意力的多模态融合以及最终的候选框预测。

4. 显著的实验结果

实验结果表明,IntentNet显著优于所有基准模型。与验证集上第二佳方法相比,IntentNet在Top1-Acc@0.25和Top1-Acc@0.5指标上分别提升了11.22%和8.05%;在AP@0.25和AP@0.5指标上分别提升了9.12%和5.43%。测试集上的结果也显示了类似的显著改进。

5. 结论

这项研究提出了一个具有挑战性的3D意图定位任务,并构建了相应的Intent3D数据集和IntentNet模型。实验结果证明了该方法的有效性,为基于自然语言指令的3D目标检测研究提供了新的方向,并有望推动智能体、自动驾驶、AR/VR等领域的发展。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号