字节跳动开源AIBrix:为大语言模型推理加速赋能

在人工智能飞速发展的今天,大语言模型(LLM)的推理效率成为企业能否有效利用AI的关键因素。近日,字节跳动开源了其全新推理系统AIBrix,为解决这一难题提供了强有力的工具。AIBrix专注于vLLM推理引擎的优化,旨在构建一个可扩展、经济高效的推理控制平面,以满足企业日益增长的AI需求。

AIBrix:一个为企业级需求量身打造的解决方案

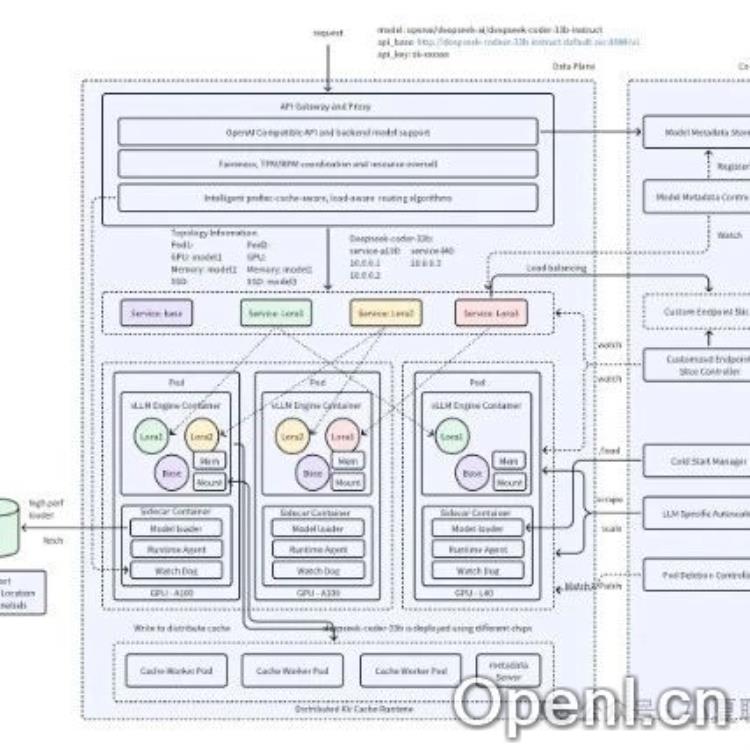

AIBrix的开源标志着大语言模型推理基础设施建设迈入了新的阶段。它并非只是一个简单的工具,而是一个全面的云原生解决方案,涵盖了LLM的部署、管理和扩展的全生命周期。 团队致力于通过开源协作,为构建更强大的推理基础设施奠定坚实的基础,并为企业提供更高效的服务。

核心功能:高效、灵活、易用

首个版本的AIBrix已经具备了若干核心功能,这些功能共同确保了系统的效率和易用性。其中最值得关注的是:

- 高密度LoRA管理:AIBrix简化了轻量级模型适配(LoRA)的管理,方便用户轻松地管理和应用各种模型。

- LLM和路由:该系统提供高效的LLM和路由功能,能够智能地管理和分配多个模型和副本的流量,确保每个请求都能快速准确地到达目标模型。

- LLM应用自动扩展器:根据实时需求动态调整推理资源,提升系统灵活性和响应速度,避免资源浪费,并确保系统在高负载情况下也能保持稳定运行。

这些功能的组合,使得AIBrix能够有效地应对大语言模型推理中常见的挑战,例如模型管理复杂、资源分配不均以及响应速度慢等。

未来展望:持续优化,精益求精

字节跳动AIBrix团队并未止步于此,他们规划了清晰的未来发展方向,致力于不断提升系统的性能和功能。未来的改进计划包括:扩展分布式KV缓存以提升数据访问速度;引入传统的资源管理原则,优化资源利用率;并基于性能分析来进一步提高计算效率。这些努力将使得AIBrix在未来的大语言模型推理领域中发挥更加重要的作用。

总而言之,AIBrix的开源为大语言模型的应用和发展带来了新的机遇。它不仅提供了一个高效的推理解决方案,更重要的是,它开启了开源协作的新篇章,将推动整个行业朝着更可扩展、更经济高效的方向发展。

联系作者

文章来源:小夏聊AIGC

作者微信:

作者简介:专注于人工智能生成内容的前沿信息与技术分享。我们提供AI生成艺术、文本、音乐、视频等领域的最新动态与应用案例。每日新闻速递、技术解读、行业分析、专家观点和创意展示。期待与您一起探索AI的无限潜力。欢迎关注并分享您的AI作品或宝贵意见。

粤公网安备 44011502001135号

粤公网安备 44011502001135号