X-Dancer – 字节等机构推出音乐驱动的人像舞蹈视频生成框架

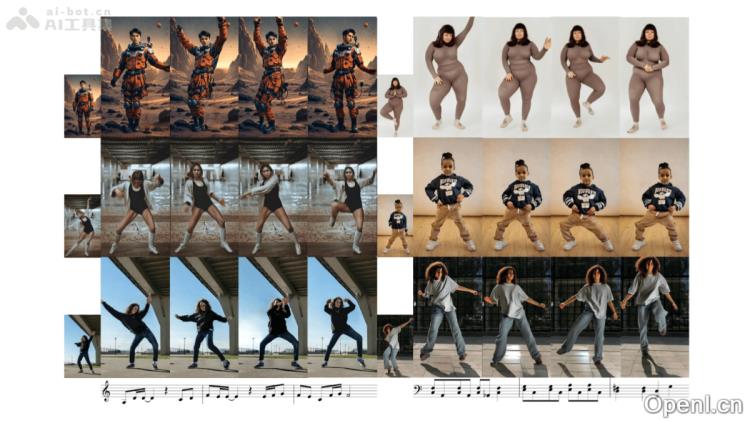

X-Dancer是一款由字节跳动与加州大学圣地亚哥分校和南加州大学的研究团队共同开发的创新性音乐驱动人像舞蹈视频生成框架。它能够通过一张静态图像生成多样化且逼真的全身舞蹈视频,巧妙结合了自回归变换器(Transformer)和扩散模型,以2D人体姿态建模为基础,捕捉舞蹈动作与音乐节奏之间复杂的对齐关系。

X-Dancer是什么

X-Dancer是一种先进的舞蹈视频生成框架,能够从单张静态人物图像和一段音乐中生成与音乐节奏同步的全身舞蹈视频。该框架利用自回归变换器和扩散模型,基于2D人体姿态估计,能够有效地从广泛可用的单目视频中提取舞蹈动作,进而实现舞蹈动作与音乐节奏的精准对齐。X-Dancer通过多部分的2D姿态表示与信心感知的量化方法,生成与音乐相辅相成的舞蹈姿态序列,并利用扩散模型将这些姿态序列转化为流畅的视频帧。相比现有技术,X-Dancer在多样性、音乐对齐和视频质量等方面表现更为优越,支持不同体型和风格的参考图像,且具备零样本生成和特定编舞的微调能力。

X-Dancer的主要功能

- 从单张静态图像生成舞蹈视频:通过提供一张人物图像和一段音乐,生成与音乐节奏完美同步的全身舞蹈视频。

- 多样化与个性化的舞蹈动作:支持多种风格和复杂动作的生成,包括头部、手部等细节动作,适应不同体型和风格的人物动画。

- 音乐节奏对齐:舞蹈动作与音乐节奏紧密结合,精准捕捉音乐的节拍与风格。

- 零样本生成与定制化:具备零样本生成能力,能够针对特定编舞风格进行微调,以满足不同舞蹈需求。

- 高质量视频合成:生成的视频具有高分辨率和逼真的视觉效果,确保与参考图像的一致性。

X-Dancer的技术原理

- 姿态建模:通过2D人体姿态估计从单目视频中提取舞蹈动作,避免了3D姿态估计的复杂性与数据限制。

- 多部分姿态量化:将人体分为多个部分(如上半身、下半身、头部、双手),分别编码为姿态标记(tokens),并通过共享解码器组合成完整姿态。

- 自回归变换器:利用类似GPT的自回归模型,依据音乐特征和历史姿态信息预测未来的姿态标记序列,确保与音乐的同步。

- 扩散模型合成:生成的姿态标记通过可训练的解码器转换为空间引导信号,结合参考图像特征,基于扩散模型生成连贯的舞蹈视频。

- AdaIN与时空模块:采用自适应实例归一化(AdaIN)和时空模块,确保生成视频的时空一致性和身份连贯性。

X-Dancer的官网

- arXiv技术论文:https://arxiv.org/pdf/2502.17414

X-Dancer的应用场景

- 社交媒体分享:用户可以将照片与音乐结合,生成个性化舞蹈视频,提升社交平台内容的趣味性。

- 虚拟角色动画:为虚拟现实和元宇宙中的角色生成同步舞蹈动作,增强其表现力。

- 音乐游戏互动:实时生成舞蹈动作,提升音乐节奏游戏的视觉效果与互动性。

- 广告宣传:结合品牌音乐生成舞蹈视频,用于广告推广,以吸引用户的关注。

- 舞蹈教育:生成各类风格的舞蹈视频,辅助舞蹈教学或展示文化特色。

常见问题

- 如何使用X-Dancer?:用户只需上传一张人物图像并选择相应的音乐,即可生成个性化的舞蹈视频。

- X-Dancer支持哪些视频格式?:X-Dancer支持多种常见视频格式,确保生成的视频可以在各大平台上播放。

- 生成的视频质量如何?:X-Dancer生成的视频具有高分辨率和逼真的视觉效果,适合多种应用场景。

- 是否可以进行定制化?:用户可以针对特定编舞风格进行微调,满足不同的舞蹈需求。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号