SuperGPQA – 豆包大模型联合 M-A-P 开源的知识推理基准测试集

SuperGPQA是什么

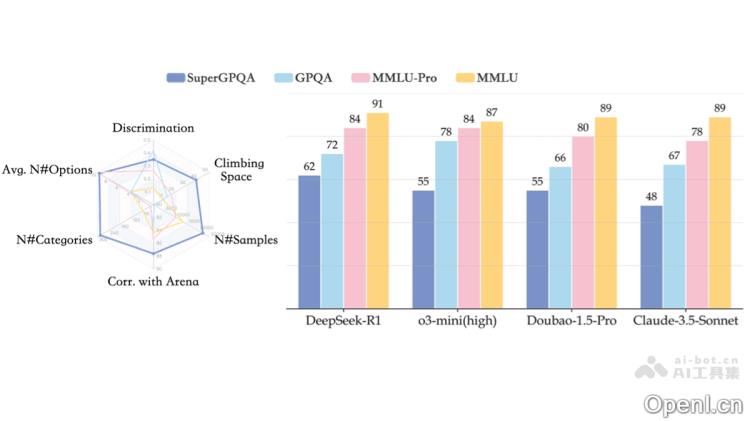

SuperGPQA 是由字节跳动豆包大模型团队与 M-A-P 联合推出的一个全面的知识推理基准测试集,涵盖 285 个研究生级学科,包含多达 26529 道专业题目。该项目旨在解决传统评测基准在学科覆盖不足、题目质量参差不齐及评测维度单一等方面的问题。通过专家与大语言模型的协同构建,SuperGPQA 确保了题目的高质量与高难度,并且包括了 STEM 和非 STEM 学科,其中有 42.33% 的题目涉及数学计算或严谨推理,能够有效评估大语言模型的泛化能力及真实推理水平。

SuperGPQA的主要功能

- 全面评估大语言模型(LLM)的泛化能力:SuperGPQA 覆盖 285 个研究生级学科,包括长尾学科,能够全面衡量 LLM 在各领域的知识储备与推理能力。

- 揭示模型的真实推理能力:42.33% 的题目需要进行数学计算或形式推理,确保测试集能够有效评估模型在复杂任务中的表现,而不仅仅是知识的记忆。

- 提供跨学科分析框架:SuperGPQA 的广泛学科覆盖,包括 STEM(科学、技术、工程、数学)和非 STEM(哲学、文学、历史等)领域,为研究模型在不同学科中的表现提供统一的评估工具。

- 填补长尾学科评估空白:传统评测集对轻工业、农业、服务科学等长尾学科的覆盖不足,而 SuperGPQA 则通过全面的学科覆盖弥补这一短板。

- 为模型优化提供参考:基于 SuperGPQA 的评测结果,研究人员可以发现模型的不足之处,进而优化模型的架构与训练方法。

SuperGPQA的技术原理

- 专家-LLM 协同构建:

- 来源筛选:专家从可信的来源(如教科书、权威练习网站)中筛选和收集原始问题,以避免众包标注带来的低质量风险。

- 转录与规范化:专家对原始问题进行语言规范化和格式转换,确保所有问题具备统一的学术语言和标准的多项选择题格式。

- 质量检验:通过基于规则的初步过滤、基于 LLM 的质量检测(如有效性、领域相关性评估)以及专家复审,确保题目的高质量与高区分度。

- 多模型协作验证:在质量检验阶段,采用多个先进的 LLM(如 GPT-4、Gemini-flash 等)进行多维度检测,以降低数据泄漏风险,提升题目的可靠性与区分度。

- 跨学科语义结构设计:利用 t-SNE 等可视化技术分析题目的语义结构,确保不同学科领域的语言特色得以保留,同时在工程和科学类问题中保持语义的相似性。

- 高难度任务设计:42.33% 的题目要求数学计算或严谨推理,确保测试集在评估模型处理复杂任务时的有效性,而不仅仅是考察知识的记忆能力。

SuperGPQA的项目地址

- 项目官网:https://supergpqa.github.io/

- GitHub仓库:https://github.com/SuperGPQA/SuperGPQA

- HuggingFace模型库:https://huggingface.co/datasets/m-a-p/SuperGPQA

- arXiv技术论文:https://arxiv.org/pdf/2502.14739

SuperGPQA的应用场景

- 模型性能评估:全面衡量大语言模型在各学科领域的知识与推理能力。

- 模型优化指导:帮助研究者识别模型的不足,优化训练策略。

- 跨学科分析:支持不同学科之间对模型能力的比较研究。

- 教育研究:用于开发智能教育工具以及研究人工智能在教育中的应用。

- 行业应用测试:为智能客服、医疗辅助等行业应用提供有效的测试工具。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号