I2V3D – 香港城市大合微软推出的图像到视频生成框架

I2V3D是什么

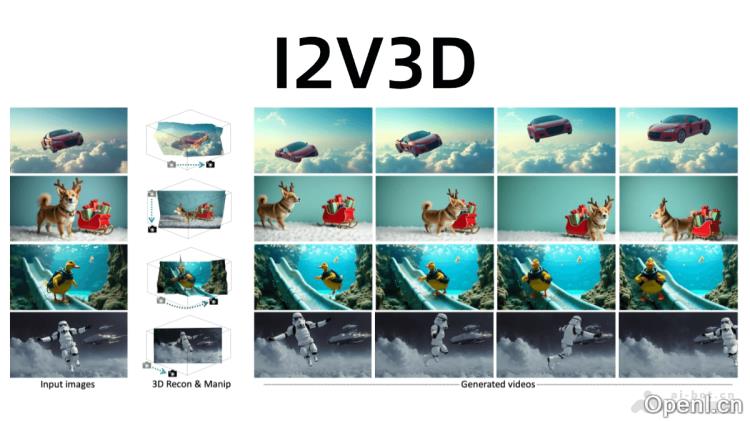

I2V3D是由香港城市大学与微软GenAI合作开发的图像到视频转换框架,旨在将静态图像转化为动态视频。该框架依托3D几何引导,提供精确的动画控制能力。I2V3D融合了传统计算机图形学的精确性与生成式AI模型的视觉真实感,采用两阶段生成流程:首先是3D引导的关键帧生成,其次是视频插值,以实现高质量和可控的视频输出。此工具支持复杂的3D动画和相机,使用户能够从任意起始点创建动画,并生成任意长度的视频序列,显著降低了创作门槛,简化了视频生成过程,为动画制作、视频编辑及内容创作等领域提供了高效且灵活的解决方案。

I2V3D的主要功能

- 静态图像转换为动态视频:能够将单一静态图像转化为具备动态效果的视频,支持复杂的动画效果及相机。

- 精准的3D动画控制:通过3D引导,实现对动画的精细调控,包括物体的旋转、平移、缩放及相机的(如旋转、平移、变焦等)。

- 灵活的动画起始点设置:支持用户定义动画的起始帧,并可以生成任意长度的视频。

- 复杂场景编辑功能:用户可以在3D场景中添加、复制、替换或编辑对象,创造全新的视频内容。

I2V3D的技术原理

- 3D几何重建:从单张图像中重建完整的3D场景几何结构,覆盖前景对象和背景。前景对象被提取并转化为3D网格,而背景则通过多视图生成与3D网格重建完成。

- 双阶段视频生成流程:

- 3D引导关键帧生成:利用定制的图像扩散模型,以粗糙的渲染结果为引导,生成高质量的关键帧。多视图增强与扩展注意力机制提升模型的泛化能力与时间一致性。

- 3D引导视频插值:在关键帧之间生成平滑和高质量的视频帧,无需训练,采用双向引导(正向与反向)确保视频的时间连贯性。

- 深度引导与特征控制:视频生成过程中,利用深度图和渲染特征(如自注意力特征和卷积特征)作为控制信号,确保生成视频与3D渲染结果保持一致。

- 扩展注意力机制:在关键帧生成阶段,基于扩展注意力机制增强帧与帧之间的时空一致性,避免视频生成中的闪烁或不连贯问题。

I2V3D的项目地址

I2V3D的应用场景

- 动画制作:快速将静态图像转变为动态视频,支持复杂的3D动画,适合广告、游戏等短动画制作。

- 视频编辑与创作:在3D场景中添加、替换或编辑对象,创造富有创意的视频内容,适合短视频及特效预览。

- 虚拟现实/增强现实内容生成:生成逼真的3D动态内容,用于虚拟环境中的交互展示,增强用户的沉浸体验。

- 教育与培训:将静态教学插图转化为动态视频,帮助学生更直观地理解复杂概念。

- 游戏开发:快速生成游戏过场动画或虚拟角色动画,节省开发时间和成本。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号