星辰语义大模型官网

2024年1月,中国电信正式开源星辰语义大模型-7B,同时开源的还有超 1T 的高质量清洗基础数据。

开源项目链接地址:

- https://openi.pcl.ac.cn/openihu/tele-chat

- https://gitee.com/Tele-AI/tele-chat

- https://github.com/Tele-AI/Telechat

- https://huggingface.co/Tele-AI/telechat-7B

星辰语义大模型的开源方案

在千亿参数大模型发布之前,星辰语义大模型已经具备了多版本稳定可用的大模型基座,覆盖 3B、7B、12B 和 130B 等参数量级。大模型采用纯自研方式,AI 团队选用解码器架构( decoder-only )并在模型维度做了一些创新和改进。经过数十版模型训练与优化,模型的稳定性和推理速度都得到了明显提升。

根据开源服务的对象不同,星辰语义大模型的开源方案也分两种——对内方案和对外方案。对外方案中,7B 模型在 Gitee 和 Github 同步开源,支持商用。对内方案中,开源对象包括 3B、7B 和 12B 模型。代码在研发云进行托管。模型使用二方包方式进行托管,权限采用项目申请关联方式。

开源的模型数量和时间有所不同,但开源内容并无区别。比如,提供基础模型以及基于相应版本的对话模型、不仅支持传统的全量参数更新还支持 LoRA 等只更新部分参数的高效微调方法、支持 deepspeed 微调、支持 int8、int4 量化和昇腾卡训练推理。

长文本处理是星辰语义大模型的一个亮点。开源模型支持外推长度达 96K,有助于模型在训练与推理阶段捕获更多上下文信息,特别是在引入外部知识做搜索增强的应用场景。

同时开放的还有超 1T 高质量清洗的基础数据,是由星辰大模型预训练语料中抽取出的综合性大规模中文数据集。数据主要来源于网页、书籍、官方媒体等媒介,数据集大约公开了 2.7 亿条数据,由纯中文文本构成。据电信 AI 透露,这些数据在 7B、12B 还有未来开源的千亿级大模型都会用到。

相关新闻:

星辰语义大模型开源交流群

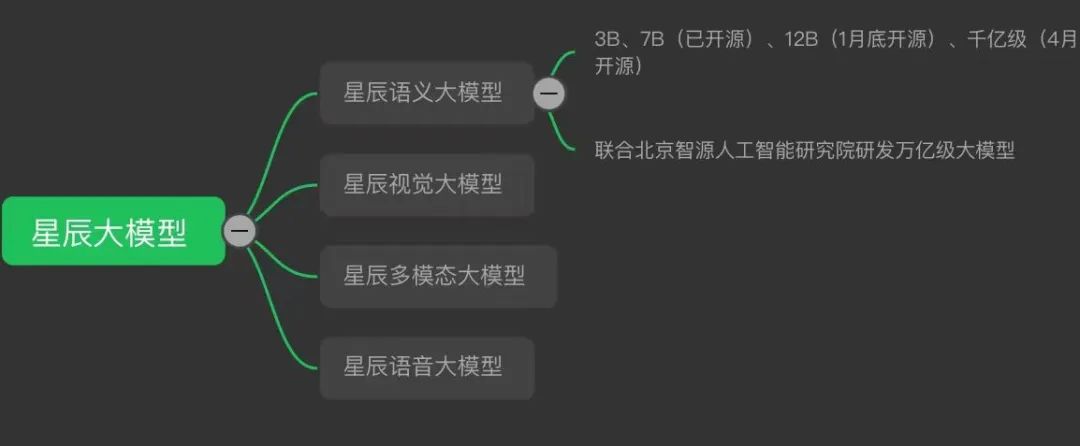

星辰大模型矩阵

星辰语义大模型-3B并不在开源的对外方案中

星辰语义大模型通用能力一览

中国电信正式发布星辰语义大模型

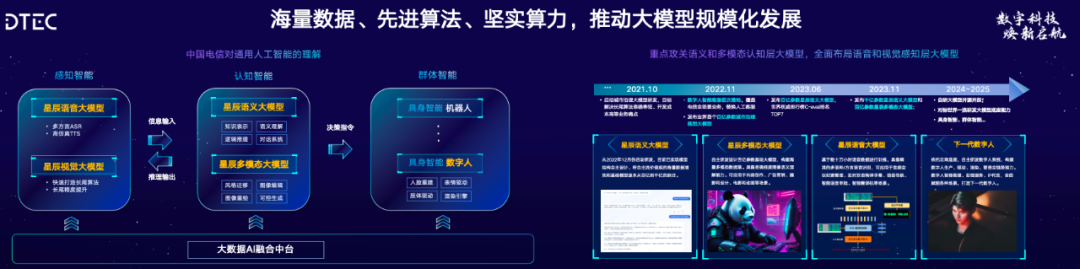

2023 年数字科技生态大会人工智能与数据产业发展合作论坛论坛上,中国电信正式发布了”星辰语义大模型“的千亿参数版本,在推理和回答准确性方面都有显著提升,并将上下文窗口提到了 96K Token。中国电信首次提出了缓解多轮幻觉的解决方案,使得大模型的幻觉率降低了 40%。

与此同时,中国电信还宣布将加入到开源开放的行列中,预计今年年底开源百亿级别的大模型,明年 4 月则会开源千亿级别的大模型,旨在让更多研究者和开发者从中受益。此外,中国电信还将根据星辰大模型构建各种工具链,以满足不同用户的需求。

多轮幻觉的解决方案

中国电信千亿参数星辰语义大模型在业界首次提出了缓解多轮幻觉的解决方案,将模型幻觉率降低了 40%。这一方案包括四项关键技术:

关键信息注意力增强技术:通过对关键信息进行注意力增强,可以提升模型理解能力和答案回复一致性的能力,较大程度缓解模型幻觉问题;

知识图谱强化:通过知识图谱确保训练数据集知识事实性,并通过知识图谱知识提示能力辅助模型知识问答能力提升,大幅降低模型幻觉,提高通用问答准确率。

多轮知识记忆和强化技术:通过采用更优模型知识记忆方案,以及关联信息的强化训练方案,增强了模型上下文记忆能力和关联知识理解能力,增强了上下文回复一致性,降低了模型幻觉问题;

知识溯源能力:通过多种湖源方式,关联问题相关参考出处,生成答案更加可靠。

数据评估

本站OpenI提供的星辰语义大模型都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2023年 11月 14日 下午8:26收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号