Switch Transformers by Google Brain官网

Switch Transformers是一种用于扩展到万亿参数模型的模型,通过简单和高效的稀疏性实现了对大规模语言模型的训练和预训练加速。

网站服务:生产效率,深度学习,自然语言处理,商业AI,生产效率,深度学习,自然语言处理。

Switch Transformers by Google Brain简介

In deep learning, models typically reuse the same parameters for all inputs. Mixture of Experts (MoE) defies this and instead selects different parameters for each incoming example. The result is a sparsely-activated model — with outrageous numbers of parameters — but a constant computational cost. However, despite several notable successes of MoE, widespread adoption has been hindered by complexity, communication costs and training instability — we address these with the Switch Transformer. We simplify the MoE routing algorithm and design intuitive improved models with reduced communication and computational costs. Our proposed training techniques help wrangle the instabilities and we show large sparse models may be trained, for the first time, with lower precision (bfloat16) formats. We design models based off T5-Base and T5-Large to obtain up to 7x increases in pre-training speed with the same computational resources. These improvements extend into multilingual settings where we measure gains over the mT5-Base version across all 101 languages. Finally, we advance the current scale of language models by pre-training up to trillion parameter models on the "Colossal Clean Crawled Corpus" and achieve a 4x speedup over the T5-XXL model.

什么是”Switch Transformers by Google Brain”?

本文介绍了一种名为Switch Transformers的模型,该模型通过简单和高效的稀疏性实现了对万亿参数模型的扩展。通过选择不同的参数来处理每个输入示例,Switch Transformers实现了稀疏激活模型,具有大量的参数但恒定的计算成本。

“Switch Transformers by Google Brain”有哪些功能?

1. 简化的MoE路由算法:Switch Transformers简化了Mixture of Experts(MoE)的路由算法,减少了复杂性和通信成本。

2. 降低通信和计算成本:Switch Transformers设计了直观的改进模型,减少了通信和计算成本。

3. 改进的训练技术:Switch Transformers提供了一些训练技术,帮助解决训练不稳定的问题,并展示了可以使用更低精度(bfloat16)格式训练大型稀疏模型的能力。

应用场景:

Switch Transformers可应用于各种深度学习任务,特别是自然语言处理和机器翻译领域。它可以用于训练大规模的语言模型,提高预训练速度,并在多语言环境中取得更好的效果。

“Switch Transformers by Google Brain”如何使用?

Switch Transformers可以通过下载论文中提供的代码和数据集来使用。用户可以根据自己的需求进行模型的训练和预训练,并将其应用于各种深度学习任务中。

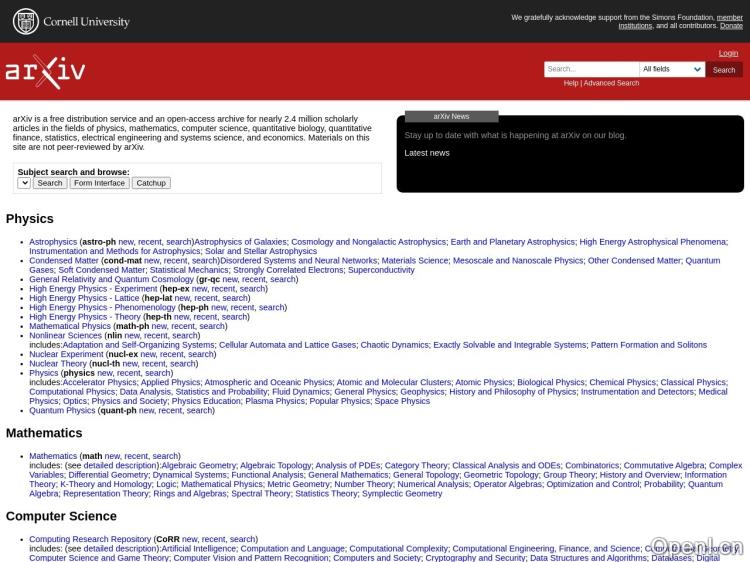

Switch Transformers by Google Brain官网入口网址

https://arxiv.org/abs/2101.03961

OpenI小编发现Switch Transformers by Google Brain网站非常受用户欢迎,请访问Switch Transformers by Google Brain网址入口试用。

数据评估

本站OpenI提供的Switch Transformers by Google Brain都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2024年 4月 18日 上午8:00收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号