Segment Anything

Segment Anything,model,github,论文,meta sam AI图像分割模型

标签:ai工具导航 AI训练模型meta sam Segment Anything Segment-AnythingSegment Anything官网,model,github,论文,meta sam AI图像分割模型

什么是Segment Anything?

最近 Meta 提出的分割一切模型(Segment Anything Model,SAM)突破了分割界限,极大地促进了计算机视觉基础模型的发展。SAM 是一个提示型模型,其在 1100 万张图像上训练了超过 10 亿个掩码,实现了强大的零样本泛化。许多研究人员认为「这是 CV 的 GPT-3 时刻,因为 SAM 已经学会了物体是什么的一般概念,甚至是未知的物体、不熟悉的场景(如水下、细胞显微镜)和模糊的情况」,并展示了作为 CV 基本模型的巨大潜力。

Segment Anything官网: https://segment-anything.com/

Segment Anything论文: https://arxiv.org/abs/2304.02643

Segment Anything github项目地址:

https://github.com/facebookresearch/segment-anything

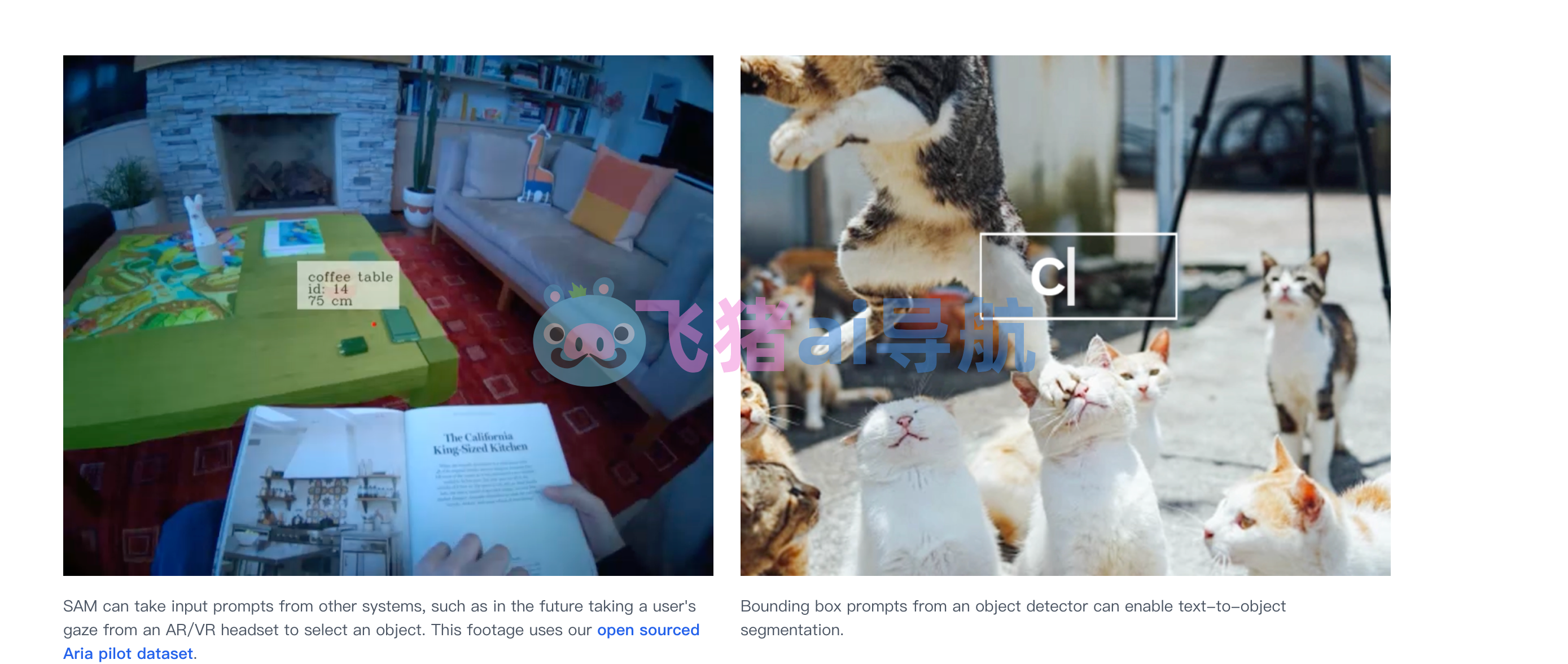

Segment Anything 做为Facebook 推出的object分割模型(SAM)和数据集(SA-1B),万物可分割。基于NLP的思路,SAM提出了promp的交互的概念,即通过提示返回有效的mask,提示如point, box等,可以用于下游任务。

Segment Anything使用方法

Segment Anything(SA)项目:一种新的图像分割任务、模型和数据集。在数据采集循环中使用我们的高效模型,我们建立了迄今为止最大的分割数据集,在1100万许可和尊重隐私的图像上有超过10亿个掩码。该模型被设计和训练为可提示的,因此它可以将zero-shot transfer零样本迁移到新的图像分布和任务。我们评估了它在许多任务上的能力,并发现它的零样本性能令人印象深刻,通常与之前的完全监督的结果相当,甚至更优。我们正在发布Segment Anything Model(SAM)和相应的数据集(SA-1B),其中包含10亿个掩码和1100万个图像,以促进计算机视觉基础模型的研究。

Segment Anything(SA)项目:一种新的图像分割任务、模型和数据集。在数据采集循环中使用我们的高效模型,我们建立了迄今为止最大的分割数据集,在1100万许可和尊重隐私的图像上有超过10亿个掩码。该模型被设计和训练为可提示的,因此它可以将zero-shot transfer零样本迁移到新的图像分布和任务。我们评估了它在许多任务上的能力,并发现它的零样本性能令人印象深刻,通常与之前的完全监督的结果相当,甚至更优。我们正在发布Segment Anything Model(SAM)和相应的数据集(SA-1B),其中包含10亿个掩码和1100万个图像,以促进计算机视觉基础模型的研究。

Segment Anything借助了NLP任务中的Prompt思路,通过给图像分割任务提供一下Prompt提示来完成任意目标的快速分割。提示可以是前景/背景点集、粗略的框或遮罩、任意形式的文本或者任何指示图像中需要进行分割的信息。该任务的输入是原始的图像和一些提示语,输出是图片中不同目标的掩码信息。

Segment Anything借助了NLP任务中的Prompt思路,通过给图像分割任务提供一下Prompt提示来完成任意目标的快速分割。提示可以是前景/背景点集、粗略的框或遮罩、任意形式的文本或者任何指示图像中需要进行分割的信息。该任务的输入是原始的图像和一些提示语,输出是图片中不同目标的掩码信息。

数据评估

本站OpenI提供的Segment Anything都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2023年 6月 15日 下午5:18收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号