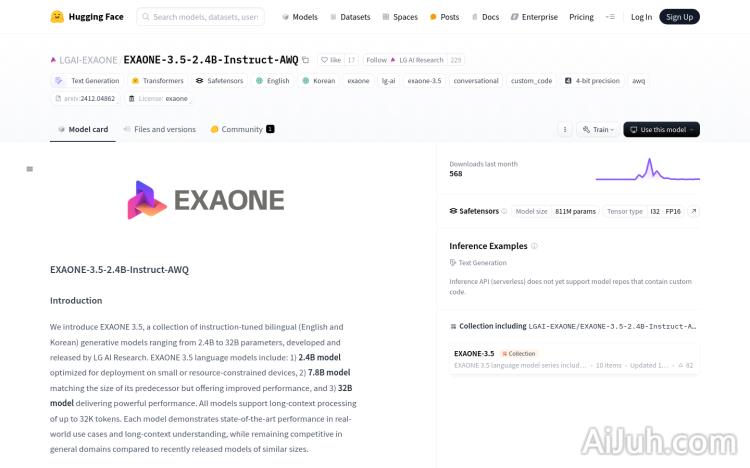

EXAONE-3.5-2.4B-Instruct-AWQ官网

EXAONE-3.5-2.4B-Instruct-AWQ是由LG AI Research开发的一系列双语(英语和韩语)指令调优生成模型,参数范围从2.4B到32B。这些模型支持长达32K令牌的长上下文处理,并且在真实世界用例和长上下文理解方面展现出最先进的性能,同时在与近期发布的类似大小模型相比,在通用领域保持竞争力。该模型在部署到小型或资源受限设备上进行了优化,并且采用了AWQ量化技术,实现了4位群组权重量化(W4A16g128)。

EXAONE-3.5-2.4B-Instruct-AWQ是什么

EXAONE-3.5-2.4B-Instruct-AWQ是由LG AI Research开发的一款双语(英语和韩语)大型语言模型。它属于EXAONE系列,参数规模为2.4B,但通过AWQ量化技术(4位群组权重量化),实现了在资源受限设备上的高效部署。该模型支持长达32K token的长文本处理,在长文本理解和真实世界应用场景中表现出色,并在通用领域保持了与同等规模模型的竞争力。

EXAONE-3.5-2.4B-Instruct-AWQ主要功能

EXAONE-3.5-2.4B-Instruct-AWQ的主要功能是文本生成。它能够根据输入的提示生成高质量的英语和韩语文本,支持多种应用场景,例如对话生成、长文本摘要、问答等。其长上下文处理能力使其能够理解和处理更长的文本序列,这在处理复杂的文档或长对话时非常有用。此外,该模型还支持多种部署框架,方便开发者在不同平台上进行部署。

如何使用EXAONE-3.5-2.4B-Instruct-AWQ

使用EXAONE-3.5-2.4B-Instruct-AWQ需要一定的编程基础。开发者需要安装必要的库,例如transformers和autoawq。然后,使用AutoModelForCausalLM和AutoTokenizer加载模型和分词器。准备输入提示(英文或韩文),使用tokenizer.apply_chat_template方法将消息模板化并转换为输入ID。调用model.generate方法生成文本,最后使用tokenizer.decode方法将生成的ID解码为文本。开发者可以根据需要调整模型参数,例如max_new_tokens和do_sample,来控制生成文本的长度和多样性。

EXAONE-3.5-2.4B-Instruct-AWQ产品价格

目前,关于EXAONE-3.5-2.4B-Instruct-AWQ的具体价格信息并未公开。建议访问LG AI Research的官方网站或联系其相关人员获取详细信息。

EXAONE-3.5-2.4B-Instruct-AWQ常见问题

该模型的训练数据包含哪些内容? LG AI Research并未公开具体的训练数据来源和细节,但可以推测其包含了大量的英语和韩语文本数据,以支持其双语能力和长文本理解能力。

与其他同等规模的模型相比,EXAONE-3.5-2.4B-Instruct-AWQ的优势是什么? 该模型的优势在于其在资源受限设备上的优化部署能力和长达32K token的长上下文处理能力,这在移动端或边缘计算场景下具有显著的优势。

如何评估EXAONE-3.5-2.4B-Instruct-AWQ的性能? 可以使用标准的语言模型评估指标,例如困惑度(perplexity)和BLEU分数,来评估模型的性能。此外,还可以针对具体的应用场景设计自定义的评估指标。

EXAONE-3.5-2.4B-Instruct-AWQ官网入口网址

https://huggingface.co/LGAI-EXAONE/EXAONE-3.5-2.4B-Instruct-AWQ

OpenI小编发现EXAONE-3.5-2.4B-Instruct-AWQ网站非常受用户欢迎,请访问EXAONE-3.5-2.4B-Instruct-AWQ网址入口试用。

数据评估

本站OpenI提供的EXAONE-3.5-2.4B-Instruct-AWQ都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 9日 上午9:54收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号