glider-gguf官网

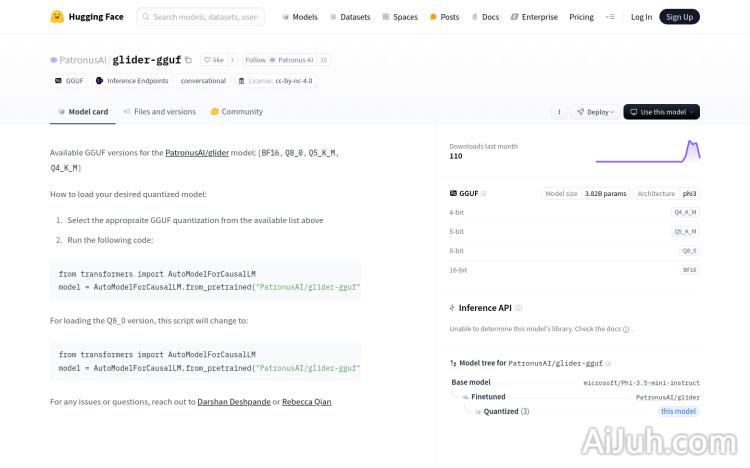

PatronusAI/glider-gguf是一个基于Hugging Face平台的高性能量化语言模型,采用GGUF格式,支持多种量化版本,如BF16、Q8_0、Q5_K_M、Q4_K_M等。该模型基于phi3架构,拥有3.82B参数,主要优点包括高效的计算性能和较小的模型体积,适用于需要快速推理和低资源消耗的场景。产品背景信息显示,该模型由PatronusAI提供,适合需要进行自然语言处理和文本生成的开发者和企业使用。

PatronusAI/glider-gguf是什么

PatronusAI/glider-gguf是一个基于Hugging Face平台的轻量级、高性能量化语言模型。它采用GGUF格式,支持多种量化级别(BF16、Q8_0、Q5_K_M、Q4_K_M等),模型参数为3.82B,基于phi3架构。其优势在于高效的推理速度和较小的模型体积,非常适合资源受限的场景,例如移动端或嵌入式设备上的部署。

PatronusAI/glider-gguf主要功能

glider-gguf的主要功能是进行自然语言处理任务,包括文本生成和语言理解。它可以用于构建机器人、生成各种类型的文本内容(新闻、社交媒体帖子等),以及优化搜索引擎的语义理解能力。

PatronusAI/glider-gguf使用方法

使用glider-gguf非常简单,只需几行代码即可完成模型加载和使用。首先,选择合适的GGUF量化版本;然后,使用Hugging Face Transformers库加载模型:`from transformers import AutoModelForCausalLM; model = AutoModelForCausalLM.from_pretrained(“PatronusAI/glider-gguf”,gguf_file=”glider_{version_from_list}.gguf”)`,其中`{version_from_list}`替换为选择的量化版本(例如Q8_0);最后,使用加载的模型进行文本生成或其他NLP任务。

PatronusAI/glider-gguf产品价格

目前,关于PatronusAI/glider-gguf的具体价格信息并未公开。建议访问Hugging Face平台或联系PatronusAI获取更多信息。

PatronusAI/glider-gguf常见问题

哪些量化级别对性能影响最小? 这取决于你的硬件和具体的应用场景。建议尝试不同的量化级别,并根据实际测试结果选择最佳的平衡点。更高精度的量化级别(如BF16)通常会带来更好的性能,但模型体积也会更大。

如何选择合适的GGUF量化版本? 这取决于你的硬件资源和对模型性能的要求。如果你的硬件资源有限,可以选择低精度量化版本,例如Q4_K_M或Q5_K_M;如果性能更重要,可以选择高精度量化版本,例如BF16或Q8_0。 你可以通过实验来确定哪个版本最适合你的应用。

如果遇到问题在哪里寻求帮助? 你可以访问Hugging Face社区寻求帮助,或者联系PatronusAI团队的Darshan Deshpande或Rebecca Qian。

glider-gguf官网入口网址

https://huggingface.co/PatronusAI/glider-gguf

OpenI小编发现glider-gguf网站非常受用户欢迎,请访问glider-gguf网址入口试用。

数据评估

本站OpenI提供的glider-gguf都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 9日 上午10:04收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号