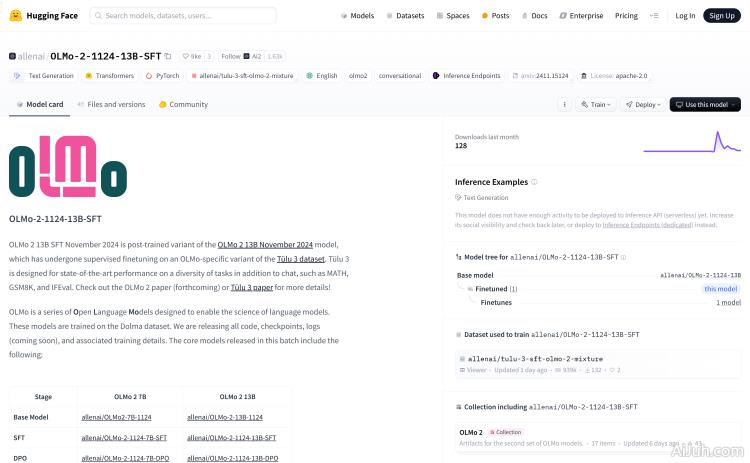

OLMo-2-1124-13B-SFT官网

OLMo-2-1124-13B-SFT是由Allen AI研究所开发的一个大型语言模型,经过在特定数据集上的监督微调,旨在提高在多种任务上的表现,包括、数学问题解答、文本生成等。该模型基于Transformers库和PyTorch框架,支持英文,拥有Apache 2.0的开源许可证,适用于研究和教育用途。

OLMo-2-1124-13B-SFT是什么

OLMo-2-1124-13B-SFT是由Allen AI研究所开发的一个大型语言模型。它基于Transformers库和PyTorch框架,经过监督微调,能够胜任多种任务,例如文本生成、、数学问题解答等。该模型支持英文,拥有Apache 2.0开源许可证,主要面向自然语言处理领域的研究者、开发者和教育机构。

OLMo-2-1124-13B-SFT主要功能

OLMo-2-1124-13B-SFT 的核心功能在于其强大的文本生成能力和多任务处理性能。它可以用于:生成高质量文本内容、进行流畅的对话、解答数学问题、辅助技术文档或文章的撰写等。 其多任务处理能力使其在各种自然语言处理场景中都具有良好的适用性。

如何使用OLMo-2-1124-13B-SFT

使用OLMo-2-1124-13B-SFT非常便捷。首先,你需要访问Hugging Face网站并搜索该模型。然后,使用提供的代码片段加载模型:from transformers import AutoModelForCausalLM; olmo_model = AutoModelForCausalLM.from_pretrained("allenai/OLMo-2-1124-13B-SFT")。之后,你可以根据需要调整模型参数,进行微调或直接使用,用于文本生成或其他NLP任务。记住,在使用过程中,请遵守Apache 2.0开源许可证。

OLMo-2-1124-13B-SFT产品价格

OLMo-2-1124-13B-SFT是一个开源模型,因此它是免费使用的。 但是,使用该模型可能需要一定的计算资源,这取决于你的应用场景和使用规模。

OLMo-2-1124-13B-SFT常见问题

该模型的计算资源需求如何? 这取决于你的应用场景。对于简单的文本生成任务,可能只需要一台普通的电脑即可。但是,对于更复杂的应用或大规模部署,则可能需要更强大的计算资源,例如GPU集群。

如何对OLMo-2-1124-13B-SFT进行微调? 你可以使用Hugging Face提供的工具和文档来进行微调。这需要一定的编程技能和对深度学习的了解。 Hugging Face 提供了丰富的教程和示例,可以帮助你快速上手。

OLMo-2-1124-13B-SFT支持哪些语言? 目前主要支持英文,但由于其是大型语言模型,未来可能会有更多语言支持。

OLMo-2-1124-13B-SFT官网入口网址

https://huggingface.co/allenai/OLMo-2-1124-13B-SFT

OpenI小编发现OLMo-2-1124-13B-SFT网站非常受用户欢迎,请访问OLMo-2-1124-13B-SFT网址入口试用。

数据评估

本站OpenI提供的OLMo-2-1124-13B-SFT都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 9日 上午10:34收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号