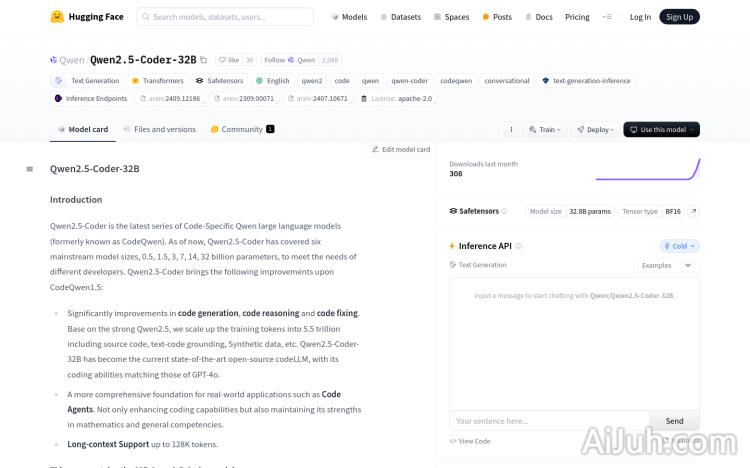

Qwen2.5-Coder-32B官网

Qwen2.5-Coder-32B是基于Qwen2.5的代码生成模型,拥有32亿参数,是目前开源代码语言模型中参数最多的模型之一。它在代码生成、代码推理和代码修复方面有显著提升,能够处理长达128K tokens的长文本,适用于代码代理等实际应用场景。该模型在数学和通用能力上也保持了优势,支持长文本处理,是开发者在进行代码开发时的强大助手。

Qwen2.5-Coder-32B是什么?

Qwen2.5-Coder-32B是一个强大的开源代码生成模型,拥有320亿参数,是目前参数量最大的开源代码模型之一。它基于Qwen2.5模型构建,在代码生成、推理和修复方面表现出色,能够处理长达128K tokens的超长文本,堪称开发者代码开发的得力助手。其在数学和通用能力方面也保持了较高的水平。

Qwen2.5-Coder-32B的主要功能

Qwen2.5-Coder-32B的主要功能包括:代码生成、代码推理、代码修复和长文本处理。它能够根据用户的需求生成新的代码片段,帮助开发者理解和维护现有代码,修复代码中的错误,并处理大型项目中的长文本代码。此外,它还具备一定的数学和通用能力。

如何使用Qwen2.5-Coder-32B?

使用Qwen2.5-Coder-32B非常便捷:首先,访问Hugging Face平台,搜索Qwen2.5-Coder-32B模型;其次,仔细阅读模型文档,了解模型配置和使用方法;然后,根据项目需求调整模型参数,特别是处理长文本时需要关注YaRN配置;接下来,使用Hugging Face提供的API或将模型集成到本地开发环境;最后,输入代码相关的查询或任务,模型将生成相应的代码或解决方案,开发者需要根据结果进行必要的调整和优化。

Qwen2.5-Coder-32B的产品价格

由于Qwen2.5-Coder-32B是开源模型,因此它是免费使用的。开发者无需支付任何费用即可访问和使用该模型。

Qwen2.5-Coder-32B的常见问题

Qwen2.5-Coder-32B的性能如何与其他大型语言模型相比? Qwen2.5-Coder-32B在代码生成能力上与GPT-4o相当,并在长文本处理方面表现突出,其开源特性使其在易用性和可定制性方面具有优势。

使用Qwen2.5-Coder-32B需要哪些硬件资源? 这取决于你的使用方式。如果使用Hugging Face提供的API,则无需本地硬件资源。如果要在本地运行,则需要强大的GPU资源,具体配置取决于处理文本长度和模型大小。

如何解决Qwen2.5-Coder-32B生成的代码出现错误的情况? Qwen2.5-Coder-32B生成的代码并非总是完美的,需要开发者仔细检查和调试。建议先理解模型生成的代码逻辑,再进行必要的修改和优化,必要时可以结合其他工具进行代码审查。

Qwen2.5-Coder-32B官网入口网址

https://huggingface.co/Qwen/Qwen2.5-Coder-32B

OpenI小编发现Qwen2.5-Coder-32B网站非常受用户欢迎,请访问Qwen2.5-Coder-32B网址入口试用。

数据评估

本站OpenI提供的Qwen2.5-Coder-32B都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 9日 上午11:04收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号