PowerInfer官网

PowerInfer 是一个在个人电脑上利用消费级 GPU 进行高速大型语言模型推理的引擎。它利用 LLM 推理中的高局部性特点,通过预加载热激活的神经元到 GPU 上,从而显著降低了 GPU 内存需求和 CPU-GPU 数据传输。PowerInfer 还集成了自适应预测器和神经元感知的稀疏运算符,优化神经元激活和计算稀疏性的效率。它可以在单个 NVIDIA RTX 4090 GPU 上以平均每秒 13.20 个标记的生成速率进行推理,比顶级服务器级 A100 GPU 仅低 18%。同时保持模型准确性。

PowerInfer是什么?

PowerInfer 是一款在个人电脑上运行大型语言模型(LLM)的推理引擎,它能够充分利用消费级GPU的算力,实现高速、高效的本地推理。不同于需要强大服务器才能运行的传统LLM,PowerInfer 通过优化内存管理和计算方式,使得在普通家用电脑上也能流畅运行大型语言模型,这对于个人开发者或需要本地部署LLM的用户来说非常有吸引力。

PowerInfer的主要功能

PowerInfer 的核心功能是提供高速的LLM推理能力。它通过预加载“热”激活神经元到GPU,减少了CPU和GPU之间的数据传输,并利用稀疏计算等技术来优化计算效率。这意味着更快的响应速度和更低的延迟,用户能够在本地快速获得LLM的输出结果。此外,PowerInfer还兼容常见的ReLU稀疏模型,并支持与llama.cpp相同的模型权重,方便用户迁移和使用已有的模型。

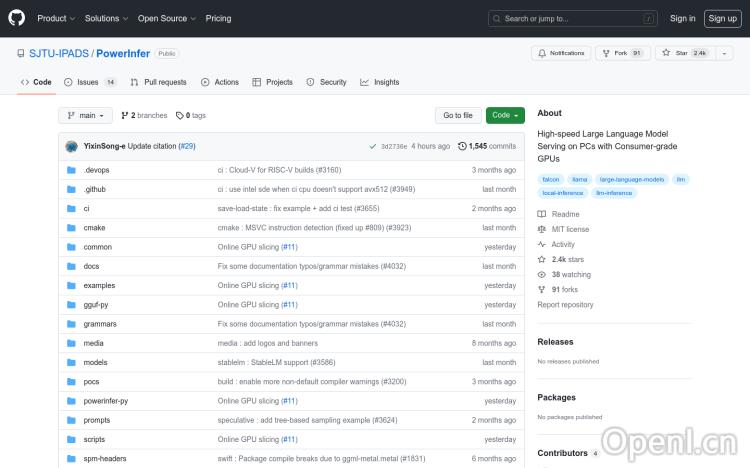

如何使用PowerInfer?

PowerInfer 的具体使用方法需要参考其GitHub项目上的文档和教程。一般来说,你需要先安装PowerInfer,然后加载你想要使用的LLM模型权重。之后,你可以通过PowerInfer提供的接口或API来向模型发送请求,并获取推理结果。由于PowerInfer的GitHub页面提供了详细的安装和使用说明,这里不再赘述具体的步骤。建议用户参考官方文档进行操作。

PowerInfer的价格

PowerInfer 是一款开源软件,完全免费。

PowerInfer常见问题

PowerInfer支持哪些类型的GPU? PowerInfer主要针对NVIDIA的消费级GPU进行优化,具体支持的型号可以在其GitHub页面找到。

PowerInfer对内存的需求是多少? 这取决于你所使用的LLM模型的大小。较大的模型需要更多的GPU内存。建议参考PowerInfer的文档,了解不同模型的内存需求。

PowerInfer的性能与服务器级GPU相比如何? PowerInfer在单个NVIDIA RTX 4090 GPU上的性能与顶级服务器级A100 GPU相比仅低约18%,这表明其性能已经非常出色,能够在消费级硬件上实现接近服务器级性能的LLM推理。

PowerInfer官网入口网址

https://github.com/SJTU-IPADS/PowerInfer

OpenI小编发现PowerInfer网站非常受用户欢迎,请访问PowerInfer网址入口试用。

数据评估

本站OpenI提供的PowerInfer都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 10日 下午3:01收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号