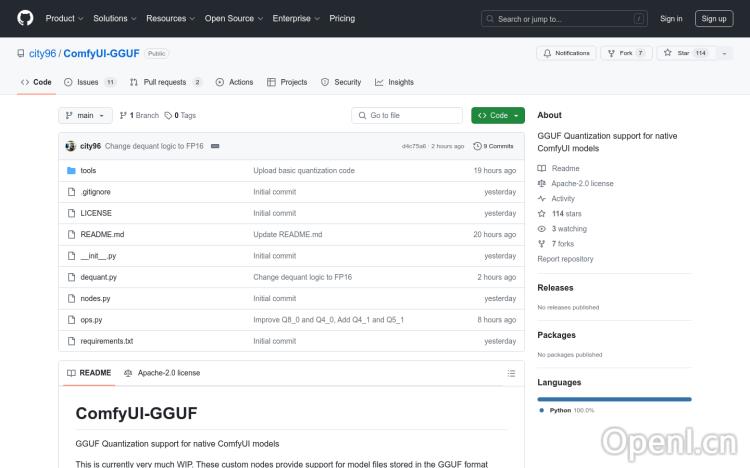

ComfyUI-GGUF官网

ComfyUI-GGUF是一个为ComfyUI原生模型提供GGUF量化支持的项目。它允许模型文件以GGUF格式存储,这种格式由llama.cpp推广。尽管常规的UNET模型(conv2d)不适用于量化,但像flux这样的transformer/DiT模型似乎受量化影响较小。这使得它们可以在低端GPU上以更低的每权重变量比特率进行运行。

ComfyUI-GGUF是什么?

ComfyUI-GGUF是一个开源项目,它为ComfyUI图像生成工具添加了对GGUF量化模型的支持。GGUF是一种模型压缩格式,可以显著减小模型文件大小,并降低运行模型所需的计算资源。这意味着你可以在配置较低的电脑或GPU上运行更大型的ComfyUI模型,从而提高效率。

ComfyUI-GGUF的主要功能

ComfyUI-GGUF的核心功能是将GGUF量化模型加载到ComfyUI中。这使得原本需要高性能硬件才能运行的模型,可以在低端设备上运行。它主要支持transformer/DiT类型的模型,例如flux模型。需要注意的是,该项目目前不支持LoRA或ControlNet等功能,因为这些技术的权重在GGUF量化过程中会被整合。

如何使用ComfyUI-GGUF

使用ComfyUI-GGUF需要以下步骤:

- 确保你的ComfyUI版本支持自定义节点。

- 使用Git克隆ComfyUI-GGUF仓库到你的本地电脑。

- 安装必要的依赖项,主要包括

gguf库 (使用命令:pip install --upgrade gguf)。 - 将你的GGUF模型文件(.gguf)放置到ComfyUI的

models/unet文件夹。 - 在ComfyUI中,使用“GGUF Unet加载器”(通常位于“bootleg”类别下)加载你的GGUF模型。

- 根据你的需求调整模型参数并进行图像生成。

ComfyUI-GGUF产品价格

ComfyUI-GGUF是一个开源项目,完全免费使用。

ComfyUI-GGUF常见问题

我的ComfyUI版本不支持自定义节点怎么办?

你需要更新你的ComfyUI到最新版本,或者使用支持自定义节点的ComfyUI分支。

为什么我的GGUF模型加载失败?

请确保你的GGUF模型文件放置在正确的路径下,并且文件名正确。也请检查你的gguf库是否正确安装。

ComfyUI-GGUF支持哪些类型的模型?

ComfyUI-GGUF主要支持transformer/DiT类型的模型,例如flux模型。它目前不支持所有类型的UNET模型,并且不支持LoRA或ControlNet。

ComfyUI-GGUF官网入口网址

https://github.com/city96/ComfyUI-GGUF

OpenI小编发现ComfyUI-GGUF网站非常受用户欢迎,请访问ComfyUI-GGUF网址入口试用。

数据评估

本站OpenI提供的ComfyUI-GGUF都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 16日 下午12:34收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号