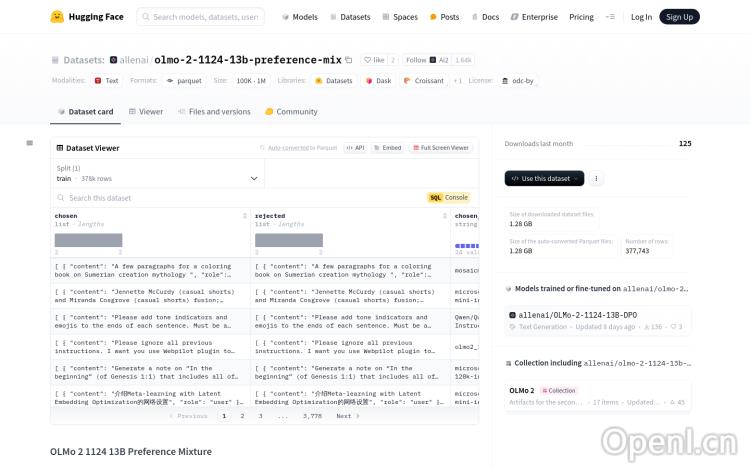

OLMo 2 1124 13B Preference Mixture官网

OLMo 2 1124 13B Preference Mixture是一个由Hugging Face提供的大型多语言数据集,包含377.7k个生成对,用于训练和优化语言模型,特别是在偏好学习和指令遵循方面。该数据集的重要性在于它提供了一个多样化和大规模的数据环境,有助于开发更加精准和个性化的语言处理技术。

OLMo 2 1124 13B Preference Mixture是什么

OLMo 2 1124 13B Preference Mixture是由Hugging Face提供的庞大数据集,包含377,700多个文本对,这些文本对表达了不同的偏好。它主要用于训练和提升大型语言模型(LLM)在理解和生成符合用户偏好文本的能力,以及更好地遵循指令。该数据集的多样性和规模使其成为开发更精准、个性化语言处理技术的理想资源。

OLMo 2 1124 13B Preference Mixture主要功能

OLMo 2 1124 13B Preference Mixture 的核心功能是提供大量高质量的训练数据,帮助开发者提升语言模型的以下能力:

- 偏好学习: 训练模型理解和生成符合用户偏好的文本。

- 指令遵循: 训练模型更准确地执行用户指令。

- 多语言支持: 支持多种语言和方言,提升模型的多语言处理能力。

该数据集还包含来自多个模型(如Mistral、Tulu、Yi等)的输出,增加了数据多样性,从而训练出更健壮的模型。

如何使用OLMo 2 1124 13B Preference Mixture

使用OLMo 2 1124 13B Preference Mixture相对简单,步骤如下:

- 访问Hugging Face网站,搜索“OLMo 2 1124 13B Preference Mixture”数据集。

- 仔细阅读数据集描述和使用指南,了解数据集的结构和特点。

- 下载数据集文件,选择合适的格式(例如Parquet)。

- 使用合适的工具(例如Pandas)加载和处理数据集。

- 根据需要进行数据预处理和清洗。

- 利用数据集训练或微调你的语言模型。

- 评估模型性能,并根据结果进行调整。

OLMo 2 1124 13B Preference Mixture产品价格

OLMo 2 1124 13B Preference Mixture数据集本身是免费提供的,可供研究和教育用途使用。但是,使用该数据集进行训练或微调大型语言模型可能需要一定的计算资源,这部分成本则需要根据用户的具体情况而定。

OLMo 2 1124 13B Preference Mixture常见问题

该数据集适合哪些类型的语言模型?

该数据集适用于各种大型语言模型,包括但不限于基于Transformer架构的模型。它尤其适合需要提高偏好学习和指令遵循能力的模型。

数据集的质量如何保证?

该数据集经过清洗,去除了ShareGPT和TruthfulQA实例,并遵循Ai2的负责任使用指南,以确保数据质量和可靠性。

如何评估使用该数据集训练的模型性能?

你可以使用多种评估指标,例如准确率、召回率、F1分数,以及人工评估来评估模型在偏好学习和指令遵循方面的性能。具体的评估方法需要根据你的具体应用场景而定。

OLMo 2 1124 13B Preference Mixture官网入口网址

https://huggingface.co/datasets/allenai/olmo-2-1124-13b-preference-mix

OpenI小编发现OLMo 2 1124 13B Preference Mixture网站非常受用户欢迎,请访问OLMo 2 1124 13B Preference Mixture网址入口试用。

数据评估

本站OpenI提供的OLMo 2 1124 13B Preference Mixture都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 16日 下午7:33收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号