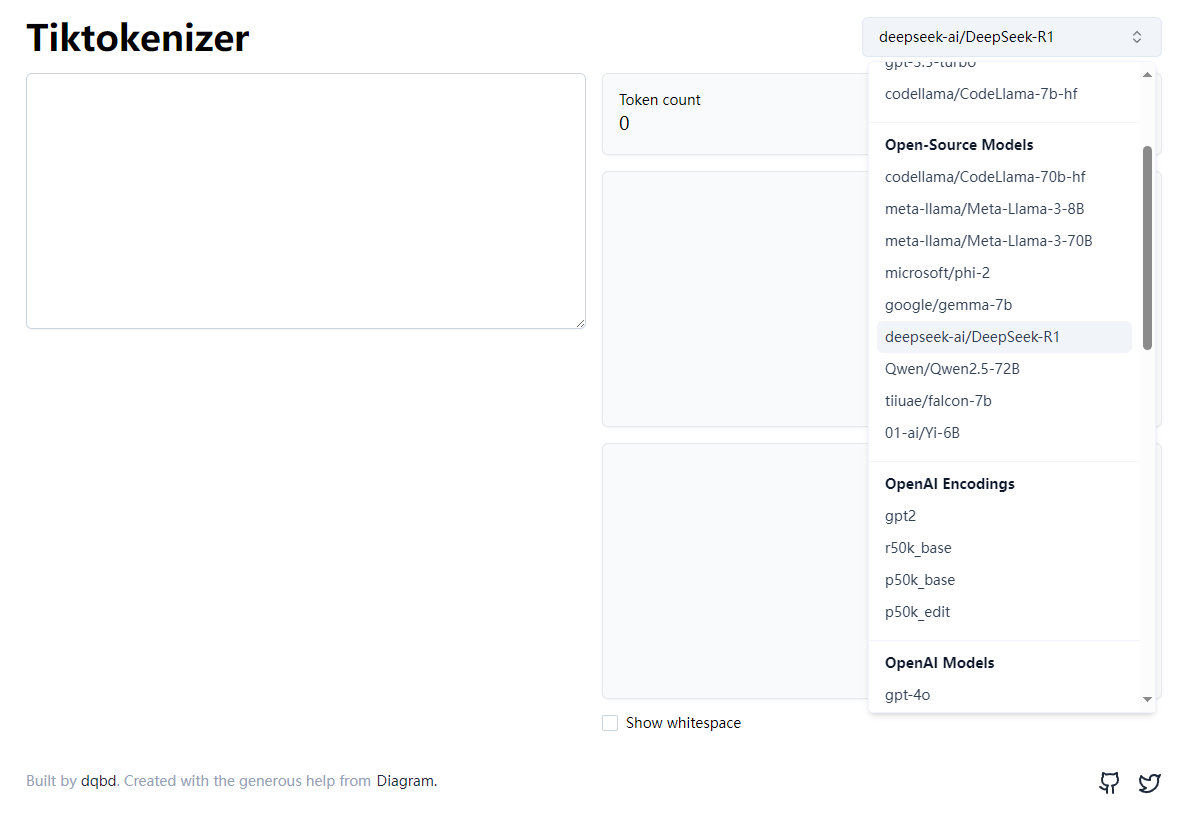

Tiktokenizer官网

Tiktokenizer是一个计算给定大模型提示词的tokens数量的开源项目,最初的功能主要功能是帮助用户计算OpenAI计费规则中每次请求所用的tokens数量(不包括返回的tokens),现在已经扩展了近几十个大模型。

- Tiktokenizer官网入口地址:https://tiktokenizer.vercel.app/

- Tiktokenizer开源项目地址:https://github.com/dqbd/tiktokenizer/

目前支持下列模型:

Popular

- cl100k_base

- o200k_base

- gpt-4-1106-preview

- gpt-3.5-turbo

- codellama/CodeLlama-7b-hf

Open-Source Models

- codellama/CodeLlama-70b-hf

- meta-llama/Meta-Llama-3-8B

- meta-llama/Meta-Llama-3-70B

- microsoft/phi-2

- google/gemma-7b

- deepseek-ai/DeepSeek-R1

- Qwen/Qwen2.5-72B

- tiiuae/falcon-7b

- 01-ai/Yi-6B

OpenAI Encodings

- gpt2

- r50k_base

- p50k_base

- p50k_edit

OpenAI Models

- gpt-4o

- gpt-4

- gpt-4-32k

- text-davinci-003

- text-davinci-002

- text-davinci-001

- text-curie-001

- text-babbage-001

- text-ada-001

- davinci

- curie

- babbage

- ada

- code-davinci-002

- code-davinci-001

- code-cushman-002

- code-cushman-001

- davinci-codex

- cushman-codex

- text-davinci-edit-001

- code-davinci-edit-001

- text-similarity-davinci-001

- text-similarity-curie-001

- text-similarity-babbage-001

- text-similarity-ada-001

- text-search-davinci-doc-001

- text-search-curie-doc-001

- text-search-babbage-doc-001

- text-search-ada-doc-001

- code-search-babbage-code-001

- code-search-ada-code-001

- text-embedding-ada-002

- text-embedding-3-small

- text-embedding-3-large

数据评估

关于Tiktokenizer特别声明

本站OpenI提供的Tiktokenizer都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 3月 14日 下午5:49收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

相关导航

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号