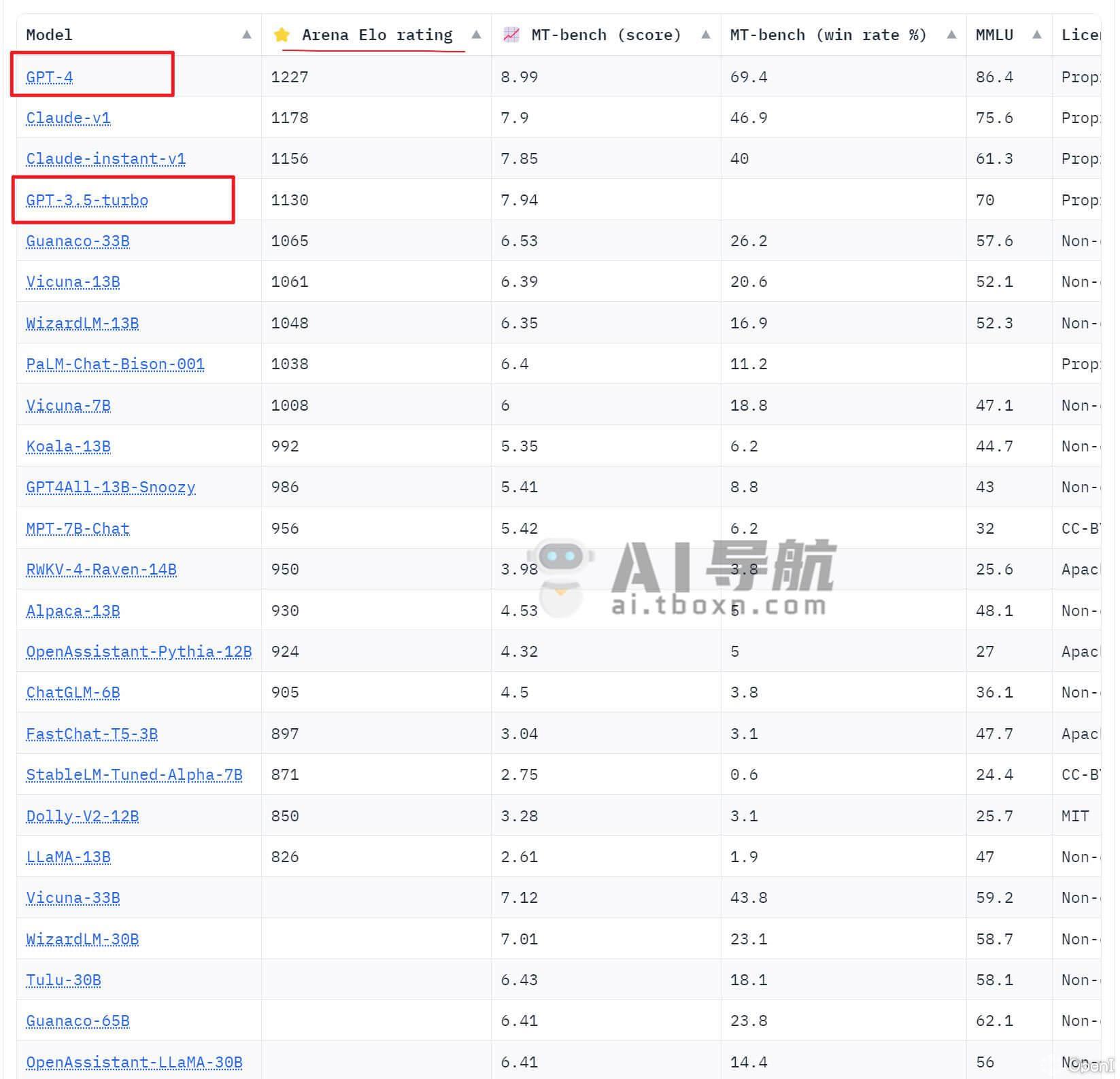

Chatbot Arena 也被成为机器人竞技场,它是由LMSYS Org 创建的一个 大语言模型(LLM)对比竞技平台,通过对比后并将这个大语言模型(LLM)进行排名。最新一期大语言模型(LLM)排行榜出炉,GPT4 依旧是独领,排在第二位的是 Claude-v1 模型,GPT 3.5 turbo 排名第四。 目前该平台通过三种评分机制,来对比哪个机器人实力最强。这三个机制分别是Arena Elo rating 、MT-bench 、MMLU 其中第一个Arena Elo rating 评分系统类似于王者荣耀中的elo匹配机制,它把各家的机器人当做玩家,让他们之间随机对战,通过4万多名用户投票来进行elo评级。

目前该平台通过三种评分机制,来对比哪个机器人实力最强。这三个机制分别是Arena Elo rating 、MT-bench 、MMLU 其中第一个Arena Elo rating 评分系统类似于王者荣耀中的elo匹配机制,它把各家的机器人当做玩家,让他们之间随机对战,通过4万多名用户投票来进行elo评级。

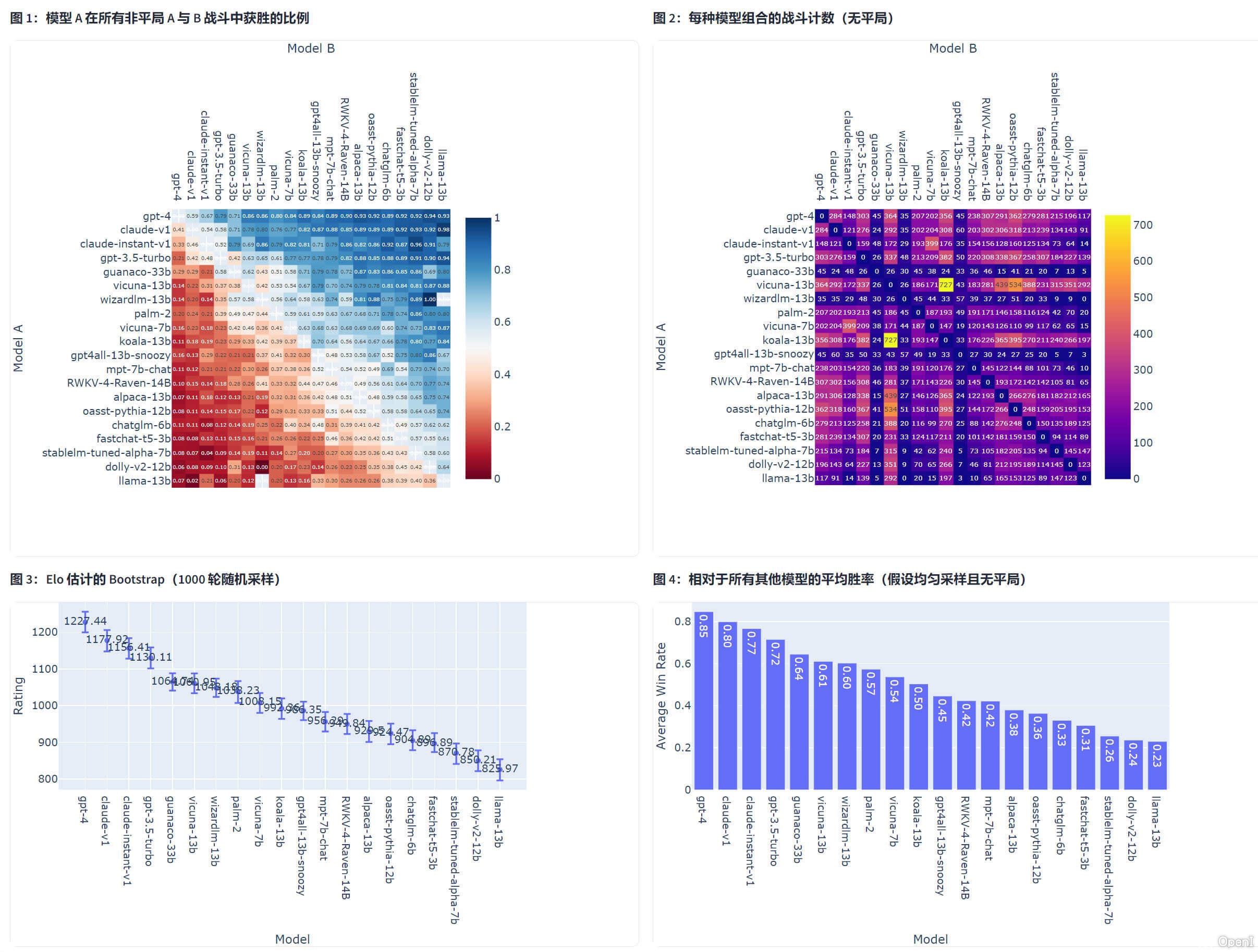

- Chatbot Arena – 一个众包、随机的战斗平台。我们使用 40K+ 用户投票来计算 Elo 评级。

- MT-Bench – 一组具有挑战性的多回合问题。我们使用 GPT-4 对模型响应进行评分。

- MMLU(5-shot)——衡量模型在 57 项任务上的多任务准确性的测试。

数据评估

关于Chatbot Arena特别声明

本站OpenI提供的Chatbot Arena都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2023年 6月 27日 上午2:25收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

相关导航

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号