StoryDiffusion官网

一款由南开大学HVision团队开发的人工智能工具,主要功能包括生成连贯的图像和视频故事,以及漫画生成创作。

网站提供:Ai工具箱,Ai开源项目,StoryDiffusion,漫画,Story,Diffusion。

StoryDiffusion简介

Create Magic Story! Contribute to HVision-NKU/StoryDiffusion development by creating an account on GitHub.

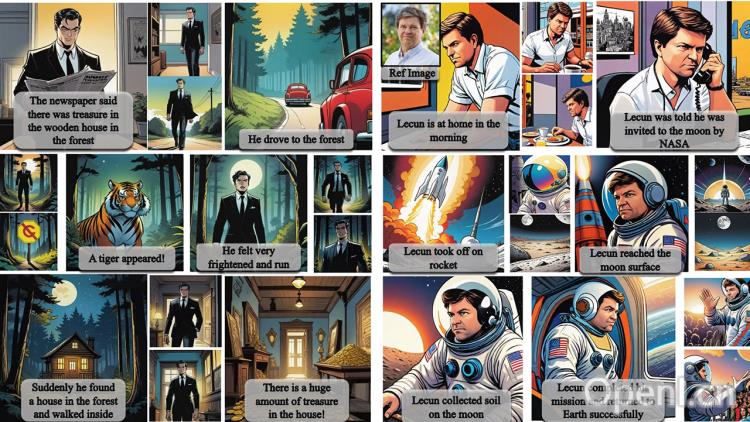

StoryDiffusion 是一款由南开大学HVision团队开发的人工智能工具,主要功能包括生成连贯的图像和视频故事,以及漫画生成创作。StoryDiffusion利用一致性自注意力(Consistent Self-Attention)技术,能够在无需训练的情况下生成主题一致的图像,这些图像可以用于讲述故事或作为后续内容生成的输入。

StoryDiffusion 能够保持角色的一致性,生成多图漫画和长视频,这对于需要连贯叙事的广告、电影等领域尤为重要。

StoryDiffusion主要功能特征:

角色连贯性保持:StoryDiffusion能够通过一致性自注意力机制生成主题一致的图像和视频,确保在多图漫画和长视频中角色风格和服装的一致性,从而实现连贯的故事叙述。

多场景应用:该工具不仅适用于漫画生成,还可以应用于图像转视频等多种场景。用户可以通过提供一系列条件图像,利用Image-to-Video模型生成视频,这对于广告、电影等领域提供了新的创意方式和制作手段。

教育材料设计:教育工作者可以使用StoryDiffusion来设计教育视频或互动故事,这些内容有助于提高学习者的参与度和兴趣。

长范围图像生成功能:特别适合制作连贯的广告故事,增强品牌形象。这种功能使得StoryDiffusion在广告和品牌推广方面具有显著优势。

即插即用无需训练:研究团队将一致性自注意力插入到现有图像生成模型的U-Net架构中,并重用原有的自注意力权重,以保持无需训练和即插即用的特性。

高效能与稳健性:StoryDiffusion在保持角色特性的同时,还能够很好地符合提示描述,显示出其稳健性。这表明该方法在定量指标上取得了最佳性能。

StoryDiffusion通过一致性自注意力机制,不仅能够生成连贯的图像和视频,还能应用于多种实际场景,如教育、广告和娱乐等,同时具备高效能和稳健性。

GitHub 项目:相关项目已经在 GitHub 上获得了 1k 的 Star 量,GitHub 地址为:https://github.com/HVision-NKU/StoryDiffusion。

论文和演示:有关 StoryDiffusion 的更多技术细节和实验结果可以在论文《StoryDiffusion: Consistent Self-Attention for long-range image and video generation》中找到,论文地址为:https://arxiv.org/pdf/2405.01434v1

StoryDiffusion官网入口网址

https://github.com/HVision-NKU/StoryDiffusion

OpenI小编发现StoryDiffusion网站非常受用户欢迎,请访问StoryDiffusion网址入口试用。

数据评估

本站OpenI提供的StoryDiffusion都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2024年 5月 6日 下午9:01收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号